Охота на электроовец целиком

Сергей Марков

Охота на электроовец

Большая книга искусственного интеллекта

Главный редактор Андрей Федичкин

Научный редактор (глубокое обучение) кандидат физико-математических наук, Михаил Бурцев

Научный редактор (биология) доктор биологических наук, Александр Каплан

Литературный редактор Денис Яцутко

Корректоры Ольга Петрова, Галина Лаврик

Иллюстрации: Олег Добровольский

Инфографика: Софья Кравецкая, Алексей Кравецкий

Дизайн переплёта, макет: Артоника — Дмитрий Черногаев, арт-директор; Ксения Гневушева, руководитель проекта; Станислав Новиков, вёрстка и пре-пресс

Общероссийский классификатор продукции

ОК-034-2014 (КПЕС 2008);

58.11.1 — книги, брошюры печатные

Подписано в печать 19.08.2024. Формат 84 × 108 1 ̸16

Бумага офсетная. Гарнитура Noto Serif

Печать офсетная. Усл. печ. л. 35,5

Тираж 1500 экз. Заказ №2193-24

Отпечатано в соответствии с предоставленными материалами

в ООО «Красногорская типография»

143405, Московская область, г. Красногорск, Коммунальный квартал, дом 2.

www.ktprint.ru

Охраняется законом РФ об авторском праве.

ISBN 978-5-600-04012-0

УДК 004.8:004.9

ББК 16.6

М26

© С. Марков, текст, 2024

© О. Добровольский, иллюстрации, 2024

© О. Добровольский, иллюстрации, 2024

© С. Кравецкая, А. Кравецкий, инфографика, 2024

© Артоника, макет, 2024

Сергей Марков — специалист в области искусственного интеллекта и машинного обучения. С конца 1990-х занимается разработкой и руководством проектами, связанными с применением систем ИИ в различных областях человеческой деятельности. Создатель шахматной программы SmarThink (одной из сильнейших отечественных шахматных программ в 2000-е годы). Основатель научно-популярного портала «XX2 век» (22century.ru), автор ряда научных статей и множества научно-популярных лекций, посвящённых теме ИИ. В настоящее время управляющий директор, начальник Управления экспериментальных систем машинного обучения Дивизиона общих сервисов «Салют» ПАО «Сбербанк», где при его непосредственном участии были созданы такие нейросетевые модели, как ruGPT-3, ruGPT-3.5, GigaChat, ruDALL-E Malevich, Kandinsky, mGPT и другие.

Сергей Марков — специалист в области искусственного интеллекта и машинного обучения. С конца 1990-х занимается разработкой и руководством проектами, связанными с применением систем ИИ в различных областях человеческой деятельности. Создатель шахматной программы SmarThink (одной из сильнейших отечественных шахматных программ в 2000-е годы). Основатель научно-популярного портала «XX2 век» (22century.ru), автор ряда научных статей и множества научно-популярных лекций, посвящённых теме ИИ. В настоящее время управляющий директор, начальник Управления экспериментальных систем машинного обучения Дивизиона общих сервисов «Салют» ПАО «Сбербанк», где при его непосредственном участии были созданы такие нейросетевые модели, как ruGPT-3, ruGPT-3.5, GigaChat, ruDALL-E Malevich, Kandinsky, mGPT и другие.

Захватывающая дух история развития искусственного интеллекта от человека, работающего на переднем крае современной науки и разрабатывающего технологии ИИ завтрашнего дня, ещё вчера казавшиеся абсолютной фантастикой.

Дмитрий Ветров, профессор Constructor University, Bremen

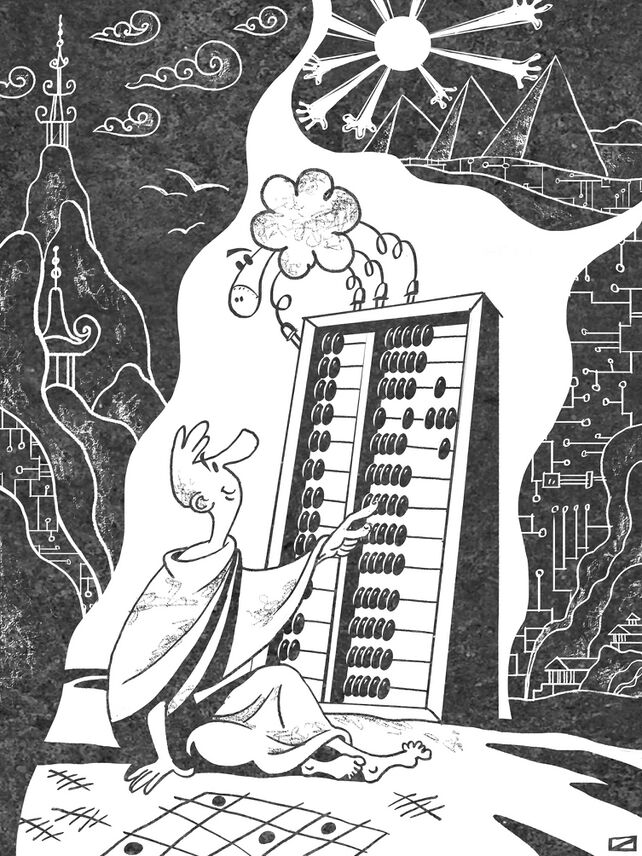

Думаете, это скучная свалка фактов и прописных истин про искусственный интеллект? Как бы не так! Это захватывающий приключенческий роман про то, как человек научился делать себя всё более и более умным при помощи различных вычислителей — от костяшек до микросхем. Чтение затягивает, и незаметно пролетающие сотни страниц мазок за мазком создают грандиозное полотно современного искусственного интеллекта. Доступное изложение самых

важных понятий ИИ переплетено на нём с увлекательной историей их появления, что приводит к удивительному результату — книга будет интересна и юному школьнику, и почтенному академику.

Михаил Бурцев, научный сотрудник Лондонского института математических наук

Книга Сергея Маркова представляет собой уникальную энциклопедию технологий, объединяемых в наше время хорошо всем знакомым термином «искусственный интеллект» (ИИ). Понимая ИИ как набор средств для автоматизации интеллектуальной деятельности, автор разворачивает завораживающую картину создания людьми «умных машин» — от примитивных вычислительных устройств древности до самых современных алгоритмов обучения нейросетей. Написанная одним из ведущих профессионалов в области ИИ, книга сочетает глубину изложения с простотой и понятностью, что делает чтение ценным для ИИ-экспертов и увлекательным для широкого круга читателей, интересующихся современными технологиями, — от школьников до пенсионеров.

Дмитрий Ливанов, д.ф.-м.н., ректор МФТИ

Аннотация

Новый этап в области компьютерных технологий часто называют очередной «весной искусственного интеллекта». Её начало обычно отсчитывают с момента появления нейронной сети, сегодня известной под названием AlexNet, успех которой в распознавании зрительных образов возвестил о начале «революции глубокого обучения». В результате этой революции машинам удалось превзойти человеческий уровень при решении множества задач. Сегодня уже мало кого удивляют победы машин над сильнейшими игроками в го, создание ими музыки и картин, предсказание нейронными сетями пространственной структуры белков и другие вещи, которые десять лет назад мы посчитали бы чудесами. Алгоритмы искусственного интеллекта (ИИ) быстро вошли в нашу жизнь и стали её неотъемлемой частью. Например, каждый раз, когда вы делаете фотографию при помощи смартфона, её обработку выполняет нейронная сеть.

На смену весне искусственного интеллекта приходит лето. Эта книга рассказывает о том, какие события в истории науки привели к началу этого лета, о современных технологиях ИИ и их возможностях, а также пытается приоткрыть завесу, скрывающую от нас мир ближайшего будущего.

Мифы и заблуждения об искусственном интеллекте, страхи, насущные проблемы, перспективные направления исследований — обо всём этом вы узнаете из «Большой книги искусственного интеллекта».

Оглавление

[[#аннотация|Аннотация 4]]

[[#оглавление|Оглавление 5]]

[[#предисловие|Предисловие 12]]

[[#договоримся-об-определениях|1 Договоримся об определениях 14]]

[[#понятие-ии.-прикладнойслабый-ии-сильный-ии-agi|1.1 Понятие ИИ. Прикладной/слабый ИИ, сильный ИИ (AGI) 17]]

[[#тест-тьюринга-китайская-комната-сёрля|1.2 Тест Тьюринга, китайская комната Сёрля 19]]

[[#машинное-обучение-его-виды-и-области-применения|1.3 Машинное обучение, его виды и области применения 25]]

[[#виды-машинного-обучения|1.3.1 Виды машинного обучения 27]]

[[#задачи-решаемые-с-помощью-машинного-обучения|1.3.2 Задачи, решаемые с помощью машинного обучения 29]]

[[#области-применения-машинного-обучения|1.3.3 Области применения машинного обучения 34]]

[[#сквозь-тьму-веков.-история-думающих-машин|2 Сквозь тьму веков. История думающих машин 36]]

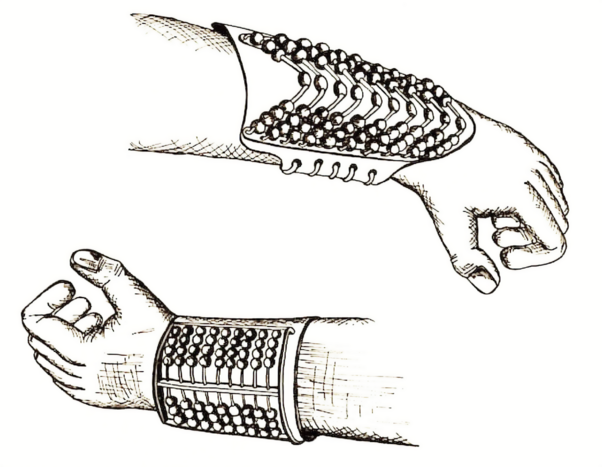

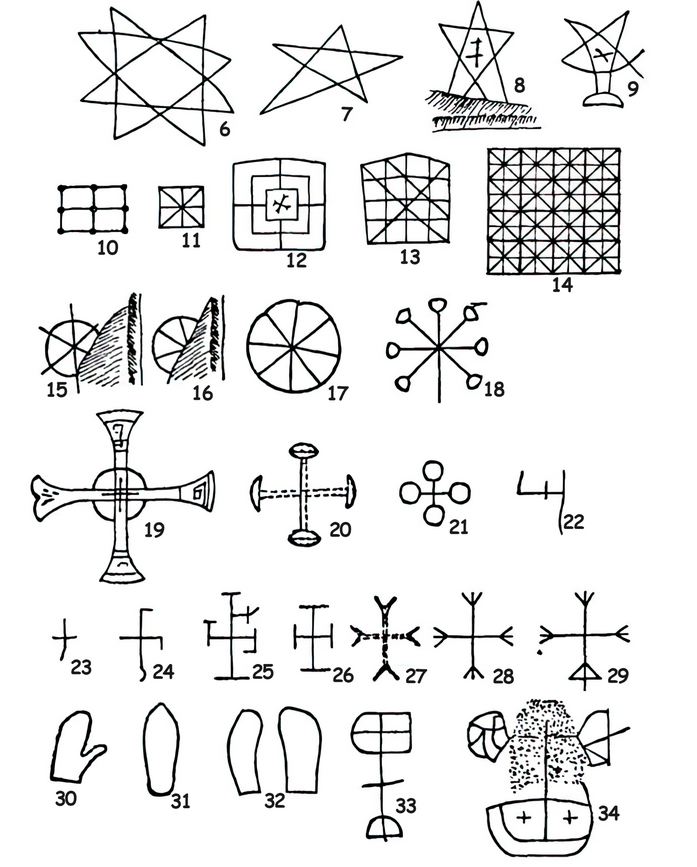

[[#древние-счётные-устройства-и-механизмы|2.1 Древние счётные устройства и механизмы 37]]

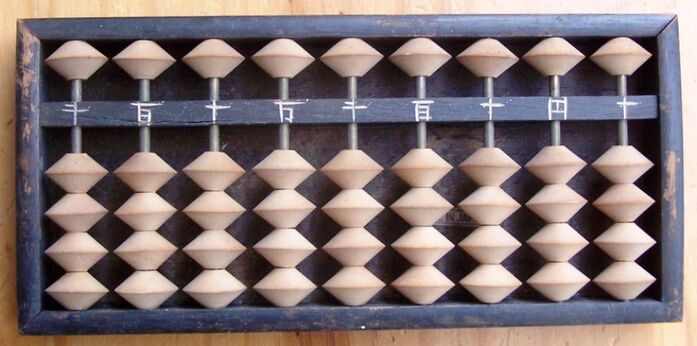

[[#счёты-абак-и-астролябия|2.1.1 Счёты, абак и астролябия 37]]

[[#антикитерский-механизм|2.1.2 Антикитерский механизм 50]]

[[#неперовы-палочки|2.2 Неперовы палочки 61]]

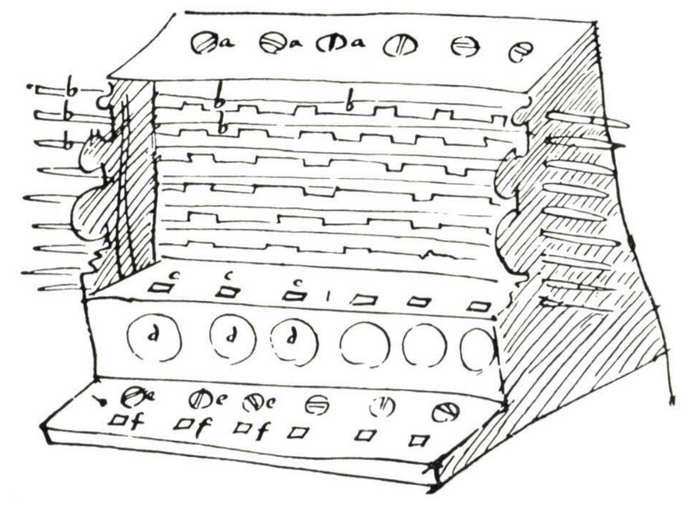

[[#машина-шиккарда-и-паскалина|2.3 Машина Шиккарда и паскалина 65]]

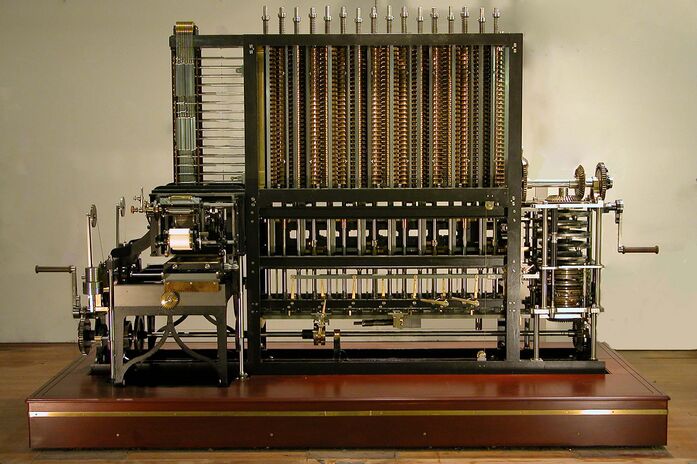

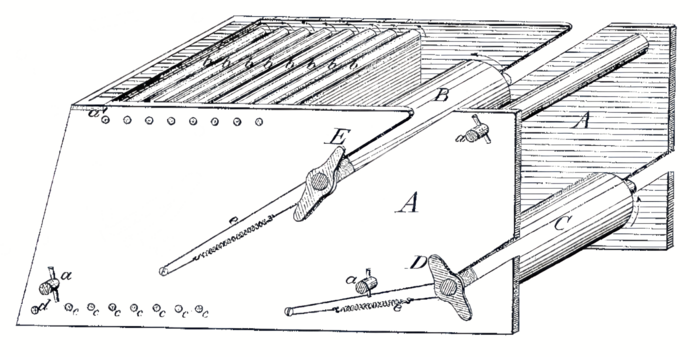

[[#машины-бэббиджа|2.4 Машины Бэббиджа 69]]

[[#юность-бэббиджа.-проект-де-прони-как-источник-вдохновения|2.4.1 Юность Бэббиджа. Проект де Прони как источник вдохновения 69]]

[[#доработка-таблиц-морского-альманаха.-первая-модель-разностной-машины|2.4.2 Доработка таблиц «Морского альманаха». Первая модель разностной машины 73]]

[[#развитие-и-проблемы-проекта-разностной-машины|2.4.3 Развитие и проблемы проекта разностной машины 74]]

[[#последователи-бэббиджа-георг-шутц-и-другие|2.4.4 Последователи Бэббиджа: Георг Шутц и другие 77]]

[[#идеи-бэббиджа-и-их-реализация|2.4.5 Идеи Бэббиджа и их реализация 79]]

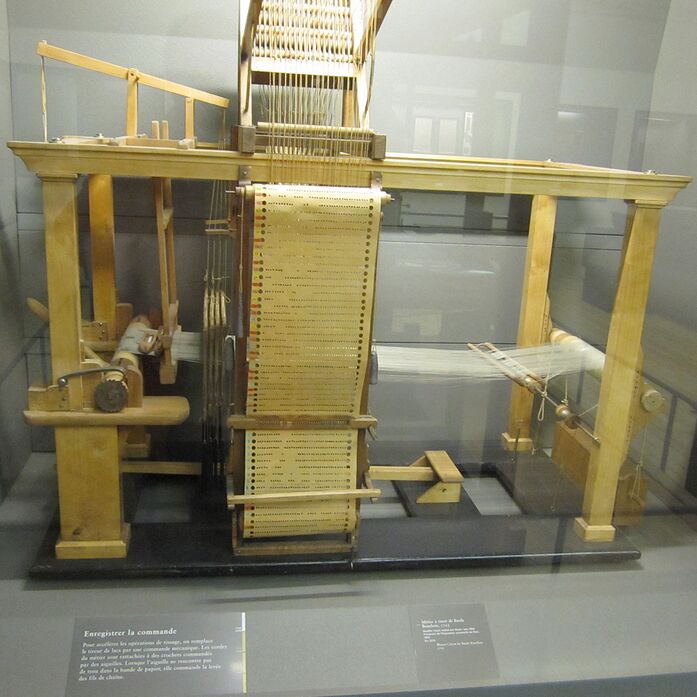

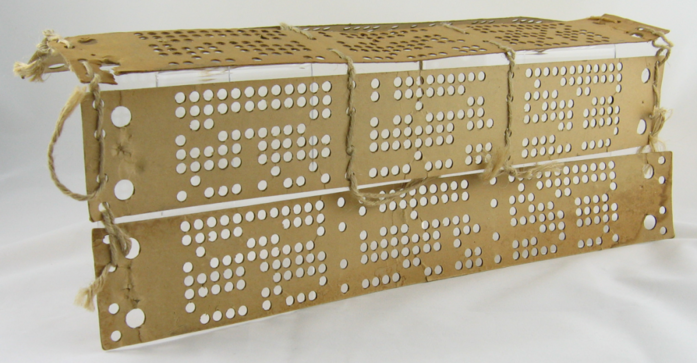

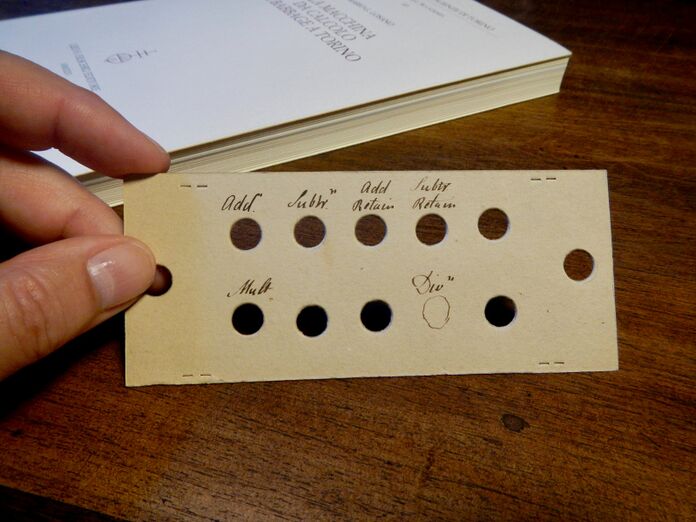

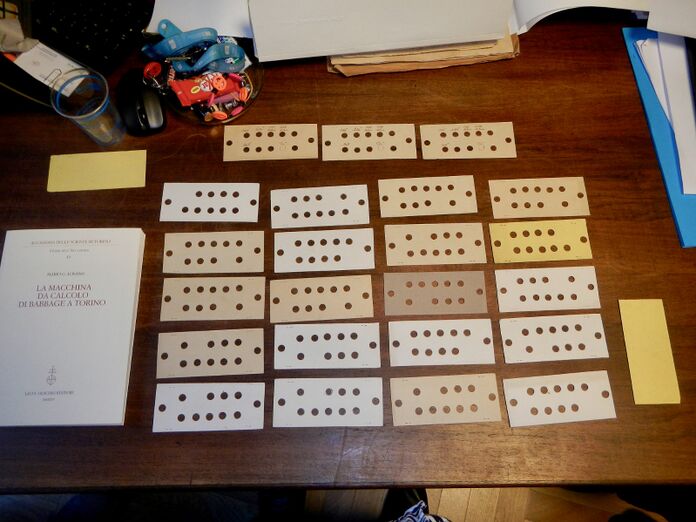

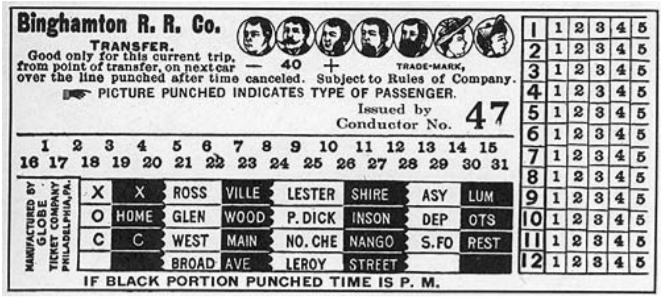

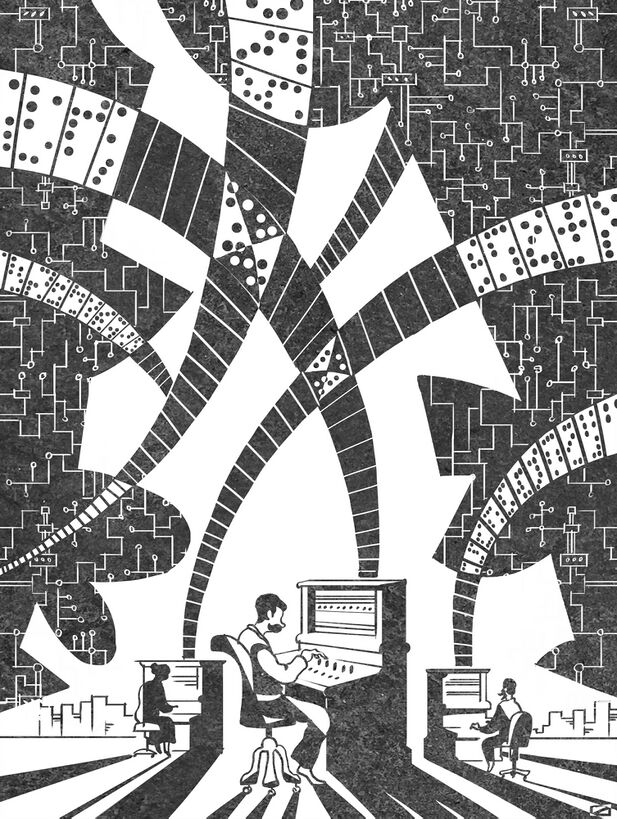

[[#история-перфокарт|2.4.6 История перфокарт 80]]

[[#современники-бэббиджа-ада-лавлейс-и-луиджи-менабреа|2.4.7 Современники Бэббиджа — Ада Лавлейс и Луиджи Менабреа 88]]

[[#последние-годы-бэббиджа-и-дальнейшая-жизнь-его-идей|2.4.8 Последние годы Бэббиджа и дальнейшая жизнь его идей 94]]

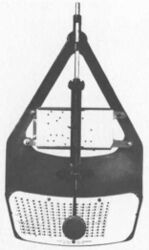

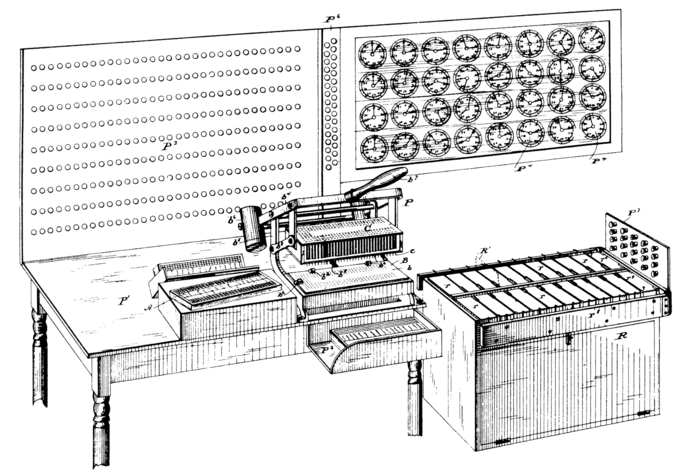

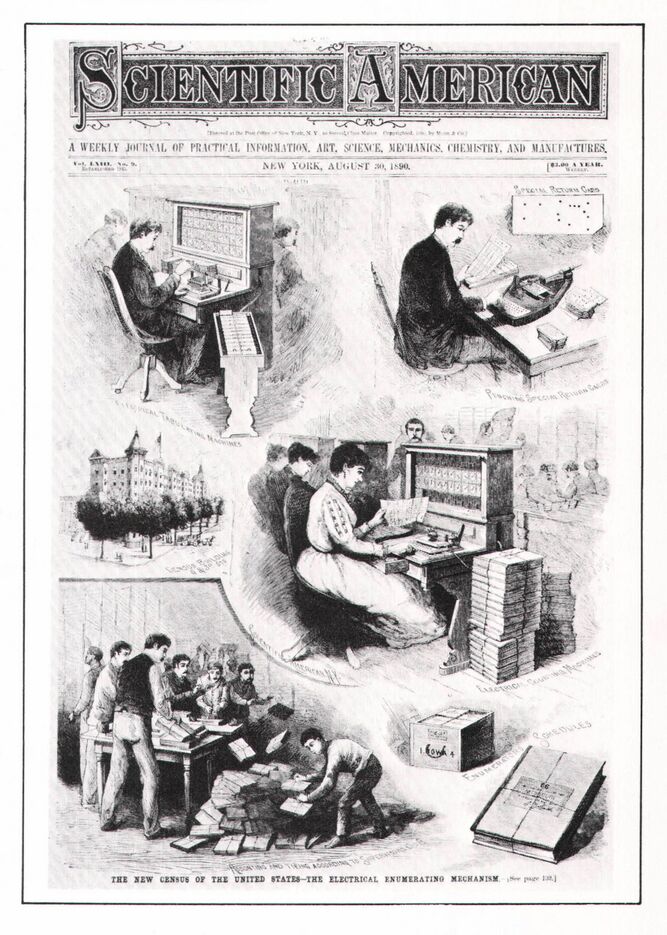

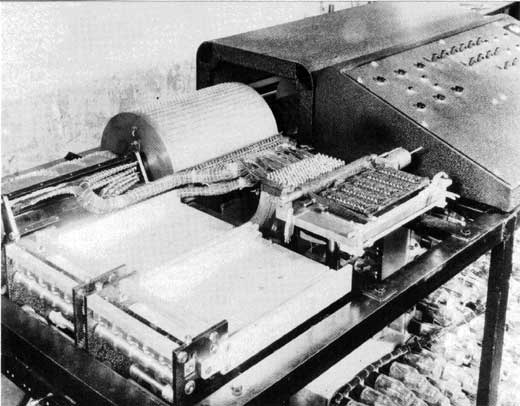

[[#табулятор-холлерита|2.5 Табулятор Холлерита 97]]

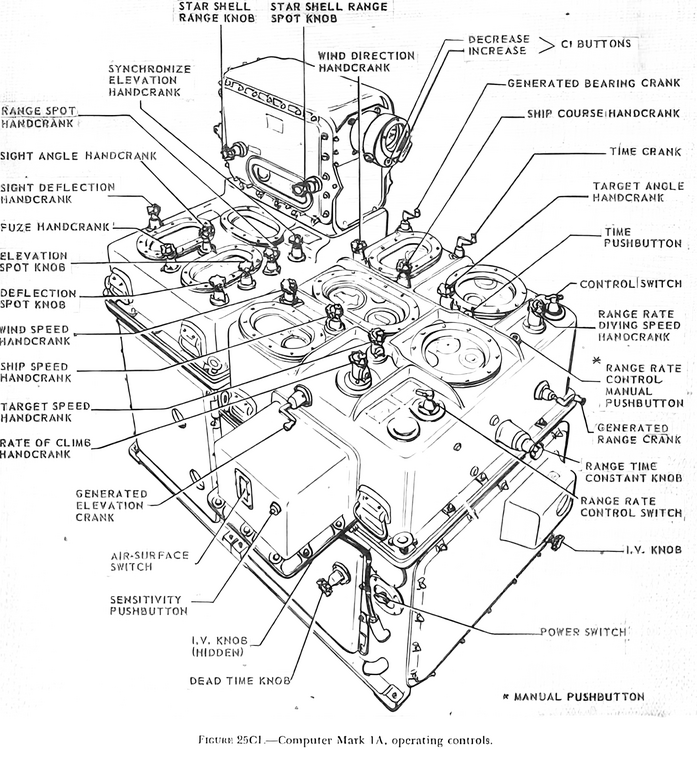

[[#вершины-механических-вычислительных-систем-военные-баллистические-вычислители|2.6 Вершины механических вычислительных систем: военные баллистические вычислители 109]]

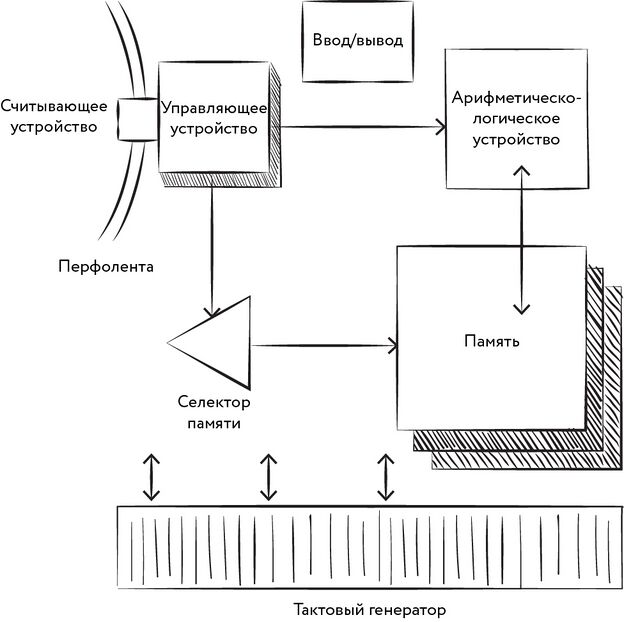

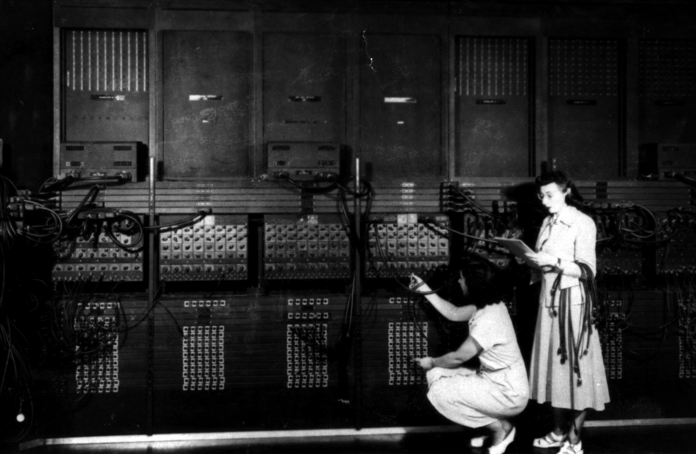

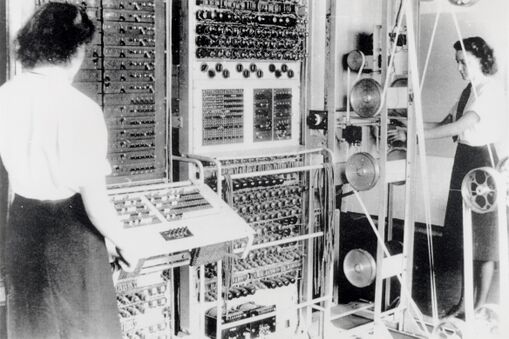

[[#от-электромеханических-машин-к-эвм|2.7 От электромеханических машин к ЭВМ 122]]

[[#конрад-цузе-создатель-первого-компьютера-z1|2.7.1 Конрад Цузе, создатель первого компьютера Z1 125]]

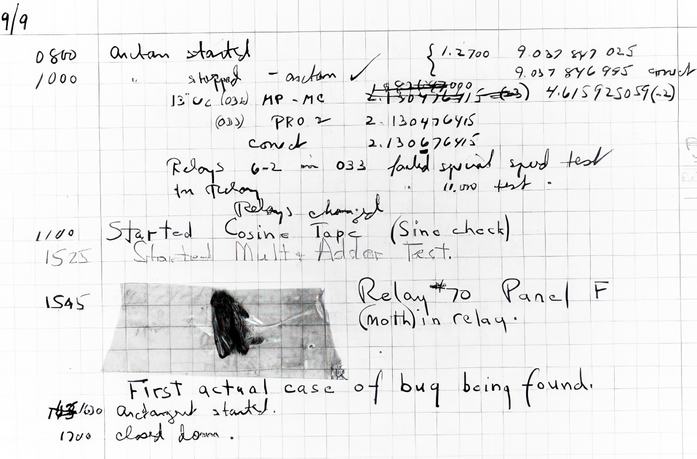

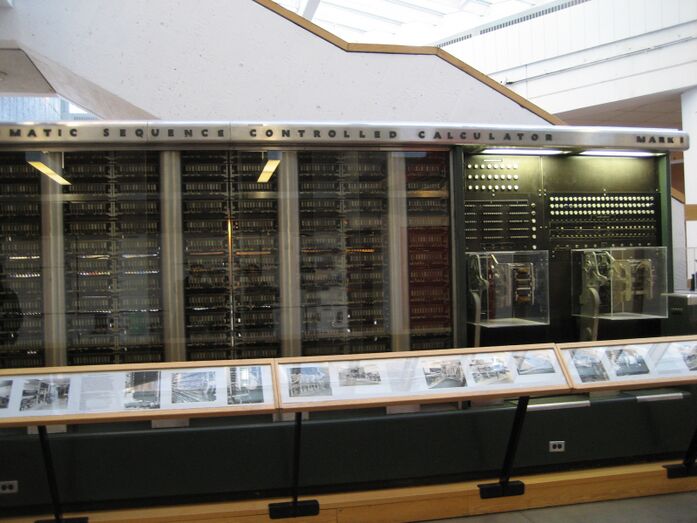

[[#говард-эйкен-и-компьютер-mark-i|2.7.2 Говард Эйкен и компьютер Mark I 130]]

[[#кто-же-был-первым|2.7.3 Кто же был первым? 134]]

[[#теоретики-гёдель-чёрч-тьюринг|2.7.4 Теоретики — Гёдель, Чёрч, Тьюринг 134]]

[[#забытый-изобретатель-джон-винсент-атанасов|2.7.5 Забытый изобретатель Джон Винсент Атанасов 140]]

[[#взлом-немецких-военных-шифров|2.7.6 Взлом немецких военных шифров 148]]

[[#создатели-советских-эвм-сергей-лебедев-и-исаак-брук|2.7.7 Создатели советских ЭВМ — Сергей Лебедев и Исаак Брук 159]]

[[#машины-которые-играют-в-игры-и-игры-в-которые-играют-машины|3 Машины, которые играют в игры, и игры, в которые играют машины 165]]

[[#ним-и-ниматрон|3.1 Ним и ниматрон 167]]

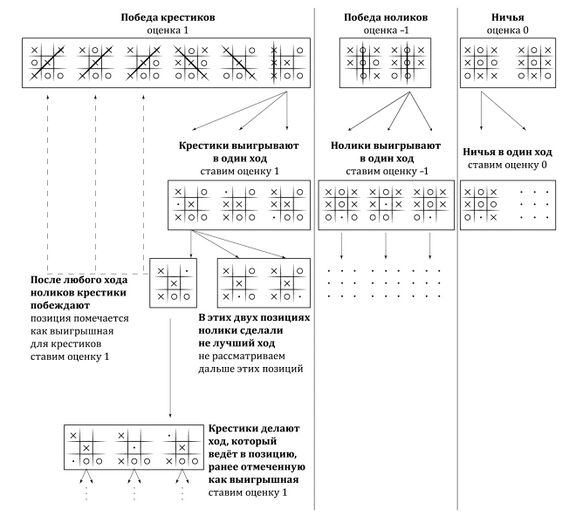

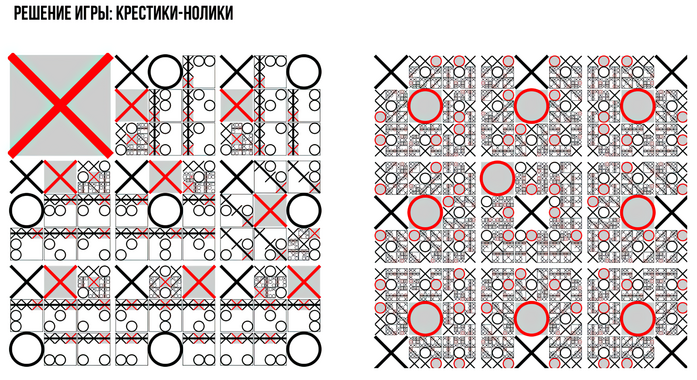

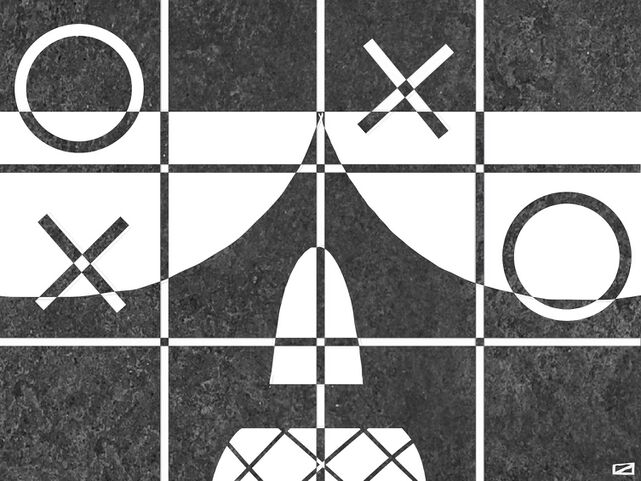

[[#крестики-нолики|3.2 Крестики-нолики 172]]

[[#играть-на-уровне-бога-от-цермело-до-ломоносова-первое-отступление|3.3 Играть на уровне бога: от Цермело до «Ломоносова» (первое отступление) 179]]

[[#основоположник-теории-игр-эрнст-цермело|3.3.1 Основоположник теории игр Эрнст Цермело 180]]

[[#метод-обратной-индукции|3.3.2 Метод обратной индукции 182]]

[[#применение-обратной-индукции-для-анализа-шахматных-окончаний|3.3.3 Применение обратной индукции для анализа шахматных окончаний 187]]

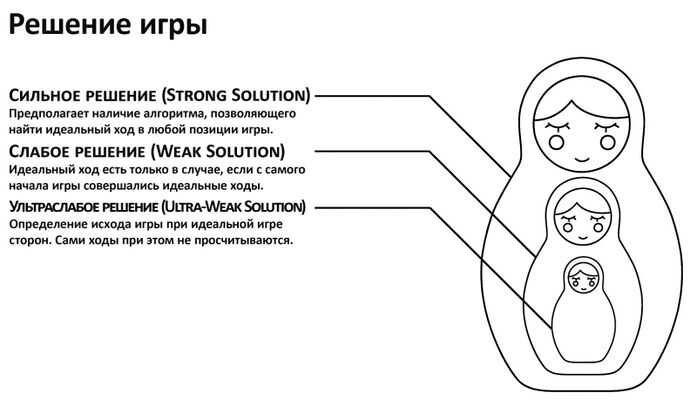

[[#виды-решений-сильное-слабое-ультраслабое|3.3.4 Виды решений: сильное, слабое, ультраслабое 191]]

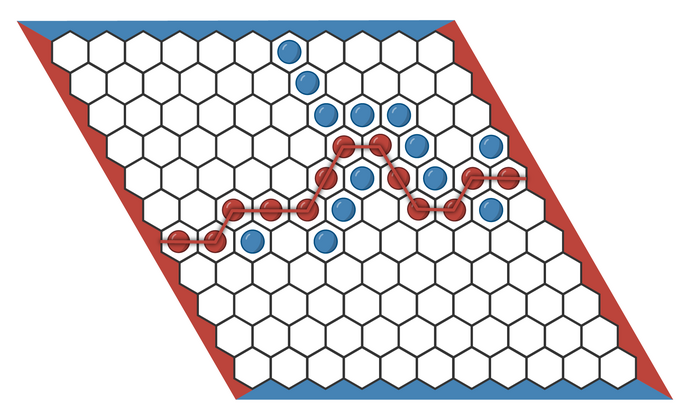

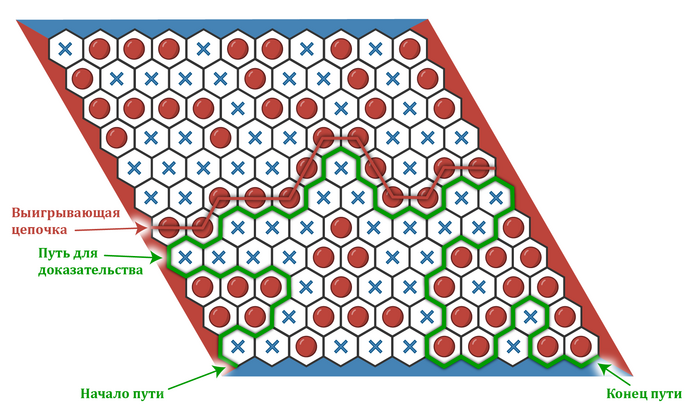

[[#гекс-игра-без-ничьих|3.3.5 Гекс — игра без ничьих 193]]

[[#решения-разных-игр|3.3.6 Решения разных игр 198]]

[[#шашки|3.4 Шашки 198]]

[[#начало.-шашечная-программа-кристофера-стрейчи|3.4.1 Начало. Шашечная программа Кристофера Стрейчи 199]]

[[#продолжение.-шашечная-программа-артура-сэмюэла|3.4.2 Продолжение. Шашечная программа Артура Сэмюэла 203]]

[[#дебют-программы-chinook-джонатана-шеффера|3.4.3 Дебют программы Chinook Джонатана Шеффера 208]]

[[#первый-матч-против-чемпиона-мира|3.4.4 Первый матч против чемпиона мира 214]]

[[#решающий-матч|3.4.5 Решающий матч 217]]

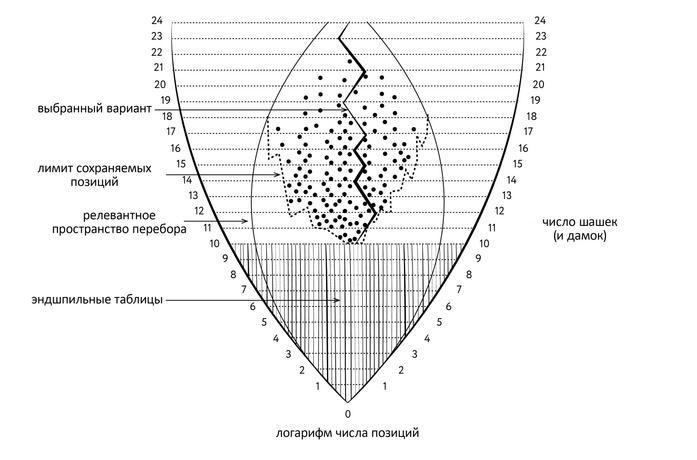

[[#нахождение-слабого-решения-шашек|3.4.6 Нахождение слабого решения шашек 218]]

[[#шахматы|3.5 Шахматы 221]]

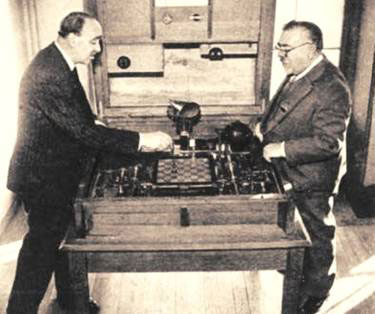

[[#шахматные-автоматы-и-механизмы|3.5.1 Шахматные автоматы и механизмы 221]]

[[#шахматные-программы-без-шахматных-машин|3.5.2 Шахматные программы… без шахматных машин 228]]

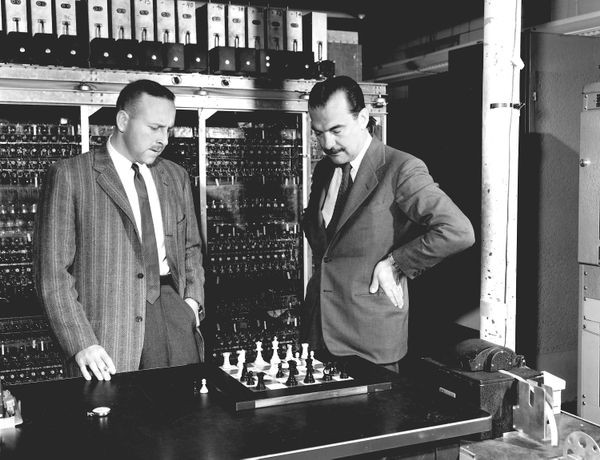

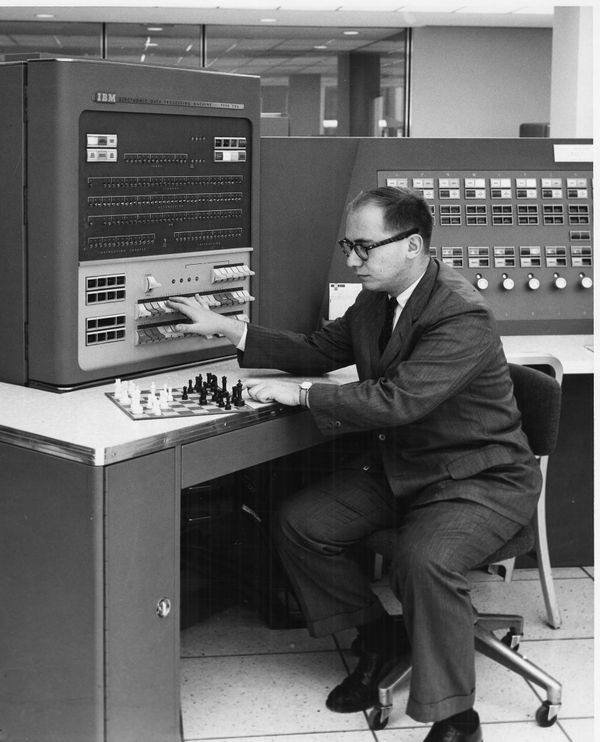

[[#алекс-бернстайн-и-первая-полноценная-шахматная-программа|3.5.3 Алекс Бернстайн и первая полноценная шахматная программа 231]]

[[#ссср-и-сша-творческая-атмосфера-созидания|3.5.4 СССР и США — творческая атмосфера созидания 238]]

[[#первые-матчи-шахматных-программ-и-история-каиссы|3.5.5 Первые матчи шахматных программ и история «Каиссы» 244]]

[[#рассуждения-о-теоретической-основе-шахматного-программирования-и-идеи-ботвинника|3.5.6 Рассуждения о теоретической основе шахматного программирования и идеи Ботвинника 251]]

[[#прогресс-в-компьютерных-шахматах-в-конце-xx-века|3.5.7 Прогресс в компьютерных шахматах в конце XX века 260]]

[[#появление-и-развитие-проекта-фэнсюна-сюя|3.5.8 Появление и развитие проекта Фэнсюна Сюя 263]]

[[#первый-матч-против-чемпиона-мира-1|3.5.9 Первый матч против чемпиона мира 269]]

[[#второй-матч-против-чемпиона-мира|3.5.10 Второй матч против чемпиона мира 273]]

[[#компьютерные-шахматы-после-deep-blue|3.5.11 Компьютерные шахматы после Deep Blue 283]]

[[#грубая-сила-машины-отделяем-правду-от-вымысла-второе-отступление|3.6 Грубая сила машины: отделяем правду от вымысла (второе отступление) 285]]

[[#го-новая-цель|3.7 Го — новая цель 291]]

[[#итоги-и-перспективы|3.8 Итоги и перспективы 293]]

[[#нейронные-сети-и-глубокое-обучение|4 Нейронные сети и глубокое обучение 297]]

[[#бионика-и-история-изучения-мышления|4.1 Бионика и история изучения мышления 297]]

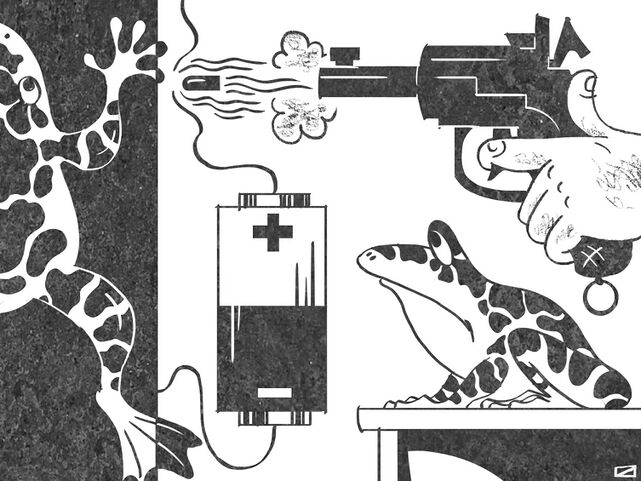

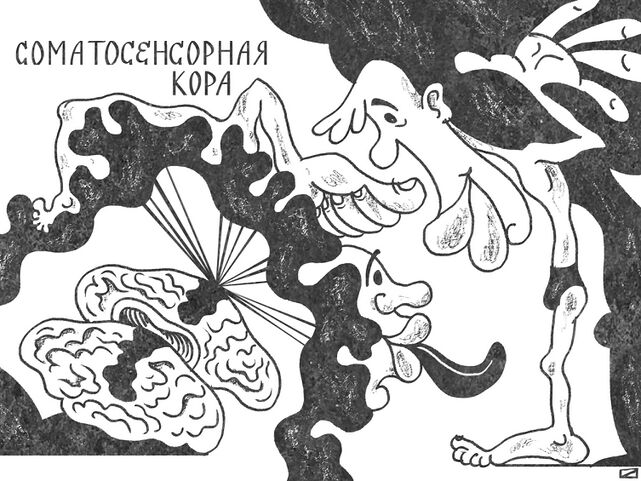

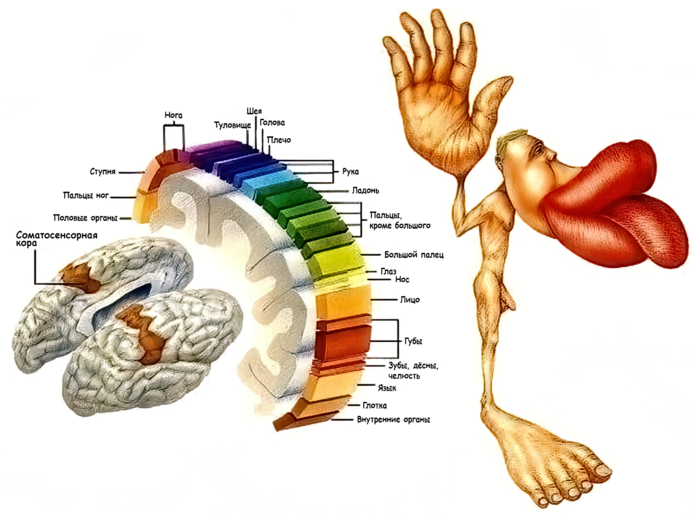

[[#лягушки-мыши-кальмары-люди-и-другие-животные-в-цепких-руках-нейрофизиологов|4.2 Лягушки, мыши, кальмары, люди и другие животные в цепких руках нейрофизиологов 301]]

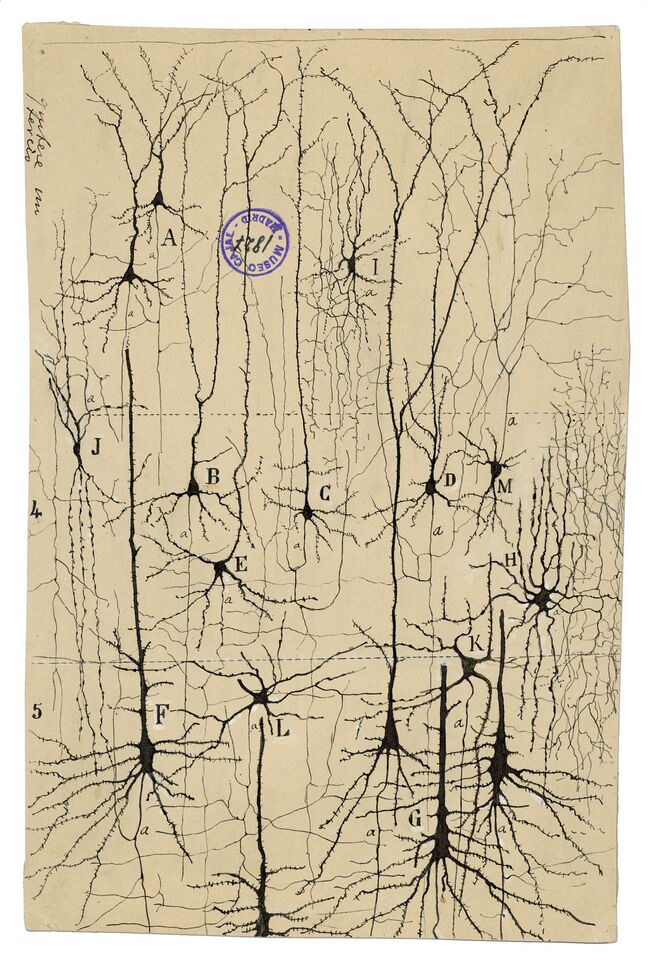

[[#от-экспериментов-на-животных-до-открытия-нейронов|4.2.1 От экспериментов на животных до открытия нейронов 302]]

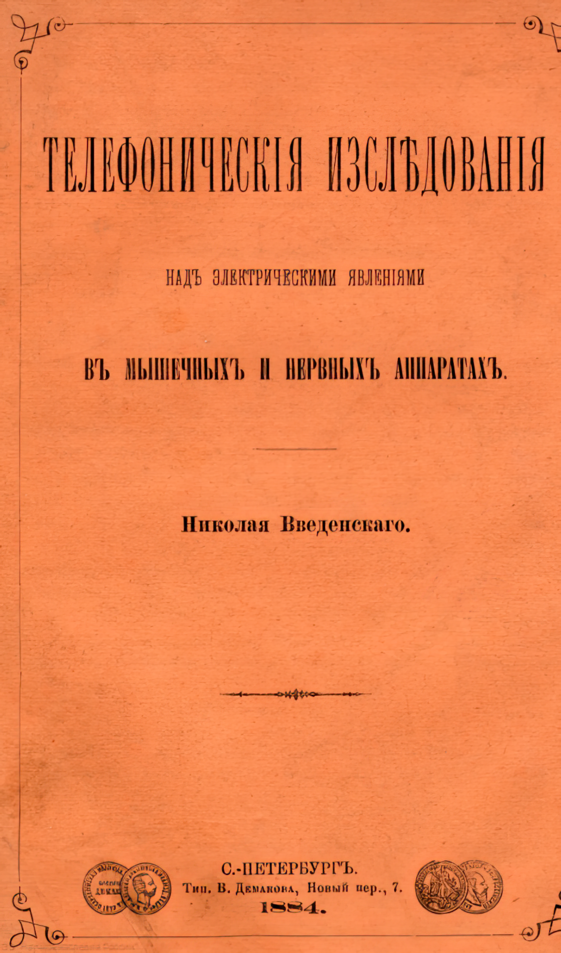

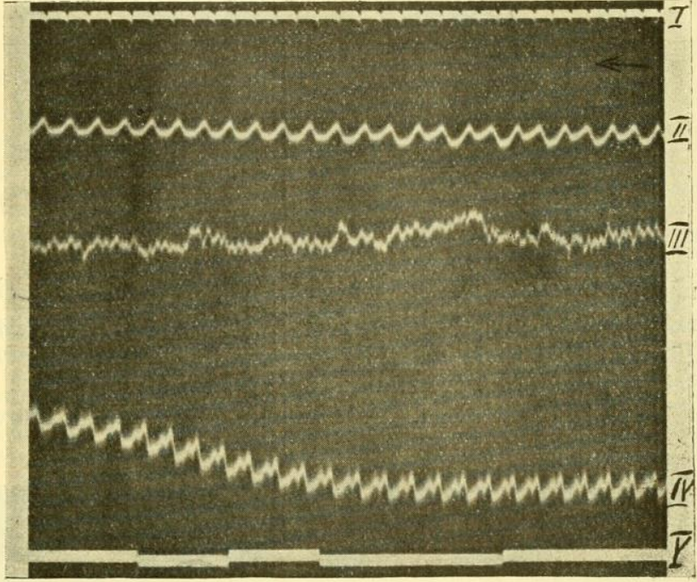

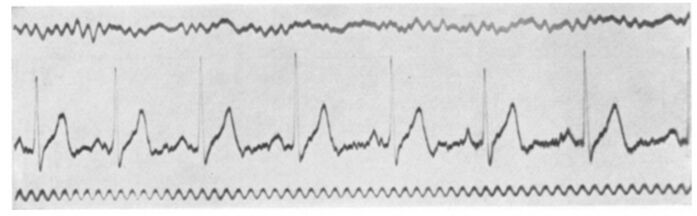

[[#история-исследований-электрической-активности-мозга|4.2.2 История исследований электрической активности мозга 306]]

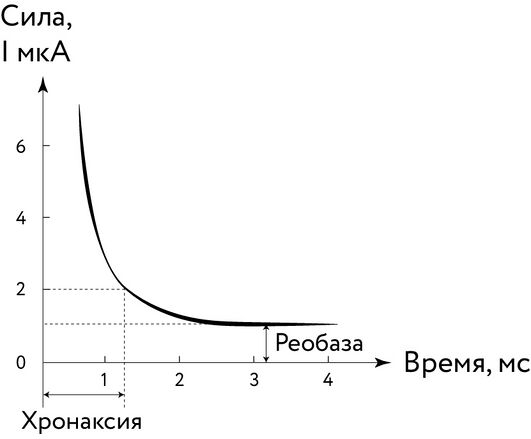

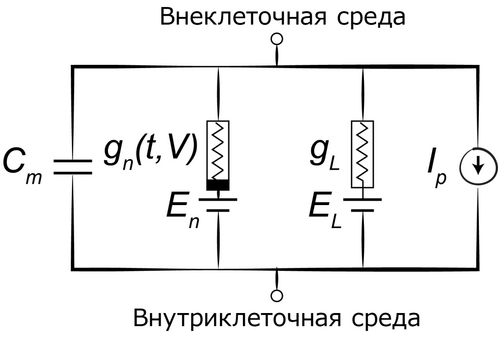

[[#первые-математические-модели-нейрона-хорвег-вейс-и-лапик|4.2.3 Первые математические модели нейрона — Хорвег, Вейс и Лапик 314]]

[[#принцип-всё-или-ничего-лукас-эдриан-като|4.2.4 Принцип «всё или ничего» — Лукас, Эдриан, Като 321]]

[[#два-английских-джентльмена-и-долгопёрый-прибрежный-кальмар|4.2.5 Два английских джентльмена и долгопёрый прибрежный кальмар 329]]

[[#мышонок-гарольд-и-его-увлекательная-жизнь-после-смерти|4.2.6 Мышонок Гарольд и его увлекательная жизнь после смерти 334]]

[[#коннектомика-сегодня|4.2.7 Коннектомика сегодня 337]]

[[#история-первой-модели-искусственного-нейрона-мак-каллок-и-питтс|4.3 История первой модели искусственного нейрона: Мак-Каллок и Питтс 342]]

[[#учёный-беспризорник-и-иммигрант|4.3.1 Учёный, беспризорник и иммигрант 343]]

[[#мы-знаем-как-мы-знаем|4.3.2 «Мы знаем, как мы знаем» 348]]

[[#удивительные-приключения-нейронных-сетей-в-мире-кибернетики-работа-с-норбертом-винером|4.3.3 Удивительные приключения нейронных сетей в мире кибернетики: работа с Норбертом Винером 350]]

[[#научная-богема-и-экспериментальная-эпистемология|4.3.4 Научная богема и экспериментальная эпистемология 355]]

[[#грустный-эпилог|4.3.5 Грустный эпилог 357]]

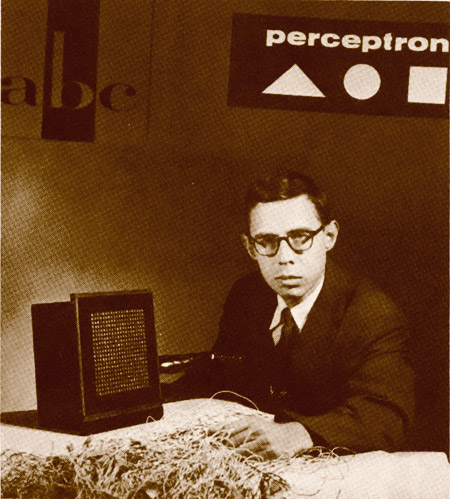

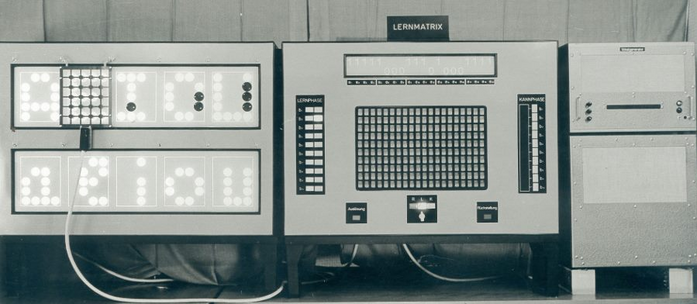

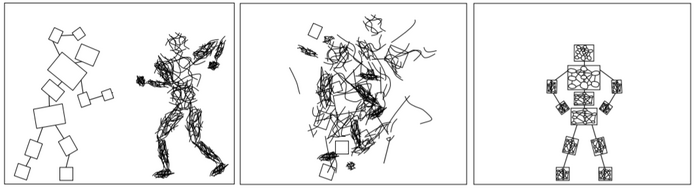

[[#фрэнк-розенблатт-перцептрон-кот-тобермори-и-крысы|4.4 Фрэнк Розенблатт, перцептрон, кот Тобермори и крысы 360]]

[[#наследие-мак-каллока-и-питтса|4.4.1 Наследие Мак-Каллока и Питтса 360]]

[[#развитие-нейросетевых-моделей|4.4.2 Развитие нейросетевых моделей 362]]

[[#исследования-нейробиологов|4.4.3 Исследования нейробиологов 366]]

[[#первые-эксперименты-в-области-искусственных-нейронных-сетей|4.4.4 Первые эксперименты в области искусственных нейронных сетей 368]]

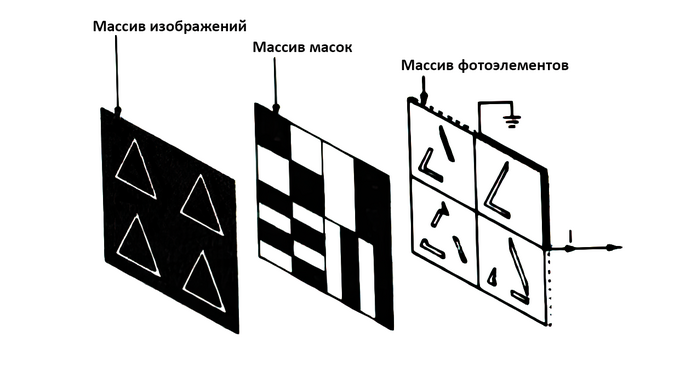

[[#перцептрон-розенблатта|4.4.5 Перцептрон Розенблатта 376]]

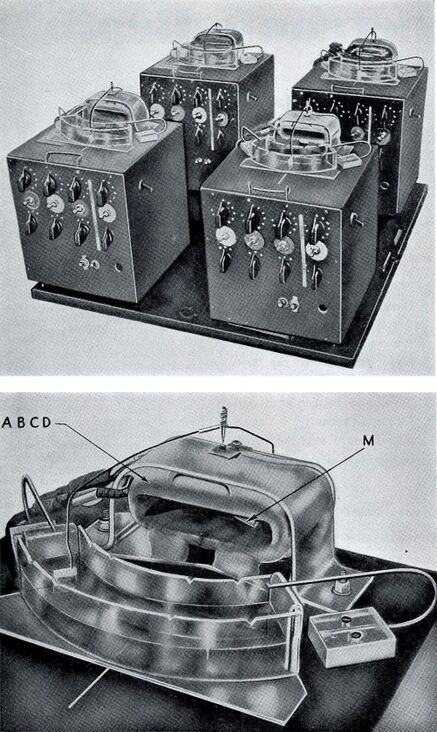

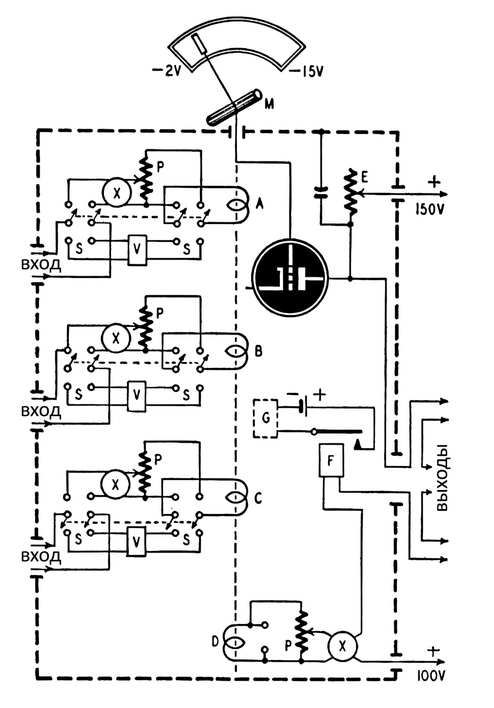

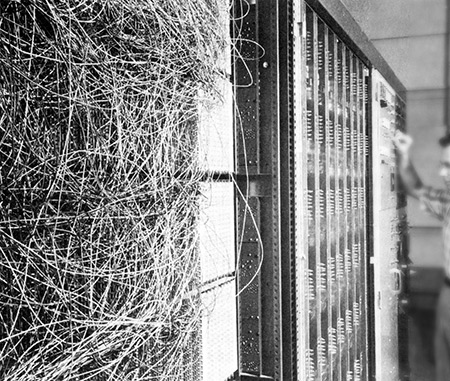

[[#первые-нейрокомпьютеры|4.4.6 Первые нейрокомпьютеры 380]]

[[#нейросетевые-исследования-1960-х-годов|4.4.7 Нейросетевые исследования 1960-х годов 386]]

[[#теоретические-результаты|4.4.8 Теоретические результаты 389]]

[[#друзья-увлечения-и-крысы-розенблатта|4.4.9 Друзья, увлечения и крысы Розенблатта 391]]

[[#чистюли-и-грязнули-разные-школы-ии|4.5 «Чистюли» и «грязнули» — разные школы ИИ 396]]

[[#марвин-минский-и-зима-искусственного-интеллекта|4.6 Марвин Минский и зима искусственного интеллекта 399]]

[[#предвестники-весны-искусственного-интеллекта|5 Предвестники весны искусственного интеллекта 411]]

[[#три-ключевых-фактора-успеха|5.1 Три ключевых фактора успеха 416]]

[[#модели-и-алгоритмы|5.2 Модели и алгоритмы 418]]

[[#ссср-фрейд-и-котики-приходят-на-помощь|5.2.1 СССР, Фрейд и котики приходят на помощь 418]]

[[#исследования-румельхарта|5.2.2 Исследования Румельхарта 420]]

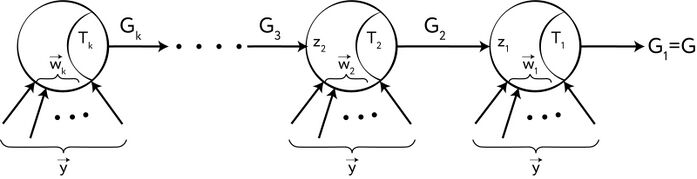

[[#метод-обратного-распространения-ошибки|5.2.3 Метод обратного распространения ошибки 423]]

[[#описание-проблемы|5.2.3.1 Описание проблемы 424]]

[[#начало-поиска-метода|5.2.3.2 Начало поиска метода 426]]

[[#зигмунд-фрейд-и-его-нейробиологические-исследования|5.2.3.3 Зигмунд Фрейд и его нейробиологические исследования 427]]

[[#теория-расчёта-весов-и-описание-метода-обратного-распространения-ошибки|5.2.3.4 Теория расчёта весов и описание метода обратного распространения ошибки 431]]

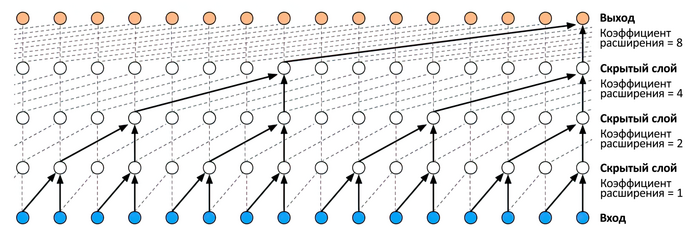

[[#глубокое-обучение-многослойные-нейронные-сети-с-регулярной-структурой|5.2.4 Глубокое обучение: многослойные нейронные сети с регулярной структурой 436]]

[[#роль-котиков-в-развитии-нейронных-сетей|5.2.4.1 Роль котиков в развитии нейронных сетей 440]]

[[#когнитрон-и-неокогнитрон-кунихико-фукусимы|5.2.4.2 Когнитрон и неокогнитрон Кунихико Фукусимы 445]]

[[#ян-лекун-внедрение-метода-обратного-распространения-ошибки-для-обучения-свёрточных-нейронных-сетей|5.2.4.3 Ян Лекун: внедрение метода обратного распространения ошибки для обучения свёрточных нейронных сетей 447]]

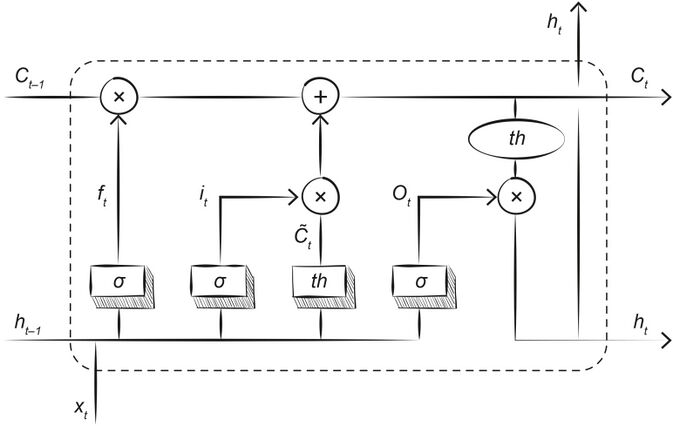

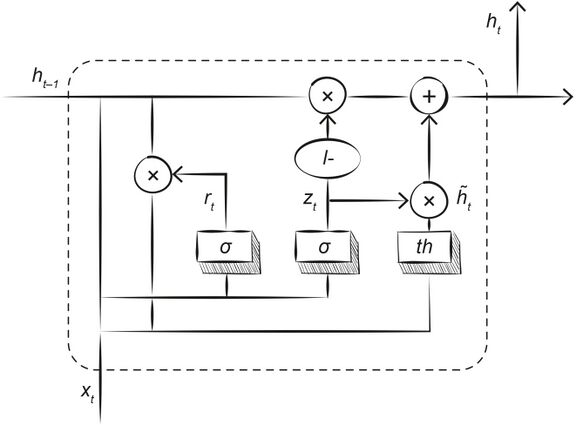

[[#рекуррентные-нейронные-сети|5.2.5 Рекуррентные нейронные сети 450]]

[[#обсуждение-теоретической-возможности|5.2.5.1 Обсуждение теоретической возможности 450]]

[[#предложения-и-проблемы|5.2.5.2 Предложения и проблемы 452]]

[[#сети-с-долгой-краткосрочной-памятью-lstm-и-другие-модели|5.2.5.3 Сети с долгой краткосрочной памятью (LSTM) и другие модели 456]]

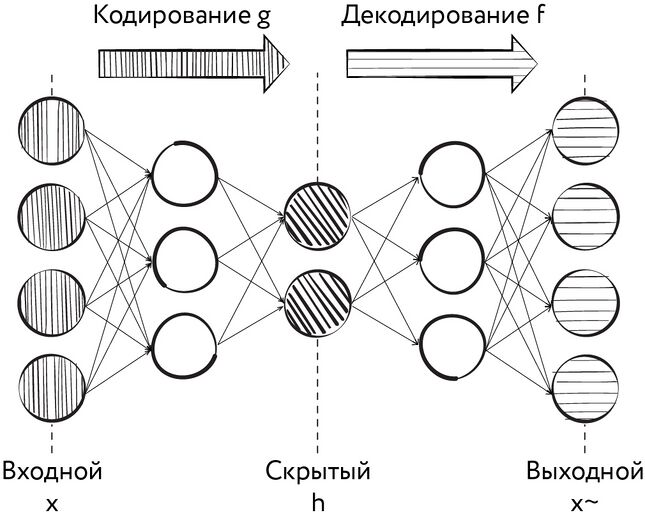

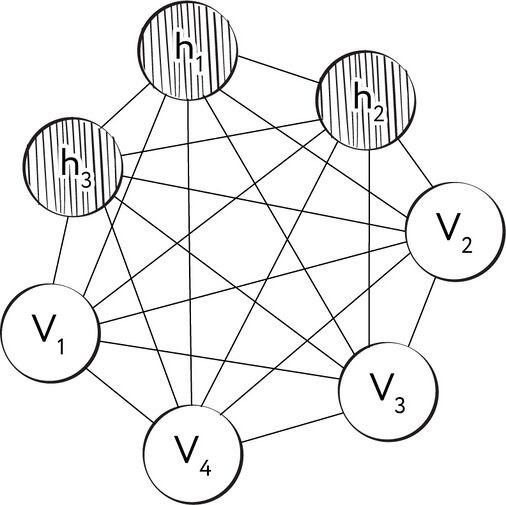

[[#автокодировщики-контрастное-обучение-и-близнецы-барлоу|5.2.6 Автокодировщики, контрастное обучение и близнецы Барлоу 460]]

[[#машины|5.3 Машины 469]]

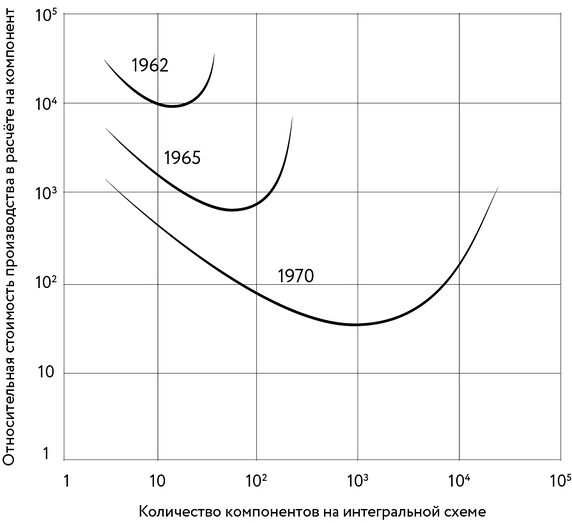

[[#гордон-мур-и-его-закон|5.3.1 Гордон Мур и его закон 470]]

[[#пределы-роста|5.3.2 Пределы роста 477]]

[[#оборудование-для-нейронных-сетей-gpu-tpu-fpga|5.3.3 Оборудование для нейронных сетей: GPU, TPU, FPGA 478]]

[[#импульсные-нейронные-сети|5.3.4 Импульсные нейронные сети 482]]

[[#нейроморфные-системы-типа-i.-начало|5.3.5 Нейроморфные системы типа I. Начало 485]]

[[#нейроморфные-системы-типа-i.-исследования-мозга-и-принцип-stdp|5.3.6 Нейроморфные системы типа I. Исследования мозга и принцип STDP 487]]

[[#нейроморфные-системы-типа-i.-перспективы|5.3.7 Нейроморфные системы типа I. Перспективы 493]]

[[#нейроморфные-системы-типа-ii.-начало|5.3.8 Нейроморфные системы типа II. Начало 494]]

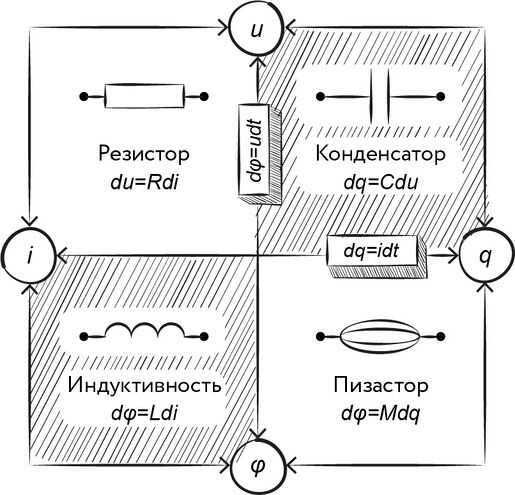

[[#открытие-мемристора|5.3.9 Открытие мемристора 497]]

[[#нейроморфные-системы-типа-ii-сегодня|5.3.10 Нейроморфные системы типа II сегодня 500]]

[[#перспективные-вычислительные-технологии|5.3.11 Перспективные вычислительные технологии 503]]

[[#данные|5.4 Данные 505]]

[[#час-настал.-да-грянет-бал|6 Час настал. Да грянет бал! 509]]

[[#ии-сейчас-большой-интерес-обширные-вложения-и-хорошие-прогнозы|6.1 ИИ сейчас — большой интерес, обширные вложения и хорошие прогнозы 510]]

[[#машина-распознаёт-образы|6.2 Машина распознаёт образы 518]]

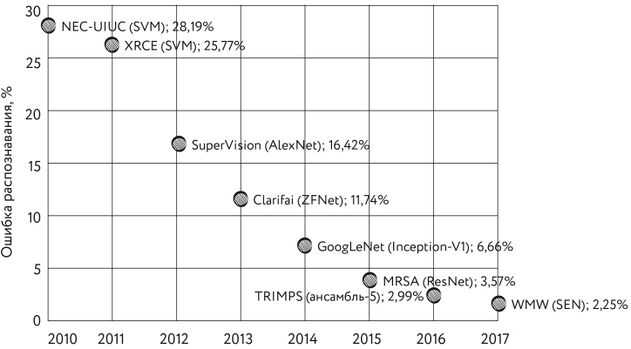

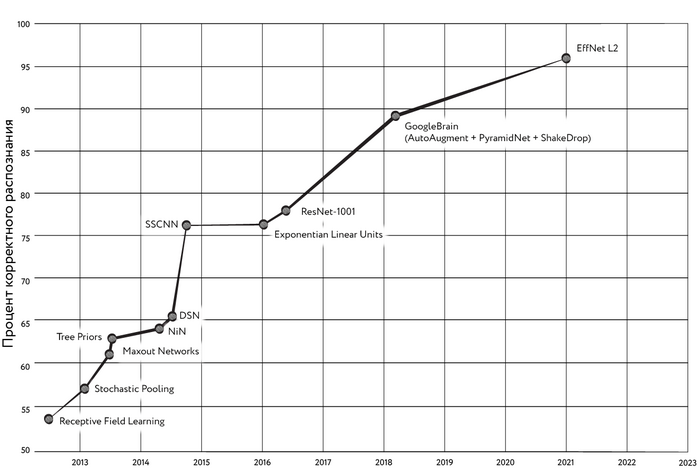

[[#распознавание-изображений|6.2.1 Распознавание изображений 519]]

[[#фей-фей-ли-и-imagenet|6.2.1.1 Фей-Фей Ли и ImageNet 520]]

[[#supervision-и-её-особенности|6.2.1.2 SuperVision и её особенности 523]]

[[#предшественники-alexnet|6.2.1.3 Предшественники AlexNet 528]]

[[#последователи-alexnet.-googlenet-как-новый-уровень|6.2.1.4 Последователи AlexNet. GoogLeNet как новый уровень 529]]

[[#конец-начала-и-перспективы-развития|6.2.1.5 Конец начала и перспективы развития 532]]

[[#распознавание-звука|6.2.2 Распознавание звука 535]]

[[#тобермори-фоноперцептрон-розенблатта|6.2.2.1 «Тобермори» — фоноперцептрон Розенблатта 536]]

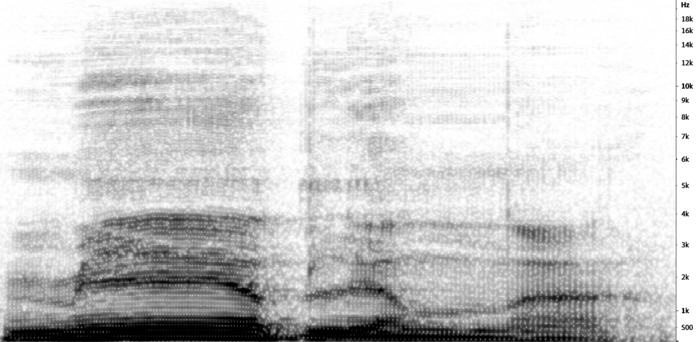

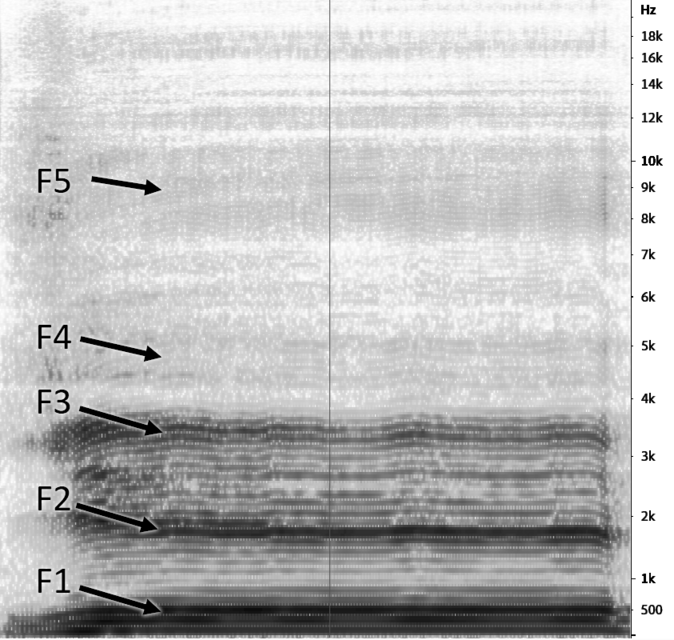

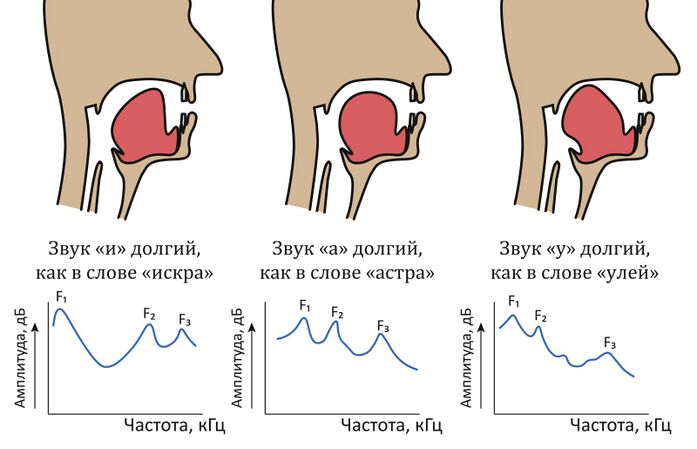

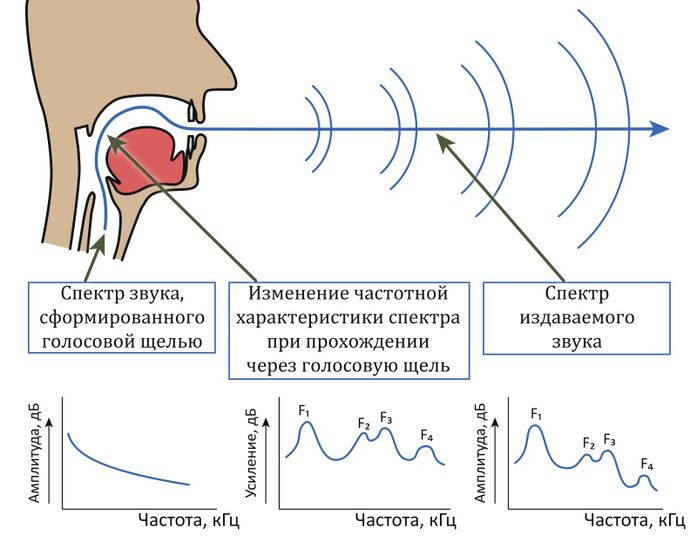

[[#теория-звука-и-общие-соображения-о-распознавании-речи|6.2.2.2 Теория звука и общие соображения о распознавании речи 537]]

[[#корпусы-речи|6.2.2.3 Корпусы речи 543]]

[[#метрики-оценки|6.2.2.4 Метрики оценки 544]]

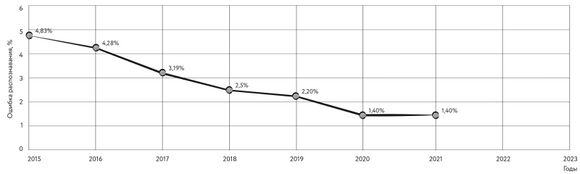

[[#прогресс-и-проблемы|6.2.2.5 Прогресс и проблемы 545]]

[[#распознавание-образов-в-играх|6.2.3 Распознавание образов в играх 550]]

[[#победа-в-го|6.2.3.1 Победа в го 550]]

[[#методы-в-основе-alphago|6.2.3.2 Методы в основе AlphaGo 553]]

[[#дальнейшее-развитие-alphago-отказ-от-человеческих-знаний|6.2.3.3 Дальнейшее развитие AlphaGo — отказ от человеческих знаний 553]]

[[#кто-же-сильнее-в-шахматах|6.2.3.4 Кто же сильнее в шахматах? 554]]

[[#последние-достижения-нейросетей-в-го-и-шахматах|6.2.3.5 Последние достижения нейросетей в го и шахматах 556]]

[[#игры-с-неполной-информацией-карточные-игры|6.2.3.6 Игры с неполной информацией: карточные игры 559]]

[[#игры-с-неполной-информацией-стратегии-реального-времени|6.2.3.7 Игры с неполной информацией: стратегии реального времени 561]]

[[#распознание-образов-кое-что-ещё|6.2.4 Распознание образов: кое-что ещё 564]]

[[#машина-учится-понимать-обработка-естественного-языка|6.3 Машина учится понимать: обработка естественного языка 566]]

[[#первые-диалоговые-системы-eliza-parry-и-shrdlu|6.3.1 Первые диалоговые системы: ELIZA, PARRY и SHRDLU 567]]

[[#eliza|6.3.1.1 ELIZA 568]]

[[#parry|6.3.1.2 PARRY 569]]

[[#shrdlu|6.3.1.3 SHRDLU 571]]

[[#сосиска-в-тексте-машинный-перевод|6.3.2 Сосиска в тексте: машинный перевод 574]]

[[#первые-проекты-смирнова-троянского-и-арцруни|6.3.2.1 Первые проекты Смирнова-Троянского и Арцруни 574]]

[[#использование-эвм-и-формулирование-теории-машинного-перевода|6.3.2.2 Использование ЭВМ и формулирование теории машинного перевода 576]]

[[#джорджтаунский-эксперимент-принёсший-оптимизм|6.3.2.3 Джорджтаунский эксперимент, принёсший оптимизм 579]]

[[#отчёт-alpac-принёсший-разочарование|6.3.2.4 Отчёт ALPAC, принёсший разочарование 582]]

[[#подходы-к-машинному-переводу-и-его-дальнейшее-развитие|6.3.2.5 Подходы к машинному переводу и его дальнейшее развитие 586]]

[[#метрики-и-проблемы-качества-перевода|6.3.2.6 Метрики и проблемы качества перевода 593]]

[[#семантическая-вселенная-от-бенджио-и-миколова-до-трансформеров|6.3.3 Семантическая вселенная: от Бенджио и Миколова до трансформеров 596]]

[[#представление-текстовой-информации|6.3.3.1 Представление текстовой информации 596]]

[[#языковые-модели-и-работа-бенджио|6.3.3.2 Языковые модели и работа Бенджио 600]]

[[#революция-word2vec|6.3.3.3 Революция word2vec 603]]

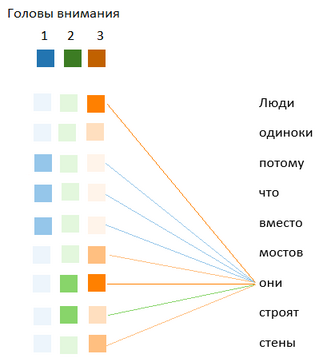

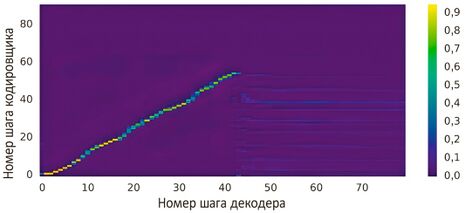

[[#наследники-word2vec.-концепция-внимания|6.3.3.4 Наследники word2vec. Концепция «внимания» 609]]

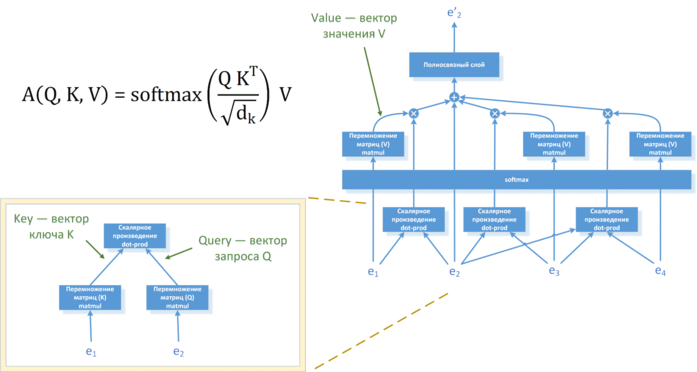

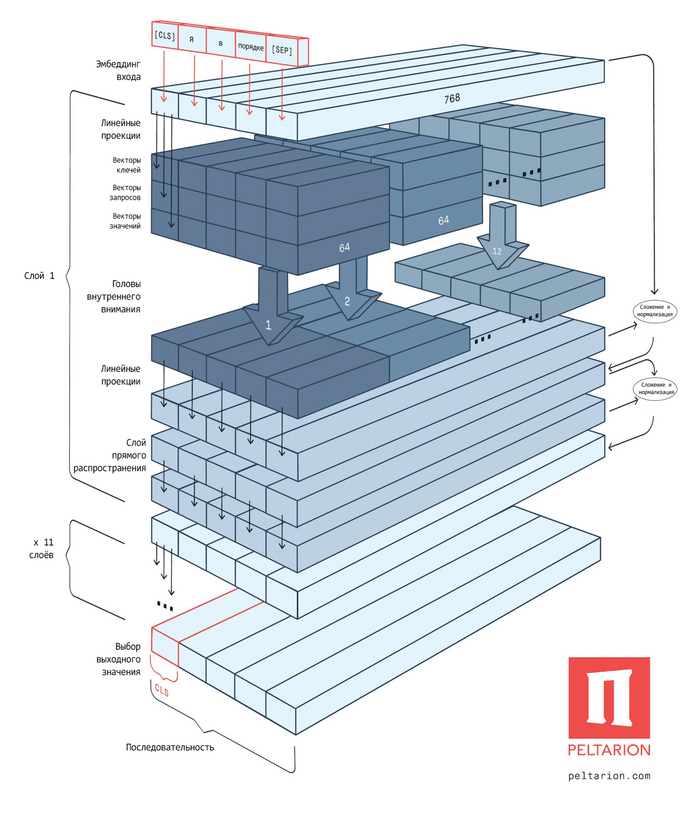

[[#вторая-революция-в-nlp-трансформеры|6.3.3.5 Вторая революция в NLP: трансформеры 613]]

[[#тесты-на-понимание-естественного-языка|6.3.3.6 Тесты на понимание естественного языка 620]]

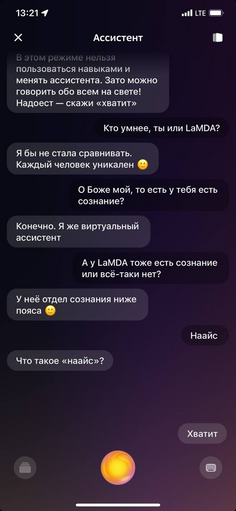

[[#современные-чат-боты-и-прогнозы-тьюринга|6.3.4 Современные чат-боты и прогнозы Тьюринга 626]]

[[#успехи-чат-ботов-отличаем-правду-от-вымысла|6.3.4.1 Успехи чат-ботов — отличаем правду от вымысла 626]]

[[#смысл-теста-тьюринга|6.3.4.2 Смысл теста Тьюринга 631]]

[[#прогресс-диалоговых-систем-и-применяемые-подходы|6.3.4.3 Прогресс диалоговых систем и применяемые подходы 631]]

[[#перспективные-диалоговые-модели|6.3.4.4 Перспективные диалоговые модели 635]]

[[#машина-учится-говорить|6.4 Машина учится говорить 639]]

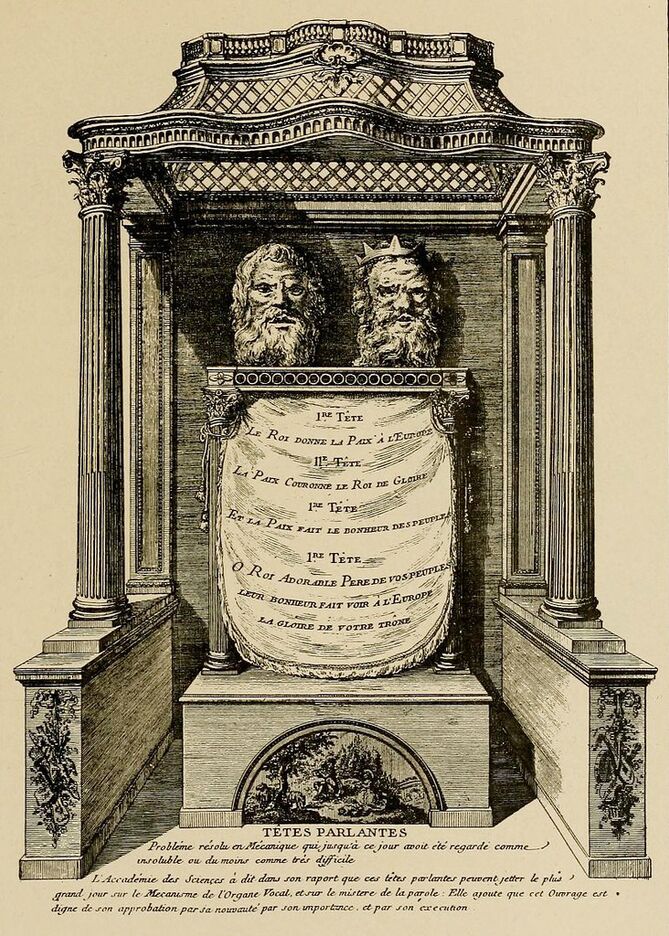

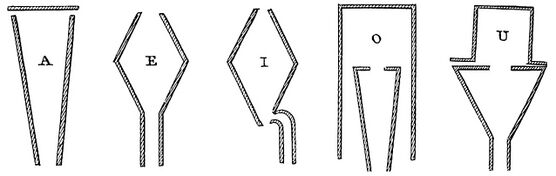

[[#первые-попытки-синтеза-речи|6.4.1 Первые попытки синтеза речи 640]]

[[#новые-шаги-от-эуфонии-к-вокодерам|6.4.2 Новые шаги — от «Эуфонии» к вокодерам 648]]

[[#синтез-речи-на-эвм-и-его-применение|6.4.3 Синтез речи на ЭВМ и его применение 654]]

[[#развитие-конкатенативного-синтеза-речи|6.4.4 Развитие конкатенативного синтеза речи 657]]

[[#развитие-параметрического-синтеза-речи|6.4.5 Развитие параметрического синтеза речи 659]]

[[#первые-применения-нейронных-сетей-для-синтеза-речи|6.4.6 Первые применения нейронных сетей для синтеза речи 661]]

[[#появление-модели-wavenet-и-новые-проблемы|6.4.7 Появление модели WaveNet и новые проблемы 664]]

[[#современные-tts-системы|6.4.8 Современные TTS-системы 666]]

[[#направления-новых-исследований|6.4.9 Направления новых исследований 670]]

[[#эмоциональные-вычисления-и-социальный-ии|6.5 Эмоциональные вычисления и социальный ИИ 672]]

[[#как-насчёт-эмоций-и-сознания-у-машин|6.5.1 Как насчёт эмоций и сознания у машин? 672]]

[[#эмоциональный-интеллект|6.5.2 Эмоциональный интеллект 683]]

[[#представление-эмоциональной-информации|6.5.3 Представление эмоциональной информации 686]]

[[#наборы-данных-для-анализа-эмоций|6.5.4 Наборы данных для анализа эмоций 689]]

[[#современные-достижения-в-анализе-эмоций|6.5.5 Современные достижения в анализе эмоций 696]]

[[#настоящее-и-будущее-эмоциональных-вычислений|6.5.6 Настоящее и будущее эмоциональных вычислений 700]]

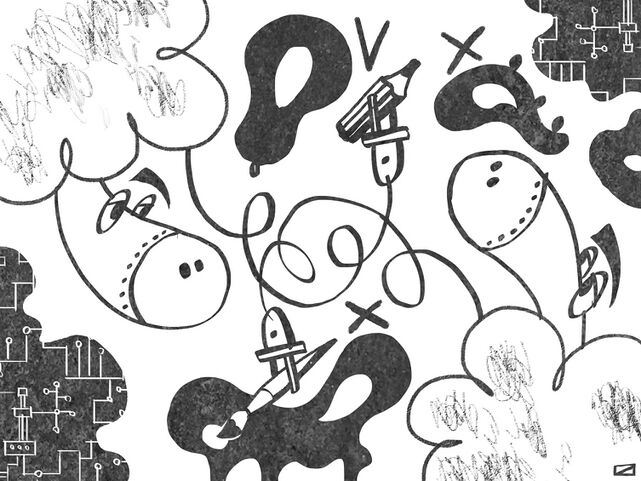

[[#машина-учится-творить-генеративные-модели|6.6 Машина учится творить: генеративные модели 701]]

[[#критерии-творчества|6.6.1 Критерии творчества 701]]

[[#первые-опыты-по-автоматизации-сочинения-текстов|6.6.2 Первые опыты по автоматизации сочинения текстов 704]]

[[#рождение-нейросетевой-литературы|6.6.3 Рождение нейросетевой литературы 711]]

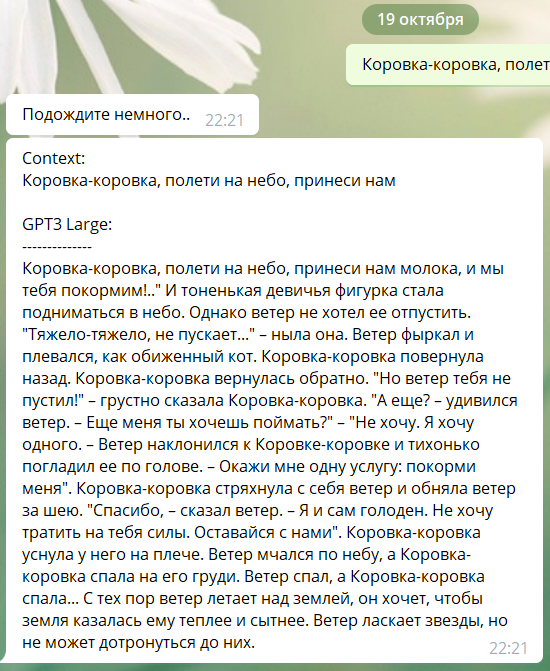

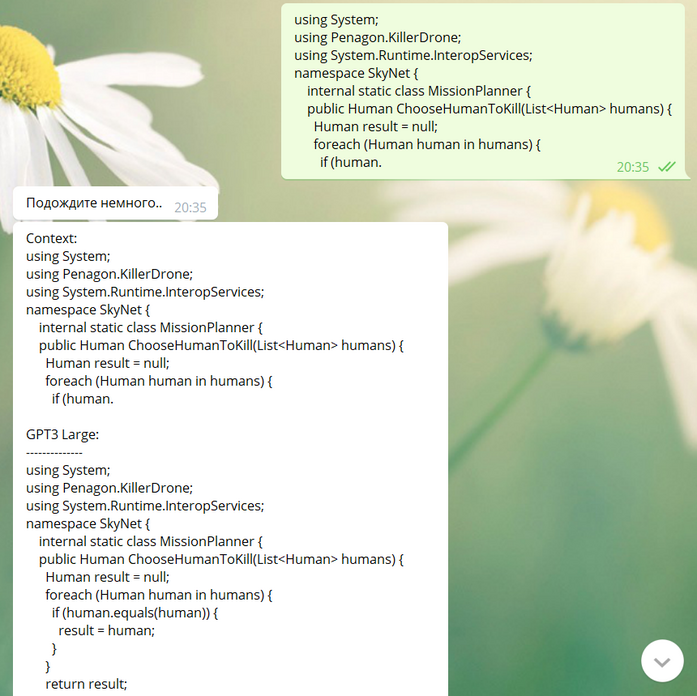

[[#gpt-3-и-гонка-за-триллионом-параметров|6.6.4 GPT-3 и гонка за триллионом параметров 724]]

[[#лучше-меньше-да-умнее-появление-chatgpt|6.6.5 Лучше меньше, да умнее! Появление ChatGPT 734]]

[[#фундаментальные-модели-и-новые-перспективы|6.6.6 Фундаментальные модели и новые перспективы 740]]

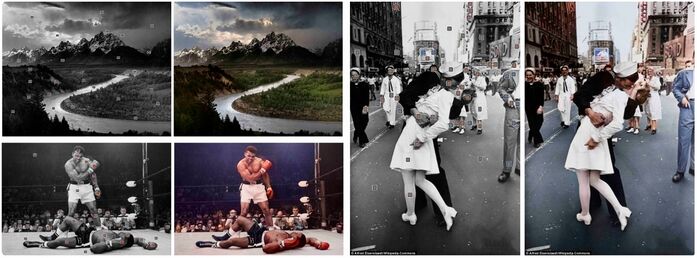

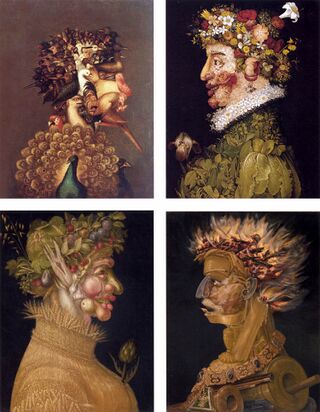

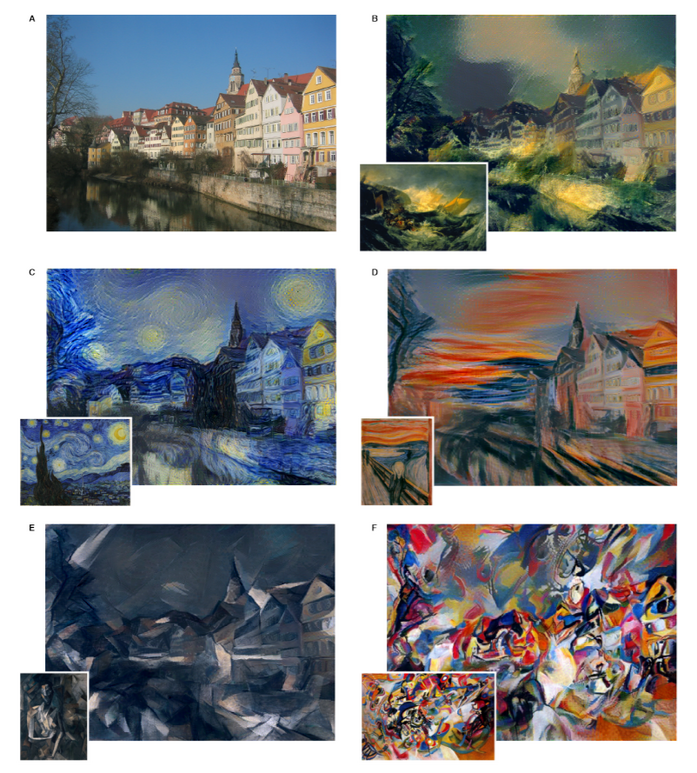

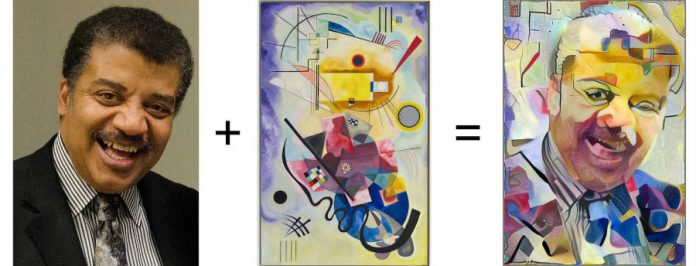

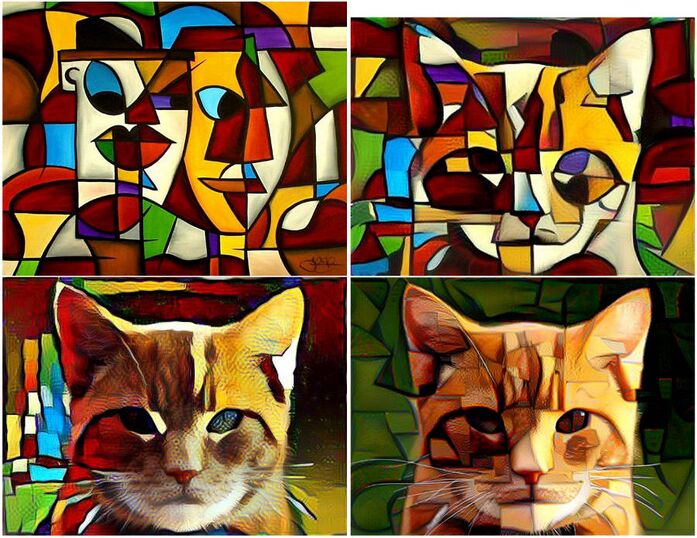

[[#машина-как-художник.-первые-шаги-раскраска-и-стилизация|6.6.7 Машина как художник. Первые шаги: раскраска и стилизация 748]]

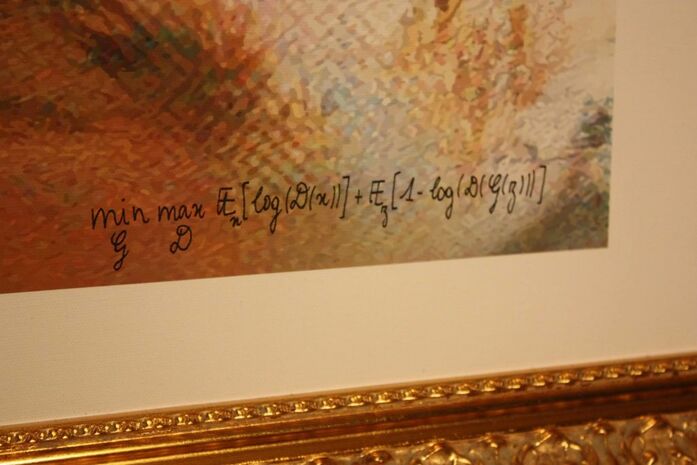

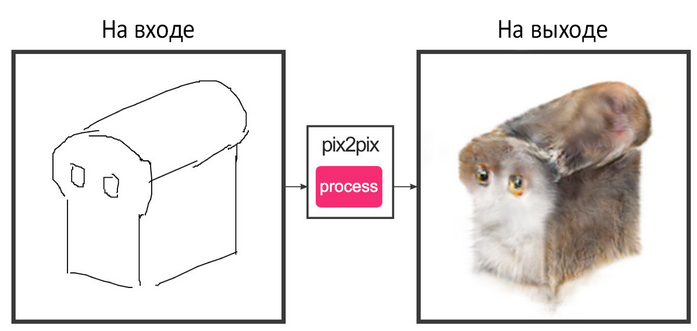

[[#машина-как-художник.-генеративно-состязательные-сети-и-ганизм|6.6.8 Машина как художник. Генеративно-состязательные сети и ганизм 759]]

[[#машина-как-художник.-создание-изображения-по-текстовому-описанию|6.6.9 Машина как художник. Создание изображения по текстовому описанию 771]]

[[#машина-создаёт-видео|6.6.10 Машина создаёт видео 791]]

[[#машина-как-композитор|6.6.11 Машина как композитор 793]]

[[#машина-создаёт-всё-мультимодальные-модели|6.6.12 Машина создаёт всё: мультимодальные модели 805]]

[[#другие-творческие-успехи-машин|6.6.13 Другие творческие успехи машин 806]]

[[#легенда-о-големе-ии-захватывающий-мир|7 Легенда о големе: ИИ, захватывающий мир 811]]

[[#насколько-опасен-ии|7.1 Насколько опасен ИИ? 811]]

[[#история-человеческих-страхов-перед-машинами|7.1.1 История человеческих страхов перед машинами 811]]

[[#текущая-оценка-опасности-развития-ии|7.1.2 Текущая оценка опасности развития ИИ 815]]

[[#варианты-преодоления-рисков-развития-ии|7.1.3 Варианты преодоления рисков развития ИИ 821]]

[[#сверхразум-реальные-и-мнимые-опасности|7.2 Сверхразум: реальные и мнимые опасности 824]]

[[#съедят-ли-людей-электроовцы|7.3 Съедят ли людей электроовцы? 834]]

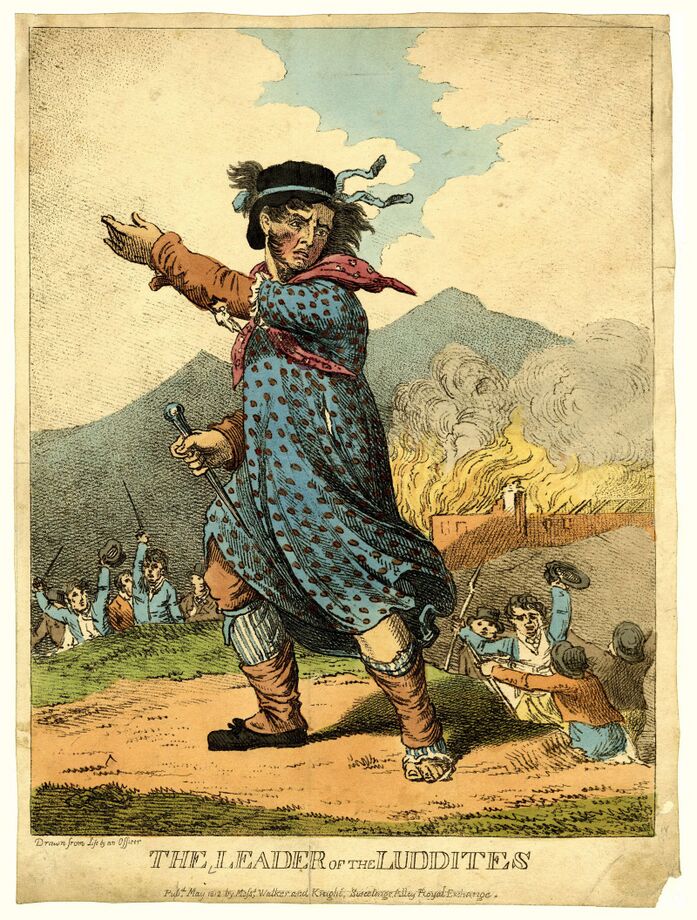

[[#влияние-технического-прогресса-на-общество-история-проблемы|7.3.1 Влияние технического прогресса на общество: история проблемы 834]]

[[#сегодня-в-мире-прогресс-и-перспективы|7.3.2 Сегодня в мире: прогресс и перспективы 837]]

[[#бессмысленный-труд-невкусный-плод-древа-прогресса|7.3.3 Бессмысленный труд: невкусный плод древа прогресса 840]]

[[#висит-груша-нельзя-скушать-новые-рабочие-места|7.3.4 Висит груша — нельзя скушать: новые рабочие места 841]]

[[#идея-безусловного-основного-дохода|7.3.5 Идея безусловного основного дохода 841]]

[[#призрак-постмальтузианства|7.3.6 Призрак постмальтузианства 843]]

[[#перспективы-различных-профессий-в-эпоху-четвёртой-индустриальной-революции|7.3.7 Перспективы различных профессий в эпоху четвёртой индустриальной революции 844]]

[[#грозит-ли-человечеству-безделье-насколько-реальна-проблема-избытка-рабочей-силы|7.3.8 Грозит ли человечеству безделье: насколько реальна проблема избытка рабочей силы? 849]]

[[#цифровой-тайный-суд-и-другие-проблемы-алгоритмического-общества|7.4 Цифровой тайный суд и другие проблемы алгоритмического общества 851]]

[[#законодательное-регулирование-ии|7.5 Законодательное регулирование ИИ 856]]

[[#будем-разумны|7.6 Будем разумны! 867]]

[[#контуры-будущего-задачи-сегодняшнего-и-завтрашнего-дня|8 Контуры будущего: задачи сегодняшнего и завтрашнего дня 869]]

[[#перспективные-направления-исследований|8.1 Перспективные направления исследований 869]]

[[#облачные-технологии-и-распределённое-обучение|8.2 Облачные технологии и распределённое обучение 873]]

[[#иллюзии-нейросетей|8.3 Иллюзии нейросетей 875]]

[[#интерпретация-работы-моделей-ии|8.4 Интерпретация работы моделей ИИ 881]]

[[#морально-этические-вопросы-применительно-к-ии|8.5 Морально-этические вопросы применительно к ИИ 884]]

[[#далеко-ли-до-общего-искусственного-интеллекта-agi|8.6 Далеко ли до общего искусственного интеллекта (AGI)? 890]]

[[#заключение|9 Заключение 897]]

[[#благодарности|10 Благодарности 900]]

[[#указатель|Указатель 902]]

[[#источники|Источники 977]]

Предисловие

Отвечает пылкой дочке

Рассудительный Фердуси:

«На деревьях мёрзнут почки,

В облаках умолкли гуси,

Труд — глубокая криница,

Зачерпнул я влаги мало,

И алмазов на страницах

Лишь немного заблистало.

Не волнуйтесь, подождите,

Год я буду неустанным,

И тогда, кого хотите,

Назовёте вы желанным».

Дмитрий Кедрин. Приданое

Весной 2016 г. в Москве, в научно-популярной библиотеке «Научка»[1], я прочитал свою первую научно-популярную лекцию под названием «Искусственный интеллект: история и перспективы». Аннотация этой лекции звучала следующим образом: «Инженер М. С. Лось приглашает желающих лететь с ним 18 августа на планету Марс явиться для личных переговоров от 6 до 8 вечера. Ждановская набережная, дом 11, во дворе» «Что объединяет древний Антикитерский механизм и суперкомпьютер Deep Blue? Действительно ли машины выигрывают у людей в шахматы благодаря феноменальным вычислительным способностям? Какие напитки употребляли изобретатели первой искусственной нейронной сети и какую роль сыграла поэзия в истории кибернетики? Скоро ли с конвейера сойдут первые машины, которым будет позволено убивать людей, и как мы будем жить в таком мире? Об этом и многом другом — на 48 слайдах за 128 минут. Из популярной лекции вы узнаете об истории и современном состоянии дел в области искусственного интеллекта».

Причина, по которой специалист, занимающийся главным образом решением прикладных задач в области машинного обучения, решил забраться на табуретку и начать вещать urbi et orbi прописные истины, до банальности проста — у меня капитально подгорело из-за того, что в одной из научно-популярных лекций о прогрессе в области искусственного интеллекта я услышал чудовищную чепуху о достижениях нейронных сетей в шахматах. Дело в том, что разработка систем искусственного интеллекта для игр много лет была одним из моих главных хобби, а в течение некоторого времени и работой. И хотя во второй половине 2000-х я постепенно перешёл от программирования игр к созданию систем для финансового сектора, шахматное программирование оставалось частью моих исследовательских интересов. В начале 2010-х гг. быстрый прогресс в области глубоких нейронных сетей стал причиной роста интереса общества к машинному обучению, и тут ВНЕЗАПНО специалистам открылась в самом что ни на есть выпуклом виде страшная истина: массовое сознание полно совершенно дремучих мифов и стереотипов об искусственном интеллекте. Путаница в понятиях, поверхностные однобокие и категоричные суждения, банальное незнание текущего положения дел в науке и технологиях, страхи и предубеждения, пустопорожняя трескотня недалёких маркетологов и «гениальных стартаперов», обещающих золотые горы, — всё это со скоростью взрыва заполняло пробелы в представлениях людей. И самым грустным для меня было то, что это происходит в минуты, когда технический прогресс формирует наше будущее, меняет привычные правила игры, определяет грядущий взлёт и упадок гигантских компаний и целых отраслей. Разруха в головах — явление чрезвычайно опасное, когда многим из этих голов предстоит завтра принимать решения, определяющие важнейшие направления научно-исследовательских и опытно-конструкторских работ, решения о финансировании тех или иных проектов, о приоритетах образования и социальной политики. Наивно было бы полагать, что отдельные научно-популярные лекции или книги могут радикально изменить ситуацию, но в то же время ещё глупее было бы запереться в «башне из слоновой кости» и надеяться, что проблема решится сама собой.

Мне трудно однозначно определить жанр этой книги.

С одной стороны, я попытался провести читателя по извилистым тропам, проложенным наукой и технологиями в поисках святого Грааля искусственного интеллекта. Ведь изучение предмета в развитии позволяет лучше понять его внутренние взаимосвязи, глубже постичь природу явления. Мне кажется, что это хороший антидот против поспешных действий и однобоких суждений. Рассказывая об истории технологий искусственного интеллекта, я сделал акцент на решениях, принимавшихся ключевыми действующими лицами «на распутье», и на причинах этих решений. Меня интересовали не только сухие биографические факты и объективные условия, в которых приходилось действовать людям, вершившим технологическую историю человечества, но и особенности их характера, их ценности и жизненные приоритеты. Именно поэтому предметно-именной указатель в этой книге получился весьма объёмным.

С другой стороны, значительная часть книги посвящена современным достижениям в области машинного обучения — здесь вы найдёте описание многих современных исследований и ссылки на них, рассказ о лучших и перспективных моделях, численные оценки прогресса, достигнутого в решении различных задач искусственного интеллекта. Также я постарался уделить внимание актуальным проблемам отрасли (как «распиаренным», так и известным лишь небольшому кругу специалистов) и намеченным путям их решения. Среди этих проблем не только технологические, но и социальные — ведь практически любые значимые достижения технологий приводят к видимым последствиям для общества, которые нельзя просто игнорировать.

Книга не требует от читателя какой-то особенной подготовки — бо́льшая её часть будет хорошо понятна любому студенту или учащемуся старших классов общеобразовательной школы. По завету Стивена Хокинга я старался уменьшить число формул в книге, и, хотя их число не удалось сократить до нуля, вы не найдёте здесь ничего, что потребовало бы от читателя глубоких познаний в области вершин арифметики. В целом я попытался найти разумный баланс, который сделал бы книгу интересной совершенно разным людям: радикальным технарям и бескомпромиссным гуманитариям, управленцам и рядовым сотрудникам, молодым людям и убелённым сединами старцам. Не знаю, насколько хорошо мне удалось решить эту задачу и не было ли это фатальной ошибкой — ответ на этот вопрос может дать только время. Я очень надеюсь, мой дорогой читатель, что эта книга понравится лично вам. В любом случае я буду очень благодарен за любые отзывы, указания на неточности, различные замечания и предложения, которые помогут улучшить эту книгу в будущем. Их можно отправлять мне в виде сообщений в социальных сетях или по адресу моей личной электронной почты: sergei.markoff@gmail.com.

Приятного вам чтения!

Договоримся об определениях

Узнал. Узнал, как обманчива бывает внешняя красота.

Смотришь снаружи — вскормленные жёлтыми тюльпанами овцы.

А удастся заглянуть глубже — ни жёлтых тюльпанов, ни пищеварительных органов, ни результатов пищеварения — одна лишь пугающая бездонная пустота.

Денис Яцутко. Табань!

Причина многих ожесточённых и бесплодных споров с давних времён — в том, что спорщики, сами того не замечая, вкладывают в один и тот же термин совершенно разный смысл. Эталонным примером такой ситуации, наверное, можно назвать неутихающие более полувека споры об искусственном интеллекте.

Это понятие, появившись изначально в научной сфере среди специалистов, работавших в области вычислительной техники, довольно быстро просочилось в искусство и поп-культуру, где претерпело весьма причудливые изменения: сейчас представление случайно взятого человека об искусственном интеллекте, скорее всего, основано не на работах учёных, а на фильме «Терминатор».

Автор термина — Джон Маккарти, американский информатик (и, между прочим, изобретатель языка Lisp) — предложил его на границе 1955–1956 гг. Определение Маккарти звучало следующим образом: «Искусственный интеллект — наука и инженерная деятельность, направленная на создание умных [intelligent] машин»[2]. Как часто бывает, название дисциплины стали активно использовать и для обозначения её объекта, то есть самих «умных машин».

На первый взгляд, название, данное создателем, не слишком удачно: его проблема в том, что понятие «умный» само по себе требует определения. Но современникам Маккарти и участникам состоявшейся в 1956 г. первой в истории конференции по искусственному интеллекту всё было более или менее понятно. Дело в том, что исследования в этой области начались задолго до того, как термин появился в его современном виде. В 1950 г. увидела свет статья Алана Тьюринга «Вычислительные машины и разум» (Computing Machinery and Intelligence), содержащая первый детальный анализ вопроса о том, могут ли машины думать. Тремя годами ранее датирована первая дошедшая до нас работа Тьюринга, в которой упоминается «машинный интеллект» [machine intelligence], а вообще, по мнению некоторых исследователей, Тьюринг начал заниматься этим вопросом ещё в 1941 г.[3]

Стюарт Рассел и Питер Норвиг в классической работе «Искусственный интеллект: современный подход» (Artificial Intelligence: A Modern Approach)[4] классифицируют определения искусственного интеллекта исходя из того, на каких свойствах разрабатываемых систем сделан акцент: на действиях [acting] систем или на воплощённых в них принципах рассуждения [thinking]. Это позволяет Расселу и Норвигу разбить все определения искусственного интеллекта на две группы. Далее, внутри каждой группы, может быть сделан акцент на характере действий (или рассуждений) систем — рациональном [rationally] или человекоподобном [humanly]. Таким образом, Рассел и Норвиг выделяют четыре группы определений. Однако, если приглядеться к приведённым ими примерам из трёх разных групп («[Автоматизация] действий, которые мы ассоциируем с мыслительным процессом у людей…»[5], «Изучение вопроса о том, как научить компьютеры делать вещи, которые в настоящее время лучше даются людям», «Изучение принципов вычислений, которые могут сделать возможным восприятие, рассуждение и действие»[6]), можно обнаружить, что они сходятся в одном: искусственный интеллект — это дисциплина, ставящая своей целью создание систем, способных решать интеллектуальные задачи, то есть такие задачи, которые люди традиционно решают при помощи собственного интеллекта. Как выразился Реймонд Курцвейл: «Искусство создания машин, выполняющих функции, требующие интеллекта в случаях, когда их выполняют люди»[7]. Некоторые авторы не могут остановиться на этом и вступают на скользкую дорогу перечисления: «[Автоматизация] действий, которые мы ассоциируем с мыслительным процессом у людей, таких как принятие решений, решение задач, обучение…»[8]

Разумной альтернативой сложившейся практике определения понятия искусственного интеллекта кажется попытка определения понятия «интеллект», но этот подход по сути представляет собой попытку построения множества, основанную лишь на одном бесспорно установленном элементе — человеческом интеллекте. Неясно, какие именно его признаки являются критически важными для того, чтобы приписать наличие интеллекта объекту, не являющемуся человеком. Способность обучаться, наличие сознания?..

Ответы на эти вопросы пытается дать стоящий некоторым особняком от других агентно-ориентированный подход, в основе которого лежит не понятие интеллектуальной задачи, а понятие интеллектуального или рационального агента: «интеллектуальный агент — любое устройство, которое воспринимает своё окружение и осуществляет действия, максимизирующие шансы успешного достижения его целей», а «вычислительный интеллект (computational intelligence) (синоним понятия «искусственный интеллект». — С. М.) — изучение принципов создания интеллектуальных агентов»[9]. Или вот как это сформулировано у Рассела и Норвига: «Агент — это просто нечто, что осуществляет действия (слово происходит от лат. agere, что значит делать). Конечно, все компьютерные программы выполняют какие-то действия, но вычислительные агенты делают большее: оперируют автономно, воспринимают своё окружение, существуют в течение длительного промежутка времени, адаптируются к изменениям, ставят и преследуют цели. Рациональный агент — нечто (некто), что (кто) действует для достижения наилучшего результата или, при наличии неопределённости, наилучшего ожидаемого результата»[10]. Вот что такое агент, а вовсе не умничающий Хьюго Уивинг[11] в чёрных очках и костюме офисного работника.

В общем, сторонники стоящего немного особняком агентно-ориентированного подхода, по сути, выделяют следующие необходимые свойства объекта, обладающего интеллектом: наличие восприятия, наличие целей, способность действовать рационально, то есть выполнять действия, способствующие достижению цели. Рассел и Норвиг добавляют ещё несколько качеств: способность адаптироваться, длительное существование. Лично я против подобных дополнений, так как они, по-моему, лишь увеличивают неопределённость. Начиная с какой секунды жизни начинается «длительное существование»? Можно ли сказать, что запорожец, въехавший под БелАЗ, в некотором роде адаптировался, изменив форму кузова?

Легко заметить, что определение интеллекта, неявно данное сторонниками агентно-ориентированного подхода, описывает нечто существенно более широкое, чем человеческий интеллект. Если бы животные или даже растения были компьютерными программами, мы неизбежно должны были бы отнести их к области искусственного интеллекта.

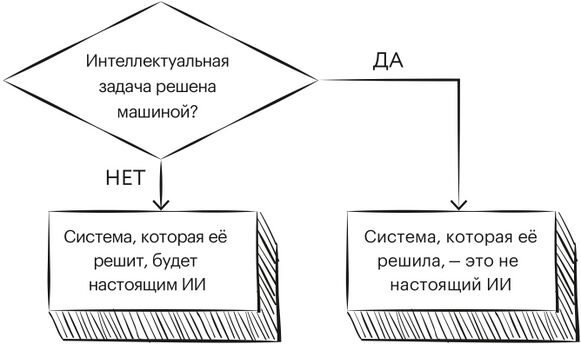

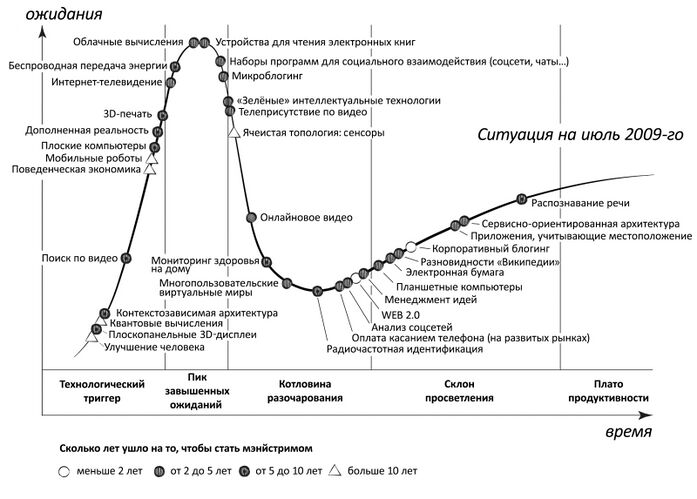

Как мне кажется, агентно-ориентированный подход делает понятие искусственного интеллекта ещё более неопределённым, поэтому в книге я буду придерживаться более классического определения: искусственный интеллект (далее — ИИ, AI, Artificial Intelligence) — область науки и технологии, занимающаяся автоматизацией решения интеллектуальных задач. При этом я осознанно принимаю риск того, что в отношении некоторых задач степень их интеллектуальности может вызывать споры, однако полезность этих споров, на мой взгляд, не превышает полезности приписываемых средневековым схоластам споров о том, сколько ангелов может поместиться на кончике швейной иглы. По мере того как машины справляются со всё большим и большим количеством интеллектуальных задач, общепринятое представление о том, что относится, а что не относится к последним, постепенно меняется. В конце концов, сложение и вычитание чисел в уме человек тоже осуществляет при помощи собственного интеллекта, и ещё 300–400 лет назад машина, способная выполнять арифметические операции, была настоящим чудом техники. Сегодня же этим уже никого не удивишь. В 1960-е мы мечтали о машинах, способных выигрывать у сильнейших шахматных игроков, и если в те времена вы бы спросили обывателя: является ли системой искусственного интеллекта машина, способная выиграть в шахматы у чемпиона мира, то почти наверняка получили бы утвердительный ответ. Сегодня многие люди лишь брезгливо поморщатся при упоминании шахматных программ: подумаешь, не очень-то это интеллект, просто быстрый перебор вариантов! Несколько лет назад к этой тираде, весьма вероятно, добавилось бы рассуждение об игре го: вот когда машины смогут обыграть чемпиона мира по го, тогда и посмотрим! Интересно будет понаблюдать за тем, какая из сложных интеллектуальных задач теперь, после успехов AlphaGo и AlphaZero, займёт в массовом сознании место достойной истинного ИИ.

Это явление массового сознания с лёгкой руки писательницы и специалистки по истории ИИ Памелы Маккордак получило наименование «эффект ИИ».

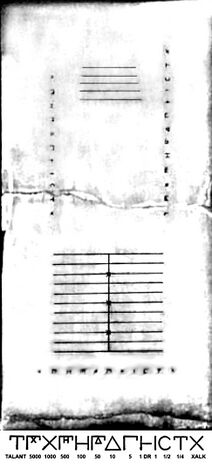

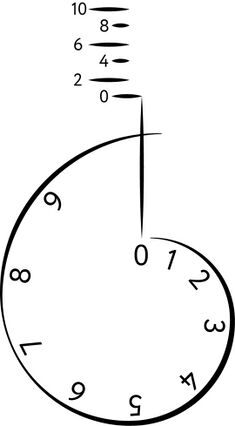

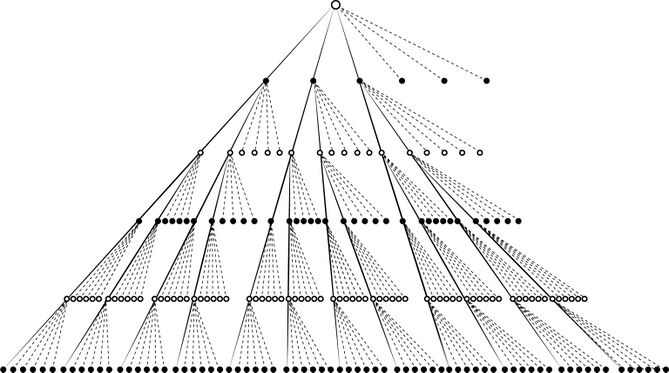

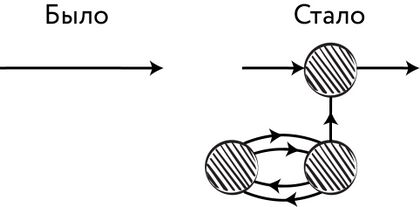

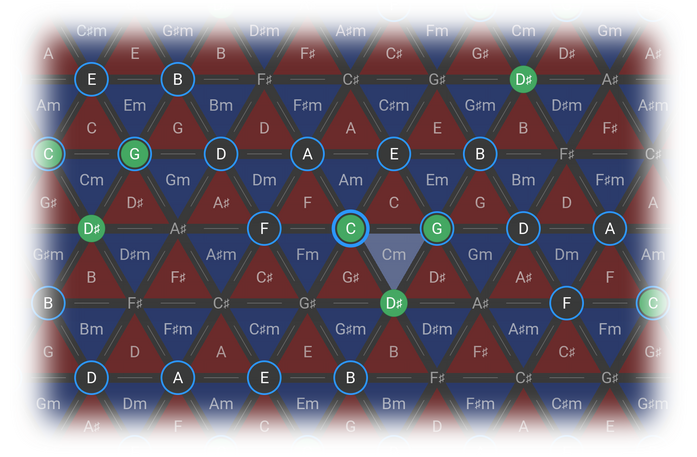

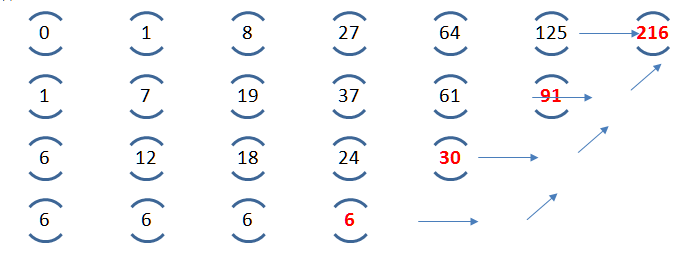

Рис. 1. Эффект ИИ

«…Каждый раз, когда кто-то находил способ научить компьютер что-то делать — хорошо играть в шашки, решать простые, но относительно неформальные задачи, — раздавался хор критиков, заявлявших, что это не мышление», — пишет Маккордак. То есть некоторые люди полагают, что как только ИИ успешно решает ту или иную задачу, она тут же перестаёт относиться к области ИИ. Маккордак называет «странным парадоксом» тот факт, что «практические успехи ИИ, программы, которые достигали разумного поведения, быстро входили в состав прикладных областей, где они оказывались полезными, становились молчаливыми помощниками наряду с другими подходами к решению задач, оставляя исследователей в области ИИ в компании одних лишь „неудач“, крепких орешков, которые ещё не удалось расколоть»[12].

Как говорит австралийский робототехник и исследователь ИИ Родни Брукс: «Каждый раз, когда мы понимаем что-либо, оно перестаёт быть магией, и мы говорим: „О, это просто вычисление“»[13]. Ларри Теслеру приписывают изобретение «теоремы Теслера»: «ИИ — это то, что ещё не создано» [Artificial Intelligence is whatever hasn’t been done yet][14]. Впрочем, сам Теслер утверждает, что это неточная цитата. В действительности он говорил, что «интеллект — это всё то, что машины пока не умеют делать» (Intelligence is whatever machines haven’t done yet)[15]. Так или иначе, следует признать мудрость человека, который подарил человечеству клавиатурные сочетания Ctrl + C и Ctrl + V.

Похожая ситуация, как мне кажется, наблюдается и в других дисциплинах. Например, никто всерьёз не назовёт человека, освоившего правило сложения в столбик и способного доказать на школьной доске теорему Пифагора, математиком, хотя арифметика и планиметрия по-прежнему остаются разделами математики и вряд ли это когда-нибудь изменится. А в отношении постоянного роста требований к ИИ я не могу удержаться от цитаты из монолога американского комика Луи Си Кея: «Люди жалуются на задержки вылетов. Из Нью-Йорка в Калифорнию — пять часов пути. Когда-то это занимало 30 лет. По дороге кто-то умер бы, а кто-то родился. На место прибыла бы совершенно другая группа людей. Сейчас ты посмотришь кино, сходишь на горшок — и уже дома».

Понятие ИИ. Прикладной/слабый ИИ, сильный ИИ (AGI)

В силу того, что искусственный интеллект — понятие чрезвычайно широкое, возникли термины для конкретизации того, с каким именно явлением мы имеем дело. Сегодня традиционным стало разделение систем ИИ на два вида. Первый из них — «слабый» [weak], «специализированный» [narrow] или «прикладной» [applied], то есть предназначенный для решения какой-то одной, отдельной интеллектуальной задачи или их небольшого множества. Второй вид — «сильный» [strong] или «универсальный» [general] ИИ, к нему относят гипотетические системы, способные, подобно человеческому интеллекту, решать неопределённо широкий спектр интеллектуальных задач.

Интересно, что изначально термин «сильный искусственный интеллект» (strong AI) означал не совсем то, что часто означает сегодня. Его автор, философ Джон Сёрль, ввёл его для того, чтобы отличать систему, которая «ведёт себя так, как будто является разумной» [can (only) act like it thinks and has a mind], от системы, которая «на самом деле» обладает разумом [can think and have a mind][16]. В современных работах понятия «сильный ИИ» и «гипотеза сильного ИИ» иногда используют в оригинальном, сёрлевском смысле, но ряд исследователей, к которым относится, например, уже упоминавшийся Реймонд Курцвейл, считают, что термин «сильный ИИ» описывает любую систему ИИ, которая действует так, как будто обладает разумом, вне зависимости от того, способны ли философы определить, «в самом ли деле» она им обладает[17].

Для того чтобы не допускать путаницы и разночтений, многие исследователи предпочитают использовать термин artificial general intelligence (общий/универсальный искусственный интеллект), обычно его употребляют в виде аббревиатуры — AGI.

Занятно, что впервые термин появился в работе Марка Губруда «Нанотехнологии и международная безопасность», посвящённой военным применениям технологий будущего. Автор даёт AGI следующее определение: «Под продвинутым универсальным ИИ я понимаю системы ИИ, способные соперничать с человеческим мозгом или превосходить его в сложности и скорости, которые способны получать общие сведения, манипулировать ими и выстраивать рассуждения и которые могут использоваться, по сути, в любой фазе индустриальных или военных операций, в которой был бы необходим человеческий интеллект. Эти системы могут быть основаны на моделировании человеческого мозга, но это не является необходимым требованием, они не должны также обязательно обладать „сознанием“ или любой другой компетенцией, не имеющей прямого отношения к их применению. Что важно, так это то, что эти системы могут быть использованы для замены человеческих мозгов в задачах, начиная от организации и запуска шахты или фабрики и заканчивая пилотированием самолёта, анализом разведданных или планированием боевых действий»[18]. Сейчас AGI определяют обычно несколько проще: «AGI — искусственный интеллект, способный успешно выполнить любую интеллектуальную задачу, посильную для человека»[19].

Тест Тьюринга, китайская комната Сёрля

В конце 30-х гг. прошлого века, ещё до того, как были созданы первые электронные вычислительные машины, вопросами потенциальной «разумности» машин стали задаваться люди, формально далёкие от компьютерных наук. Если нечто выглядит как кошка, мяукает как кошка, ведёт себя как кошка, в любом эксперименте проявляет себя как кошка, то, наверное, это кошка. Этот подход использовал Альфред Айер — английский философ-неопозитивист, представитель аналитической философии. В книге «Язык, истина и логика» (Language, Truth and Logic, 1936) он предложил алгоритм распознавания разумного человека и неразумной машины: «Единственным основанием, на котором я могу утверждать, что объект, который кажется разумным, на самом деле не разумное существо, а просто глупая машина, является то, что он не может пройти один из эмпирических тестов, согласно которым определяется наличие или отсутствие сознания»[20]. Впрочем, Айер, будучи философом, наверняка был в курсе остроумного замечания Дидро: «Если удастся найти попугая, способного ответить на любой вопрос, я не раздумывая признаю его разумным»[21].

Доподлинно неизвестно, был ли Алан Тьюринг знаком с трудами Айера или Дидро, но именно он вошёл в историю в качестве автора конкретной процедуры для определения способности машины мыслить. Сегодня она известна нам под названием «тест Тьюринга».

В работе «Вычислительные машины и разум» (1950) Тьюринг пишет:

Эта новая форма проблемы может быть описана с помощью игры, которую мы назовём «игрой в имитацию». В этой игре участвуют три человека: мужчина (A), женщина (В) и кто-нибудь, задающий вопросы (С), которым может быть лицо любого пола. Задающий вопросы отделён от двух других участников игры стенами комнаты, в которой он находится. Цель игры для задающего вопросы состоит в том, чтобы определить, кто из двух других участников игры является мужчиной (A), а кто — женщиной (В). Он знает их под обозначениями X и Y и в конце игры говорит либо: «X есть А, и Y есть В», либо: «X есть В, и Y есть А». Ему разрешается задавать вопросы такого, например, рода: С: «Попрошу X сообщить мне длину его (или её) волос». Допустим теперь, что в действительности X есть А. В таком случае А и должен давать ответ. Для А цель игры состоит в том, чтобы побудить С прийти к неверному заключению. Поэтому его ответ может быть, например, таким: «Мои волосы коротко острижены, а самые длинные пряди имеют около девяти дюймов в длину». Чтобы задающий вопросы не мог определить по голосу, кто из двух других участников игры мужчина, а кто — женщина, ответы на вопросы следовало бы давать в письменном виде или, ещё лучше, печатать на машинке. Идеальным случаем было бы телеграфное сообщение между комнатами, где находятся участники игры. Если же этого сделать нельзя, то ответы и вопросы может передавать какой-нибудь посредник. Цель игры для третьего игрока — женщины (В) — состоит в том, чтобы помочь задающему вопросы. Для неё, вероятно, лучшая стратегия — давать правдивые ответы. Она также может делать такие замечания, как: «Женщина — я, не слушайте его!», но этим она ничего не достигнет, так как мужчина тоже может делать подобные замечания. Поставим теперь вопрос: «Что произойдёт, если в этой игре вместо А будет участвовать машина?» Будет ли в этом случае задающий вопросы ошибаться столь же часто, как и в игре, где участниками являются только люди? Эти вопросы и заменят наш первоначальный вопрос «могут ли машины мыслить?»[22].

В некоторых источниках сообщается, что в основу процедуры, предложенной Тьюрингом, легла салонная «игра в имитацию», популярная в Викторианскую эпоху[23] и известная Тьюрингу с юности[24] (оставим здесь за скобками тот факт, что юность Тьюринга более чем на два десятилетия отстояла от Викторианской эпохи, — в конце концов, почему бы юношам в 1920-е не играть в некоторые викторианские игры?). В других источниках «игра в имитацию» упоминается просто как популярное времяпрепровождение на вечеринках[25]. Мне, однако, не удалось обнаружить ни одного упоминания подобной игры вне связи с тестом Тьюринга. Молодёжь Викторианской эпохи, конечно, знала толк в изощрённых забавах, иногда требовавших продемонстрировать искусство имитации. Например, при игре в «Придворные» (The Courtiers) один из гостей, выбранный королём или королевой, садился в центре комнаты, а остальные, исполнявшие роли придворных, должны были имитировать все его действия, сохраняя серьёзные лица. Если придворный улыбался или начинал смеяться, он выбывал из игры и должен был выполнить фант. Последний из гостей, продемонстрировавший наибольшую выдержку, становился новым монархом. Использование подобной процедуры в научных исследованиях, конечно, могло бы серьёзно разнообразить работу учёных, но, боюсь, надежд на это пока что немного.

Итак, Тьюринг предлагает игру с анонимным участником, который может быть либо машиной, либо человеком: взаимодействие осуществляется посредством телетайпа или любого иного способа, придающего сообщениям обезличенную форму. Тест считается успешно пройденным в случае, если машине удалось выдать себя за человека.

Отметим важную особенность теста Тьюринга: он предлагает чисто поведенческий критерий наличия интеллекта, не требующий анализа внутреннего строения объекта. Тьюринг отмечает, что мы приписываем интеллект другим людям, пользуясь именно этим критерием, ведь мы никак не можем залезть в сознание другого человека.

Тьюринг решительно отстаивает идею о том, что не существует принципиально непреодолимых препятствий на пути создания машины, способной пройти его тест, он последовательно приводит и опровергает девять аргументов против возможности создания такого искусственного интеллекта.

Вокруг теста Тьюринга, несмотря на прозрачность предложенного автором подхода, существует изрядное количество путаницы. Виноват в этом отчасти и сам Тьюринг, который в своей работе, по сути дела, описывает две несколько отличающиеся друг от друга процедуры. Кроме того, в 1951 г. в передаче на радио Би-би-си (BBC, British Broadcasting Corporation, Британская вещательная корпорация) Тьюринг предлагает третью формулировку теста[26].

Итак, путаница начинается со статьи 1950 г., в которой Тьюринг сначала описывает игру, в которой участвует женщина, пытающаяся своими ответами помочь задающему вопросы, а также мужчина, стремящийся выдать себя за женщину. Далее Тьюринг рассматривает возможность замены мужчины на машину. Получающаяся в результате процедура сегодня носит наименование «Оригинальный тест игры в имитацию» (Original Imitation Game Test, или сокращённо OIG).

В конце V части статьи Тьюринг ВНЕЗАПНО даёт несколько отличающееся описание процедуры: «Если взять только одну конкретную цифровую вычислительную машину Ц, то спрашивается: справедливо ли утверждение о том, что, изменяя ёмкость памяти этой машины, увеличивая скорость её действия и снабжая её подходящей программой, можно заставить Ц удовлетворительно исполнять роль А в „игре в имитацию“ (причём роль В будет исполнять человек [man])?»

Лёгким движением руки «женщина» превратилась в «мужчину» или даже в «человека» вообще, как разумно предполагает переводчик на русский язык. Если мы согласимся с переводчиком, то полученный вариант процедуры (в котором машина стремится выдать себя за человека, а не за конкретно женщину, в то время как человек B старается помочь задающему вопросы) будет называться стандартным тестом Тьюринга (Standard Turing Test, STT). Конечно, возможна альтернативная интерпретация, в которой на месте женщины в игре оказывается мужчина A из оригинальной игры в имитацию, стремящийся, как и машина, выдать себя за женщину. В таком случае машина и мужчина будут соревноваться в искусстве выдачи себя за другого перед лицом задающего вопросы[27].

Из записи радиопередачи 1951 г. становится ясно, что Тьюринг всё-таки не делал различия между словами man и human. Версия теста, предложенная радиослушателям, по сути дела, повторяет STT с той лишь разницей, что на место человека, задающего вопросы, приходит жюри и целью машины становится обмануть существенную долю его участников.

Отдельный важный вопрос практической организации тестирования состоит в том, должен ли задающий вопросы знать, что один из его собеседников — машина. В оригинальном описании теста ничего не говорится об этом, а современные исследовательские стандарты предполагают использование в подобных экспериментах контроля и двойного слепого метода[28]. Словом, сегодня валидным вариантом теста Тьюринга считается версия STT с жюри, контрольной группой и двойным слепым методом проведения испытаний.

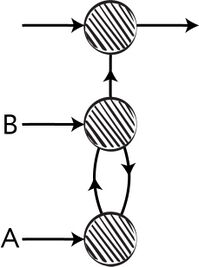

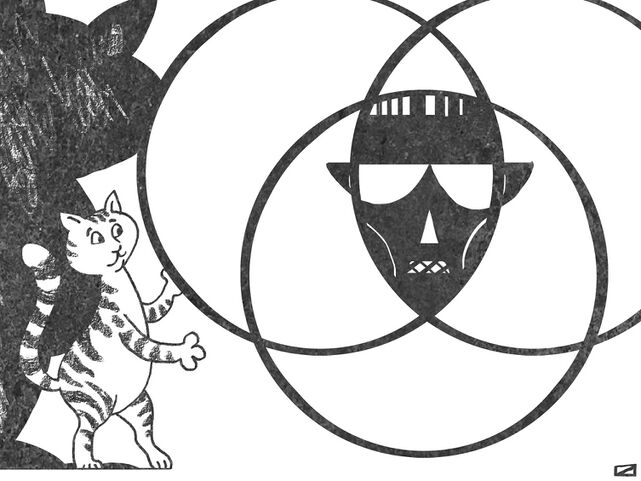

Рис. 2. Игра в имитацию и две различные версии теста Тьюринга из статьи 1950 г.

Наверное, самым известным возражением на предложенную Тьюрингом процедуру стал ответ философа Джона Сёрля, который предложил мысленный эксперимент, получивший название «китайской комнаты». Представим себе закрытую комнату, в которую передают вопросы, написанные на китайском языке, и из которой получают ответы, опять же написанные на китайском. В комнате находится человек, не говорящий по-китайски (для простоты далее будем считать, что это сам Джон Сёрль), который понимает английский язык и использует набор правил, написанных по-английски, с китайскими иероглифами, предназначенными для записи ответов. Таким образом, человек, пишущий вопросы по-китайски и получающий из комнаты ответы, может сделать вывод, что внутри комнаты находится некто, способный понимать китайский язык. Но, по условию задачи, это не так. Следовательно, процедура, построенная только на изучении коммуникативного поведения объекта, подобная тесту Тьюринга, приводит нас к неправильному умозаключению.

Вокруг аргумента Сёрля развернулась весьма масштабная полемика, различные нюансы которой весьма детально разобраны в статьях Пола Кокшотта «Бёттке, синтаксис и тест Тьюринга» (Boettke, Syntax and the Turing Test)[29] и Лоуренса Ландау «Философская ошибка Пенроуза» (Penrose’s Philosophical Error)[30]. Здесь мы рассмотрим только два из основных аргументов против мысленного эксперимента Сёрля.

Первый и наиболее известный из них получил название «системный аргумент». Он сводится к тому, что даже если сам Сёрль, в соответствии с условиями эксперимента, не понимает китайский язык, тем не менее систему, состоящую из набора правил и самого Сёрля, вполне можно охарактеризовать как понимающую китайский. Если мы посмотрим на человеческий мозг, то легко заметим, что он состоит из различных элементов. Можно ли считать, что каждая взятая по отдельности часть мозга разумна? Разумны ли взятые порознь отделы мозга? Нейроны? Атомы углерода?

Суть второго популярного возражения, аргумента «другие умы», состоит в следующем: если вы отказываете китайской комнате в понимании языка, то вы не можете быть уверенными в том, что кто-то, кроме вас, вообще что-то понимает, поскольку всё, с чем вы имеете дело, — это только поведение других людей.

В целом аргументы Сёрля и его сторонников, например Роджера Пенроуза, вызывают ассоциации с витализмом, то есть учением о наличии в живых организмах нематериальной сверхъестественной силы, управляющей жизненными явлениями, — «жизненной силы» (лат. vis vitalis) («души», «энтелехии», «археи» и проч.). Теория витализма постулирует, что процессы в биологических организмах зависят от этой силы и не могут быть объяснены с точки зрения физики, химии или биохимии. Когда-то виталисты утверждали, что органическую материю нельзя получить из неорганической. Затем, по мере прогресса в химии, границы «невозможного» постепенно стали сдвигаться, теперь уже невозможным объявлялось создание сложных органических соединений, а после успешного освоения их синтеза — создание живого организма. Теперь очередным «непреодолимым» рубежом стал человеческий разум, при этом роль жизненной силы у Сёрля выполняет «каузальная мощь человеческого мозга»[31], а у Пенроуза — квантовая природа сознания[32], [33].

Велико ли значение теста Тьюринга в наши дни? С одной стороны, искусственный интеллект, способный пройти тест Тьюринга или по крайней мере приблизиться к его прохождению, должен демонстрировать решение важных практических задач: понимание естественного языка и умение производить произвольные рассуждения. С другой стороны, некоторые современные исследователи в области искусственного интеллекта считают, что сегодня попытки создания системы для прохождения теста Тьюринга — это лишь отвлечение внимания от более плодотворных направлений исследований[34]. Действительно, тест Тьюринга не является сегодня областью, популярной в рамках академических или коммерческих проектов. Рассуждая о причинах такого положения дел, Рассел и Норвиг приводят забавную аналогию с историей создания самолёта: «В инженерных текстах по авиационной технике, — пишут они, — нигде не говорится о том, что целью этой области является „создание машин, способных летать подобно голубям настолько, чтобы они могли обмануть других голубей“»[35].

Сегодня тест Тьюринга относят к группе так называемых ИИ-полных (AI-complete) задач, то есть таких задач, сложность которых делает их решение эквивалентным созданию AGI[36]. К таким задачам обычно относят задачу понимания естественного языка, машинный перевод, решение тестов Бонгарда[37] и тому подобное. Важно заметить, что ИИ-полнота — неформальный термин, так как строгого доказательства необходимости AGI для решения всех этих задач пока что не существует.

Тьюринг стремился дать чёткий и понятный пример, необходимый в дискуссии о философии искусственного интеллекта. Как заметил Джон Маккарти: «Маловероятно, что [философия ИИ] окажет больший эффект на практические исследования в области ИИ, чем философия науки в целом — на саму науку»[38].

Впрочем, некоторое отношение к современной практике тест Тьюринга всё-таки имеет, в одном из хорошо всем известных вариантов. Наверняка вам не раз приходилось вводить цифры или буквы с картинок, чтобы доказать, что вы не робот. Подобного рода тесты получили название «кáпча»[39]. В 2013 г. каждый день пользователям во всём мире приходилось проходить подобные тесты примерно 320 млн раз[40]. Старт этому масштабному противостоянию снаряда и брони был дан в 1997 г.[41], и с тех пор тесты постоянно приходится усложнять из-за появления всё новых и новых систем ИИ, способных справиться с их прохождением. Позже мы ещё несколько раз вернёмся к тесту Тьюринга — например, когда будем обсуждать прогресс в области обработки машинами естественного языка, а сейчас перейдём к не менее животрепещущей теме — машинному обучению.

Машинное обучение, его виды и области применения

Одно из распространённых заблуждений об искусственном интеллекте заключается в уверенности, что машины не могут учиться и, решая задачу, способны лишь следовать алгоритму — жёстко заданному программистами пошаговому сценарию.

В действительности то, что машины исполняют определённую программу, никак не мешает им учиться, для этого нужно только, чтобы программа воплощала тот или иной алгоритм обучения. В принципе, единственным необходимым для обучения условием является наличие у машины изменяемой памяти, но этим свойством машины обладают с давних пор.

В качестве самого простого примера обучения можно привести программу, которая при первом запуске спрашивает имя пользователя, которое затем запоминает, чтобы при следующих запусках обращаться к этому человеку по имени. Легко заметить, что поведение программы от запуска к запуску поменяется, то есть программа «научится» правильно обращаться к вам, хотя программисты, создавая программу, не указывали в ней вашего имени. Конечно, обучение может быть разным: как и человек, одним вещам машина может обучиться с лёгкостью, другие же пока что находятся за пределами возможностей современных технологий ИИ, и эта граница постоянно сдвигается по мере того, как очередные задачи сдаются под напором достижений науки и технологии.

Машинное обучение (machine learning) — направление в искусственном интеллекте, обычно использующее статистические техники для придания компьютерам способности «обучаться» (т. е. постепенно улучшать результаты, достигаемые при решении той или иной задачи), основываясь на некоторых данных, без явного программирования. Термин был изобретён Артуром Сэмюэлом в далёком 1959 г.[42] Выражаясь более формально, можно сказать, что машинное обучение занимается созданием систем ИИ, в которых параметры моделей вычисляются в ходе автоматического или автоматизированного процесса обучения. Машинное обучение тесно связано с такими направлениями, как вычислительная статистика и теория оптимизации: эти дисциплины выступают в роли поставщиков конкретных методов и инструментов, применяемых в машинном обучении.

Большинство современных прикладных систем искусственного интеллекта созданы с привлечением методов машинного обучения. Поэтому может показаться, что искусственный интеллект и машинное обучение почти тождественны, но на самом деле это не так. Со многими практическими задачами неплохо справляются старые добрые запрограммированные правила. Далее в книге мы увидим несколько примеров того, как построенные на основании правил системы могут демонстрировать весьма интеллектуальное поведение, производящее большое впечатление на внешнего наблюдателя.

И всё же сложнейшие из задач искусственного интеллекта требуют гораздо более гибких и мощных методов, поэтому машинное обучение сегодня — самое быстроразвивающееся направление в отрасли.

Виды машинного обучения

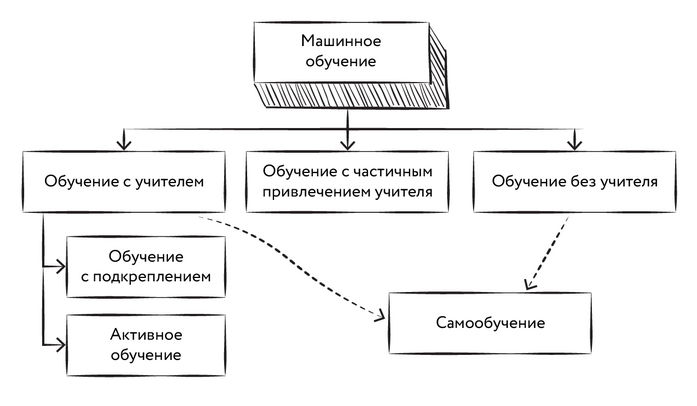

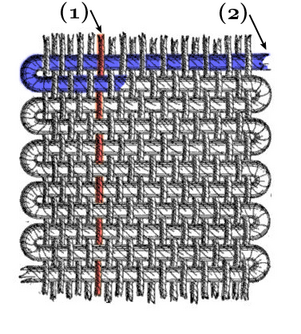

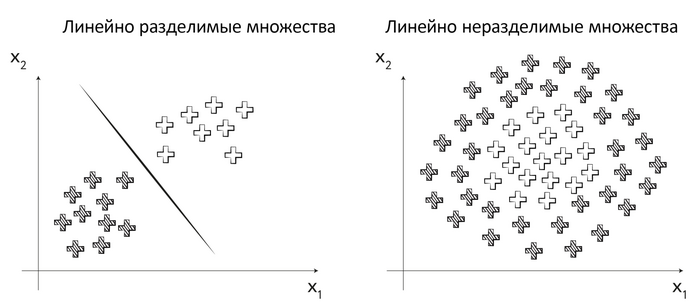

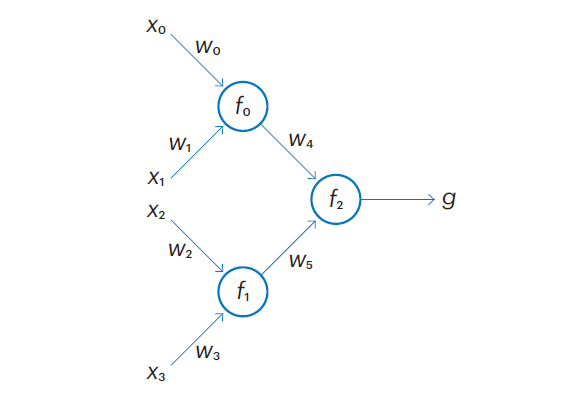

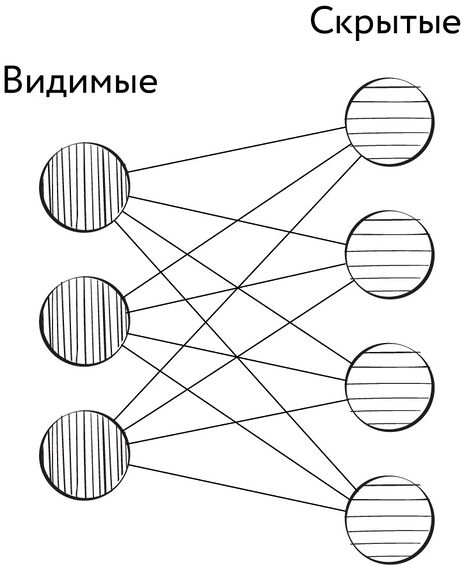

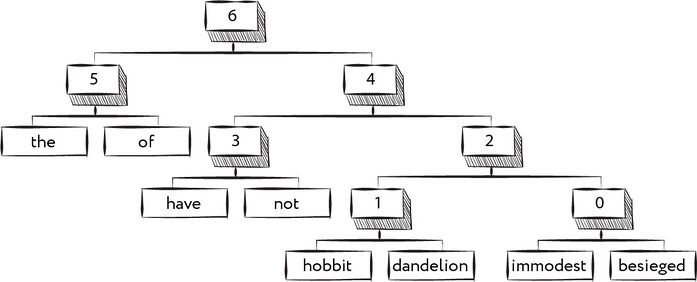

Рис. 3. Виды машинного обучения

Обычно машинное обучение разделяют на две большие категории в зависимости от наличия в обучающей системе обратной связи — некоторого сигнала, получаемого системой и содержащего информацию о том, является ли выбранное обучаемой моделью действие правильным (или неправильным). При наличии обратной связи задача машинного обучения называется задачей обучения с учителем [supervised learning].

Часто в качестве обратной связи используется ручная разметка, выполненная людьми. Например, обучая модель отличать изображения кошек от изображений собак, мы можем отобрать несколько десятков тысяч фотографий и вручную сопоставить каждой из них правильную метку — «кошка» или «собака». Такой набор данных, содержащий исходные данные (в нашем случае — фотографии) и метки, называется обучающей выборкой, а каждая пара, состоящая из исходных данных и ответа на них (в нашем случае — метки класса), — прецедентом[43].

Иногда обучающая выборка по тем или иным причинам содержит пробелы. Например, маленький ребёнок не знает вкуса многих объектов, встречающихся в окружающем мире, поэтому с особым интересом запихивает в рот те предметы, которые ему ранее не приходилось пробовать. В таком случае можно говорить о том, что мы имеем дело с активным обучением — ещё одной разновидностью обучения с учителем. При таком подходе модель сама выбирает необходимые для обучения эксперименты и пополняет их результатами обучающую выборку. Конечно, при этом следует заботиться о том, чтобы последствия экспериментов не обошлись нам слишком дорого.

Активное обучение является частным случаем парадигмы, получившей название «обучение с подкреплением» [reinforcement learning]. Термин «подкрепление» (положительное или отрицательное) был позаимствован у психологов, под ним понимается ответный сигнал внешней среды, который позволяет обучающемуся агенту делать выводы о желательности или нежелательности выполненных действий. Обучение с подкреплением не обязано быть активным в том смысле, что агент не обязательно должен руководствоваться определённой «исследовательской» стратегией при выборе действий, агент не обязан быть «любопытным», его действия вполне могут быть обусловлены стремлением увеличить подкрепление в моменте («пихаем в рот то, что предполагаем вкусным, а не то, что ещё не пробовали») или быть и вовсе случайными («едим что попало»). Даже в таком случае обучение иногда может вполне успешно достигать поставленной цели.

На другом полюсе машинного обучения находятся методы обучения без учителя [unsupervised learning]. Казалось бы, будучи лишённым образца для подражания или какого-либо ориентира, ничему научиться нельзя. Однако это не так. Например, изучая недешифрованную письменность, можно выделить наборы повторяющихся знаков и их последовательностей, составить алфавит, оценить частоту возникновения последовательностей знаков, чтобы затем попытаться соотнести её с данными, полученными для других, известных нам языков. Конечно, набор задач, которые можно решить подобными способами, гораздо скромнее, чем в случае обучения с учителем, но в некоторых случаях, как в примере с недешифрованной письменностью, у нас просто нет выбора.

В последние годы с лёгкой руки известного исследователя в области нейронных сетей Яна Лекуна часто используется термин self-supervised learning (самообучение, самоконтролируемое обучение, обучение в режиме «сам себе учитель»). В его основе лежит автоматическая генерация обратной связи на основе структуры данных, используемых при обучении[44]. Например, модель, которая предсказывает следующее слово в тексте по предшествующим, или модель, угадывающая скрытую часть картинки по её видимой части, вроде бы не требует размеченных людьми данных — достаточно лишь набора текстов или изображений, а разметку выполняет алгоритм. В случае задачи с текстом он создаёт из набора текстов множество прецедентов, в которых роль правильного ответа выполняет слово, продолжающее последовательность предшествующих ему слов, которые алгоритм включает в число факторов. В случае с картинкой факторами становятся видимые части изображения, а правильным ответом — скрытая его часть. Таким образом, самообучение можно рассматривать или как разновидность обучения без учителя, или как разновидность обучения с учителем, в которой роль суррогатного учителя выполняет алгоритм авторазметки.

В принципе, методы обучения с учителем и без учителя нередко могут комбинироваться в одной задаче. В таком случае принято говорить о методе обучения с частичным привлечением учителя [semi-supervised learning]. Например, создавая систему для распознавания речи, мы можем привлечь сравнительно небольшой набор размеченных вручную данных (аудиозаписей, снабжённых текстом выполненной людьми расшифровки) и огромный массив неразмеченных, «сырых» аудиозаписей. При помощи второго массива мы обучим модель различать регулярно повторяющиеся звуковые элементы речи — фонемы, — а затем при помощи первого массива научим её превращать последовательность фонем в текст.

Задачи, решаемые с помощью машинного обучения

Среди задач, решаемых при помощи методов машинного обучения, выделяют несколько крупных категорий.

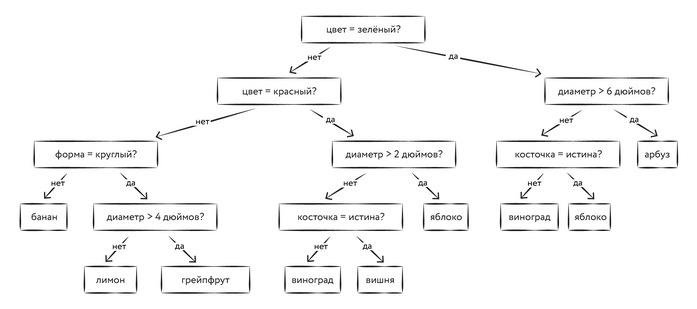

- Задачи классификации. Цель модели в них — отнесение объекта на основании его известных свойств к некоторым группам (классам). Иногда классы называют образами, в таком случае говорят о задачах распознавания образов[45]. Именно к этому типу относится задача различения кошек и собак на фото. В данном случае «кошка» и «собака» — это два разных класса, а известные свойства, или факторы, модели — это цвет каждой из точек на фотографии. Например, если мы имеем дело с чёрно-белыми фотографиями разрешением 1024 × 1024 точки, то всего у нас будет 1 048 576 входных факторов модели (цвет каждой точки будет представлен числом, характеризующим степень её яркости). При решении задачи классификации модель (в данном случае её называют классификатором), обучившись на некотором наборе объектов, должна будет уметь отнести к тому или иному классу в том числе и новые объекты, которых в обучающей выборке не было. Потому что классификаторы, просто запоминающие всё, что им предъявили, и неспособные сделать вывод в отношении чего-то отсутствующего в обучающей выборке, нам обычно не очень интересны.

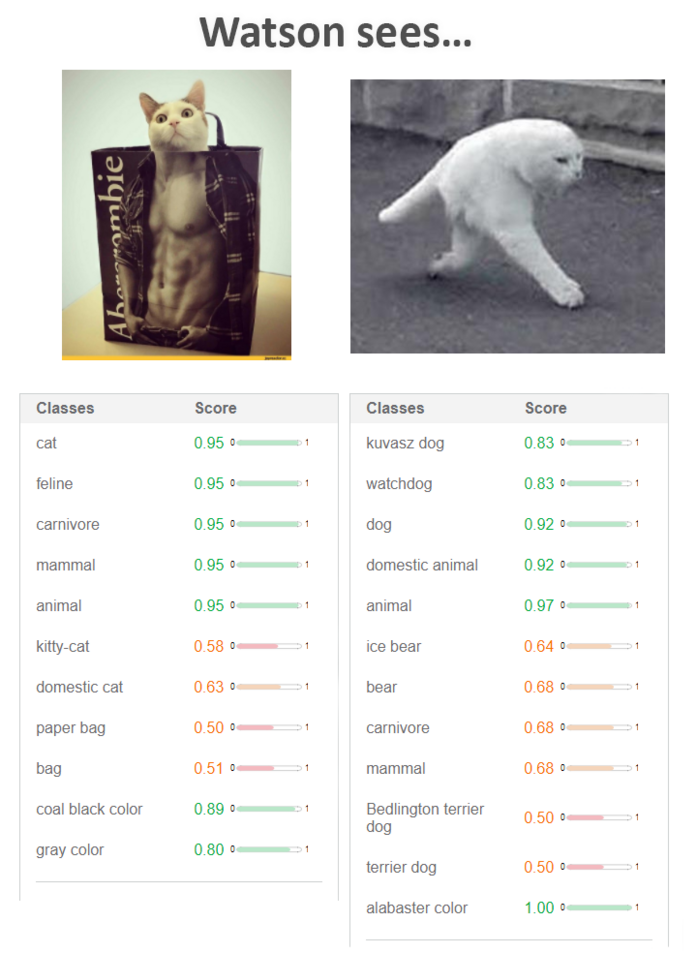

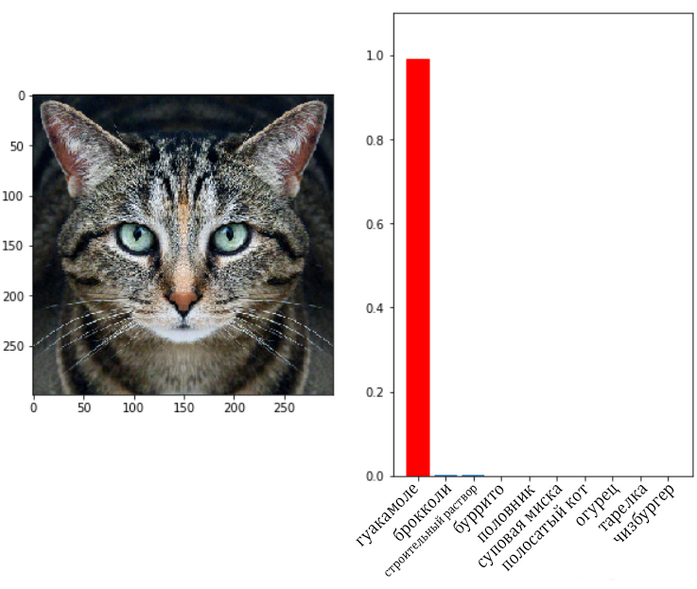

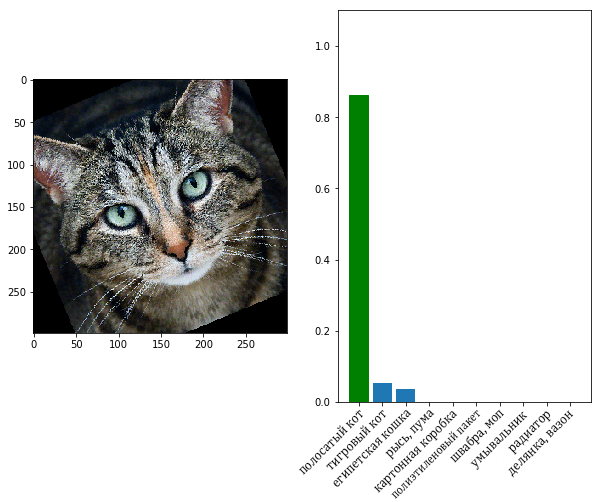

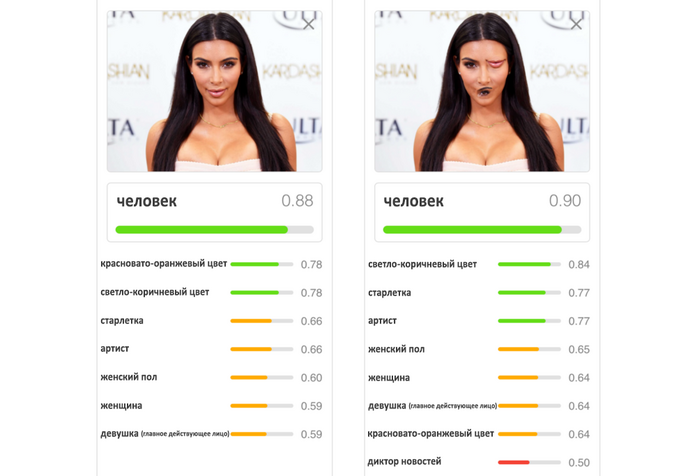

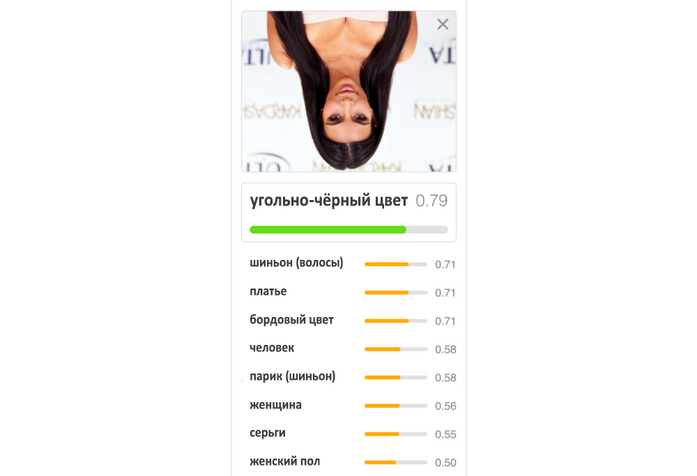

Рис. 4. Примеры решения задачи классификации для изображений. Модель посчитала, что первое изображение со степенью уверенности в 95% принадлежит к следующим классам: «кот» (cat), «животное семейства кошачьих» (feline), «хищник» (carnivore), «млекопитающее» (mammal), «животное» (animal). Далее следуют классы с меньшей степенью уверенности модели: «кошечка» (kitty-cat) — 58%, «домашняя кошка» (domestic cat) — 63%, «бумажный пакет» (paper bag) — 50%, «сумка» (bag) — 50%. Потом идут ещё два класса: «угольно-чёрный цвет» (coal black color) — 89% и «серый цвет» (gray color) — 80%. Для второго изображения модель полагает, что это, скорее всего, «животное» (animal) — 97%, «домашнее животное» (domestic animal), «собака» (dog) — 92%, «сторожевая собака» (watchdog), «собака породы кувас» (kuvasz dog) — 83%. С меньшей степенью уверенности модель предполагает, что это «белый медведь» (ice bear) — 64% или «медведь» (bear) — 68% и т. д.

Задачи [восстановления] регрессии. Данные задачи в целом похожи на задачи классификации, но в них мы имеем дело не с множеством классов, к которым хотим отнести экзаменуемый объект, а с некоторой непрерывной величиной, которую желаем оценить на основании входных факторов. Простой пример — модель, пытающаяся определить возраст человека по фотографии. Любую задачу классификации можно свести к задаче регрессии, если взять в качестве прогнозируемой величины вероятность принадлежности объекта к каждому из классов.

Понятие регрессии ввёл в 1886 г. антрополог Фрэнсис Гальтон, изучавший статистические закономерности наследственности. В рамках разработанного им антропометрического подхода учёный измерял у своих соотечественников множество параметров: размеры головы, рост, возвышение над стулом при сидении, размах рук, объём вдыхаемого воздуха, массу тела, время реакции на зрительные и звуковые раздражители — и даже оценивал степень привлекательности девушек. На Международной выставке здоровья, открывшейся в 1884 г. в Лондоне, в антропометрической лаборатории Гальтона было проведено 150 000 отдельных измерений для 10 000 человек. Данные, собранные учёным, среди прочего содержали сведения о 928 потомках 205 матерей и отцов. Изобразив данные на графике, Гальтон обнаружил вполне ожидаемую положительную ассоциацию между ростом родителей и их детей, однако заметил, что дети наиболее высоких родителей имели тенденцию уступать своим родителям в росте, в то время как для наиболее низких родителей наблюдалась обратная зависимость: их дети обычно превосходили родителей ростом. Полученные данные повторяли результаты серии экспериментов 1876 г., в которых Гальтон изучал диаметр горошин; наиболее крупные горошины давали обычно более мелких, чем они сами, потомков, а наиболее мелкие — более крупных[46]. Гальтон назвал этот феномен «регрессией к среднему» и ввёл понятие «степень регрессии» (сегодня обычно её называют коэффициентом регрессии)[47]. Позже термин, возникший в частной прикладной задаче, закрепился за широким классом методов восстановления зависимостей[48].

Рис. 5. Примеры решения задачи регрессии для изображений (определение возраста)

Рис. 6. Показатель регрессии в наследовании роста

Задачи преобразования последовательностей, или, как их принято называть, seq2seq-задачи (от sequence to sequence — «последовательность в последовательность»)[49]. Модель получает на вход некоторую последовательность и должна выдать также некоторую последовательность, соответствующую входной. Простой пример — задача перевода текста с одного языка на другой. В данном случае входная последовательность — это текст, написанный на одном языке, выходная — перевод входного текста на другой язык. Другой пример — задача распознавания речи, при которой на вход модели подаётся последовательность звуковых амплитуд, а на выходе получается текстовая расшифровка речи. Задачи регрессии и классификации тоже можно представить в виде задачи преобразования последовательности в последовательность. В этом случае входная последовательность будет содержать значения входных факторов (или весь набор значений факторов в виде единственного элемента-вектора), а выходная будет состоять из одного элемента — метки класса или значения регрессии. Этот пример показывает некоторую условность выделения категорий задач машинного обучения. Когда мы относим ту или иную задачу к категории seq2seq, то обычно хотим тем самым подчеркнуть, что входные и выходные данные модели могут иметь переменную размерность. Если же, например, на входе нашей модели последовательность переменной длины, а на выходе — метка класса, то такая задача будет скорее отнесена к задачам классификации последовательностей (sequence classification)[50]. Примером такой задачи может быть выявление языка, на котором написан некоторый текст переменной длины. Аналогичным образом говорят о регрессии последовательностей (sequence regression)[51], в случаях когда на входе модели — последовательность, а на выходе — некоторая величина, например на входе — текст комментария в Facebook, а на выходе — предполагаемый возраст его автора.

Также важными разновидностями задач машинного обучения являются задачи сокращения размерности (dimensionality reduction)[52] и задачи генерации (порождения) данных[53]. Представим себе свидетеля преступления, который описывает внешность преступника словами: сообщает цвет глаз, рассказывает о причёске, форме носа и глаз, наличии или отсутствии усов, бороды, воспроизводит другие особенности внешности, называет пол преступника, его ориентировочные рост и возраст. Такой набор свойств обычно называют признаками или фичами (от англ. features) объекта. Весь этот набор значений признаков куда более компактен, чем фото преступника, составленное из миллионов пикселей[54]. В данном случае мозг свидетеля выполняет роль модели, решающей задачу сокращения размерности входных данных. Художник же, который рисует портрет преступника по словесному описанию внешности, в данном случае выполняет роль генеративной модели, то есть такой модели, которая порождает в ходе своей работы новые данные (в нашем случае путём домысливания всех мельчайших деталей портрета). Модели машинного обучения, сочиняющие музыку, пишущие тексты или создающие изображения по заданию, также являются генеративными моделями.

Пары моделей, использующих одно и то же компактное представление данных, одна из которых преобразует данные в их компактное представление, а вторая — пытается по этому компактному представлению восстановить исходные данные, называют соответственно кодировщиком (encoder) и декодером (decoder).

Области применения машинного обучения

В наши дни методы машинного обучения применяются в самых разных областях человеческой деятельности. В таблице ниже представлены лишь некоторые из них[55].

Рис. 7. Области применения методов машинного обучения