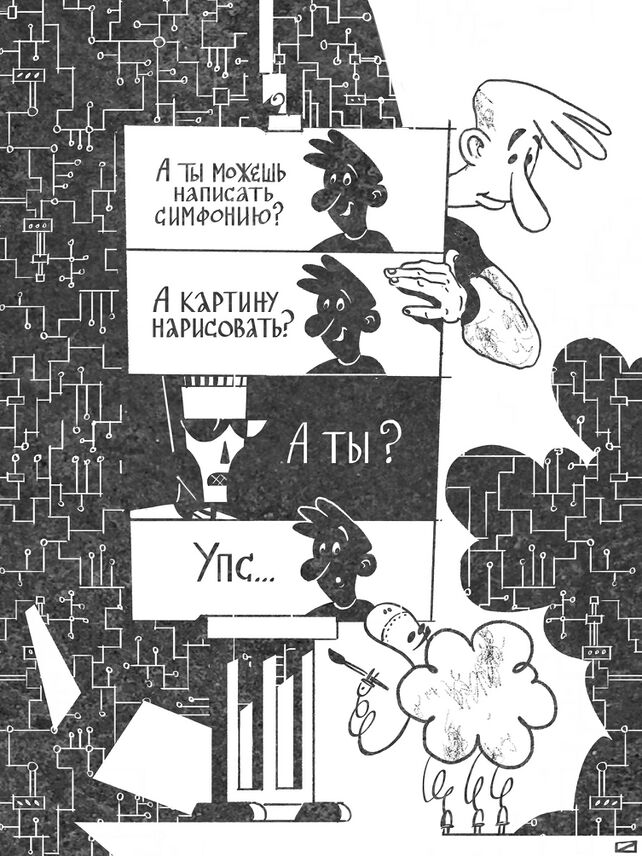

1.1 Понятие ИИ. Прикладной/слабый ИИ, сильный ИИ (AGI)

В силу того, что искусственный интеллект — понятие чрезвычайно широкое, возникли термины для конкретизации того, с каким именно явлением мы имеем дело. Сегодня традиционным стало разделение систем ИИ на два вида. Первый из них — «слабый» [weak], «специализированный» [narrow] или «прикладной» [applied], то есть предназначенный для решения какой-то одной, отдельной интеллектуальной задачи или их небольшого множества. Второй вид — «сильный» [strong] или «универсальный» [general] ИИ, к нему относят гипотетические системы, способные, подобно человеческому интеллекту, решать неопределённо широкий спектр интеллектуальных задач.

Интересно, что изначально термин «сильный искусственный интеллект» (strong AI) означал не совсем то, что часто означает сегодня. Его автор, философ Джон Сёрль, ввёл его для того, чтобы отличать систему, которая «ведёт себя так, как будто является разумной» [can (only) act like it thinks and has a mind], от системы, которая «на самом деле» обладает разумом [can think and have a mind][1]. В современных работах понятия «сильный ИИ» и «гипотеза сильного ИИ» иногда используют в оригинальном, сёрлевском смысле, но ряд исследователей, к которым относится, например, уже упоминавшийся Реймонд Курцвейл, считают, что термин «сильный ИИ» описывает любую систему ИИ, которая действует так, как будто обладает разумом, вне зависимости от того, способны ли философы определить, «в самом ли деле» она им обладает[2].

Для того чтобы не допускать путаницы и разночтений, многие исследователи предпочитают использовать термин artificial general intelligence (общий/универсальный искусственный интеллект), обычно его употребляют в виде аббревиатуры — AGI.

Занятно, что впервые термин появился в работе Марка Губруда «Нанотехнологии и международная безопасность», посвящённой военным применениям технологий будущего. Автор даёт AGI следующее определение: «Под продвинутым универсальным ИИ я понимаю системы ИИ, способные соперничать с человеческим мозгом или превосходить его в сложности и скорости, которые способны получать общие сведения, манипулировать ими и выстраивать рассуждения и которые могут использоваться, по сути, в любой фазе индустриальных или военных операций, в которой был бы необходим человеческий интеллект. Эти системы могут быть основаны на моделировании человеческого мозга, но это не является необходимым требованием, они не должны также обязательно обладать „сознанием“ или любой другой компетенцией, не имеющей прямого отношения к их применению. Что важно, так это то, что эти системы могут быть использованы для замены человеческих мозгов в задачах, начиная от организации и запуска шахты или фабрики и заканчивая пилотированием самолёта, анализом разведданных или планированием боевых действий»[3]. Сейчас AGI определяют обычно несколько проще: «AGI — искусственный интеллект, способный успешно выполнить любую интеллектуальную задачу, посильную для человека»[4].

Среди задач, решаемых при помощи методов машинного обучения, выделяют несколько крупных категорий.

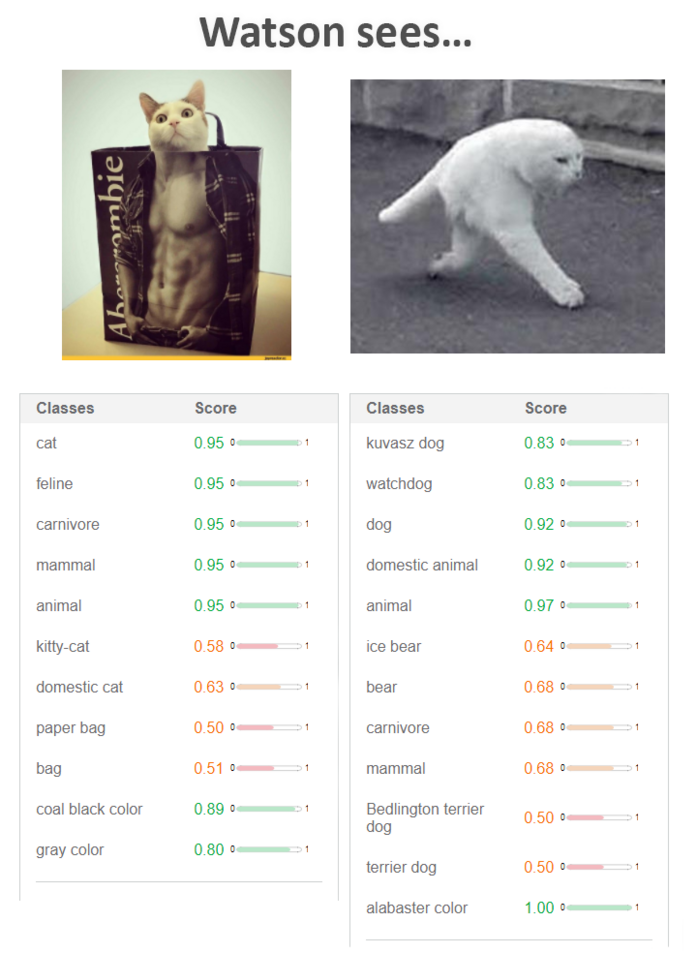

- Задачи классификации. Цель модели в них — отнесение объекта на основании его известных свойств к некоторым группам (классам). Иногда классы называют образами, в таком случае говорят о задачах распознавания образов[5]. Именно к этому типу относится задача различения кошек и собак на фото. В данном случае «кошка» и «собака» — это два разных класса, а известные свойства, или факторы, модели — это цвет каждой из точек на фотографии. Например, если мы имеем дело с чёрно-белыми фотографиями разрешением 1024 ? 1024 точки, то всего у нас будет 1 048 576 входных факторов модели (цвет каждой точки будет представлен числом, характеризующим степень её яркости). При решении задачи классификации модель (в данном случае её называют классификатором), обучившись на некотором наборе объектов, должна будет уметь отнести к тому или иному классу в том числе и новые объекты, которых в обучающей выборке не было. Потому что классификаторы, просто запоминающие всё, что им предъявили, и неспособные сделать вывод в отношении чего-то отсутствующего в обучающей выборке, нам обычно не очень интересны.

Рис. 4. Примеры решения задачи классификации для изображений. Модель посчитала, что первое изображение со степенью уверенности в 95% принадлежит к следующим классам: «кот» (cat), «животное семейства кошачьих» (feline), «хищник» (carnivore), «млекопитающее» (mammal), «животное» (animal). Далее следуют классы с меньшей степенью уверенности модели: «кошечка» (kitty-cat) — 58%, «домашняя кошка» (domestic cat) — 63%, «бумажный пакет» (paper bag) — 50%, «сумка» (bag) — 50%. Потом идут ещё два класса: «угольно-чёрный цвет» (coal black color) — 89% и «серый цвет» (gray color) — 80%. Для второго изображения модель полагает, что это, скорее всего, «животное» (animal) — 97%, «домашнее животное» (domestic animal), «собака» (dog) — 92%, «сторожевая собака» (watchdog), «собака породы кувас» (kuvasz dog) — 83%. С меньшей степенью уверенности модель предполагает, что это «белый медведь» (ice bear) — 64% или «медведь» (bear) — 68% и т. д.

Задачи [восстановления] регрессии. Данные задачи в целом похожи на задачи классификации, но в них мы имеем дело не с множеством классов, к которым хотим отнести экзаменуемый объект, а с некоторой непрерывной величиной, которую желаем оценить на основании входных факторов. Простой пример — модель, пытающаяся определить возраст человека по фотографии. Любую задачу классификации можно свести к задаче регрессии, если взять в качестве прогнозируемой величины вероятность принадлежности объекта к каждому из классов.

Понятие регрессии ввёл в 1886 г. антрополог Фрэнсис Гальтон, изучавший статистические закономерности наследственности. В рамках разработанного им антропометрического подхода учёный измерял у своих соотечественников множество параметров: размеры головы, рост, возвышение над стулом при сидении, размах рук, объём вдыхаемого воздуха, массу тела, время реакции на зрительные и звуковые раздражители — и даже оценивал степень привлекательности девушек. На Международной выставке здоровья, открывшейся в 1884 г. в Лондоне, в антропометрической лаборатории Гальтона было проведено 150 000 отдельных измерений для 10 000 человек. Данные, собранные учёным, среди прочего содержали сведения о 928 потомках 205 матерей и отцов. Изобразив данные на графике, Гальтон обнаружил вполне ожидаемую положительную ассоциацию между ростом родителей и их детей, однако заметил, что дети наиболее высоких родителей имели тенденцию уступать своим родителям в росте, в то время как для наиболее низких родителей наблюдалась обратная зависимость: их дети обычно превосходили родителей ростом. Полученные данные повторяли результаты серии экспериментов 1876 г., в которых Гальтон изучал диаметр горошин; наиболее крупные горошины давали обычно более мелких, чем они сами, потомков, а наиболее мелкие — более крупных[6]. Гальтон назвал этот феномен «регрессией к среднему» и ввёл понятие «степень регрессии» (сегодня обычно её называют коэффициентом регрессии)[7]. Позже термин, возникший в частной прикладной задаче, закрепился за широким классом методов восстановления зависимостей[8].

Рис. 5. Примеры решения задачи регрессии для изображений (определение возраста)

Рис. 6. Показатель регрессии в наследовании роста

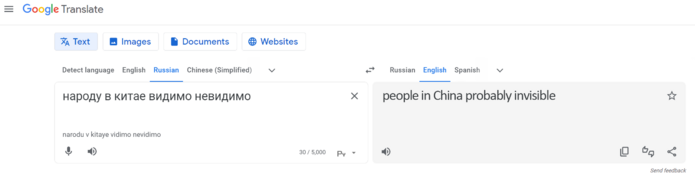

Задачи преобразования последовательностей, или, как их принято называть, seq2seq-задачи (от sequence to sequence — «последовательность в последовательность»)[9]. Модель получает на вход некоторую последовательность и должна выдать также некоторую последовательность, соответствующую входной. Простой пример — задача перевода текста с одного языка на другой. В данном случае входная последовательность — это текст, написанный на одном языке, выходная — перевод входного текста на другой язык. Другой пример — задача распознавания речи, при которой на вход модели подаётся последовательность звуковых амплитуд, а на выходе получается текстовая расшифровка речи. Задачи регрессии и классификации тоже можно представить в виде задачи преобразования последовательности в последовательность. В этом случае входная последовательность будет содержать значения входных факторов (или весь набор значений факторов в виде единственного элемента-вектора), а выходная будет состоять из одного элемента — метки класса или значения регрессии. Этот пример показывает некоторую условность выделения категорий задач машинного обучения. Когда мы относим ту или иную задачу к категории seq2seq, то обычно хотим тем самым подчеркнуть, что входные и выходные данные модели могут иметь переменную размерность. Если же, например, на входе нашей модели последовательность переменной длины, а на выходе — метка класса, то такая задача будет скорее отнесена к задачам классификации последовательностей (sequence classification)[10]. Примером такой задачи может быть выявление языка, на котором написан некоторый текст переменной длины. Аналогичным образом говорят о регрессии последовательностей (sequence regression)[11], в случаях когда на входе модели — последовательность, а на выходе — некоторая величина, например на входе — текст комментария в Facebook, а на выходе — предполагаемый возраст его автора.

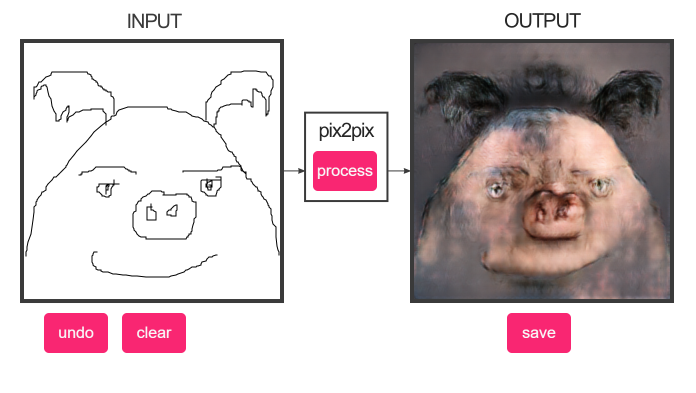

Также важными разновидностями задач машинного обучения являются задачи сокращения размерности (dimensionality reduction)[12] и задачи генерации (порождения) данных[13]. Представим себе свидетеля преступления, который описывает внешность преступника словами: сообщает цвет глаз, рассказывает о причёске, форме носа и глаз, наличии или отсутствии усов, бороды, воспроизводит другие особенности внешности, называет пол преступника, его ориентировочные рост и возраст. Такой набор свойств обычно называют признаками или фичами (от англ. features) объекта. Весь этот набор значений признаков куда более компактен, чем фото преступника, составленное из миллионов пикселей[14]. В данном случае мозг свидетеля выполняет роль модели, решающей задачу сокращения размерности входных данных. Художник же, который рисует портрет преступника по словесному описанию внешности, в данном случае выполняет роль генеративной модели, то есть такой модели, которая порождает в ходе своей работы новые данные (в нашем случае путём домысливания всех мельчайших деталей портрета). Модели машинного обучения, сочиняющие музыку, пишущие тексты или создающие изображения по заданию, также являются генеративными моделями.

Пары моделей, использующих одно и то же компактное представление данных, одна из которых преобразует данные в их компактное представление, а вторая — пытается по этому компактному представлению восстановить исходные данные, называют соответственно кодировщиком (encoder) и декодером (decoder).

- ↑ Searle J. (1980). Minds, Brains and Programs / Behavioral and Brain Sciences, 3 (3): 417–457 // https://doi.org/10.1017/S0140525X00005756

- ↑ Kurzweil R. (2005). The Singularity is near: when humans transcend biology. Viking Press // https://books.google.ru/books?id=9FtnppNpsT4C

- ↑ Gubrud M. A. (1997). Nanotechnology and International Security // https://web.archive.org/web/20190430021737/https://foresight.org/Conferences/MNT05/Papers/Gubrud/

- ↑ Seligman J. (2020). artificial Intelligence / Machine Learning In Marketing. Lulu.com // https://books.google.ru/books?id=l6zRDwAAQBAJ

- ↑ Воронцов К. В. Математические методы обучения по прецедентам (теория обучения машин) // http://www.machinelearning.ru/wiki/images/6/6d/Voron-ML-1.pdf

- ↑ The measurement of man // http://www.galtoninstitute.org.uk/sir-francis-galton/psychology-statistics-criminology/

- ↑ Galton F. (1886). Regression Towards Mediocrity in Hereditary Stature. The Journal of the Anthropological Institute of Great Britain and Ireland, Vol. 15, pp. 246—263 // http://www.jstor.org/stable/2841583

- ↑ Воронцов К. В. Математические методы обучения по прецедентам (теория обучения машин) // http://www.machinelearning.ru/wiki/images/6/6d/Voron-ML-1.pdf

- ↑ Luong M.-T., Brevdo E., Zhao R. (2017). Neural Machine Translation (seq2seq) Tutorial // https://web.archive.org/web/20171123080802/https://www.tensorflow.org/tutorials/seq2seq

- ↑ См., напр.: Xing Z., Pei J., Keogh E. (2010). A Brief Survey on Sequence Classification / SIGKDD Explorations, Vol. 12, pp. 40—48 // https://doi.org/10.1145/1882471.1882478

- ↑ См., напр.: Gsponer S., Smyth B., Ifrim G. (2017). Efficient sequence regression by learning linear models in all-subsequence space / Ceci M., Hollmen J., Todorovski L., Vens C., Dzeroski S. (2017). Machine Learning and Knowledge Discovery in Databases. Springer International Publishing.

- ↑ Roweis S. T., Saul L. K. (2000). Nonlinear Dimensionality Reduction by Locally Linear Embedding / Science, Vol. 290, Iss. 5500, pp. 2323—2326 // https://doi.org/10.1126/science.290.5500.2323

- ↑ Bishop C. M., Lasserre J. (2007). Generative or discriminative? Getting the best of both worlds / Bayesian Statistics, Vol. 8, Iss. 3, p. 24.

- ↑ * Пиксель (от англ. сокращения от pictures element) — наименьший элемент двумерного цифрового изображения.