6.2.1.5 Конец начала и перспективы развития

2017-й стал последним годом в истории ILSVRC. Эстафета по проведению состязаний по распознаванию изображений перешла к Kaggle (платформе для организации соревнований в области машинного обучения)[1]. Но эти семь лет успели изменить буквально всё.

Один из организаторов ILSVRC Алекс Берг охарактеризовал произошедшие изменения следующим образом: «Когда мы начинали проект, такие вещи индустрия ещё не делала. Теперь это продукты, которые используют миллионы людей»[2]. Действительно, менее чем за десять лет системы распознавания изображений из лабораторных прототипов превратились в компоненты множества высокотехнологичных продуктов и сервисов, представленных на рынке.

Хотя ImageNet и не был первым стандартизованным датасетом изображений (к 2009 г. их насчитывалось уже более двух десятков), однако он многократно превзошёл предшественников как по объёму, так и по детальности разметки, которая впервые была выполнена с привязкой к базе данных естественного языка. ILSVRC не были первыми соревнованиями по распознаванию изображений, однако стали самыми популярными среди таковых в истории (в 2010 г. в ILSVRC приняло участие 35 команд, в 2016 г. — 172 команды)[3]. ILSVRC также не были первыми соревнованиями по распознаванию изображений, в которых победу одержала нейросетевая модель, однако именно победа нейросетевой модели на ILSVRC стала громким медийным поводом, привлекшим внимание общественности к успехам в этой области. И наконец, ILSVRC не были первыми соревнованиями, в которых машины превзошли человека в задаче распознавания образов, хотя именно этот результат теперь принято использовать в качестве одного из доказательств революционного прорыва, совершённого в отрасли машинного обучения в последние годы.

Наследниками ImageNet стали многочисленные специализированные датасеты, такие как Medical ImageNet (база данных медицинских изображений)[4], SpaceNet (база данных фотоснимков объектов, выполненных из космоса)[5], ActivityNet (база данных видеозаписей различной человеческой активности)[6], EventNet (база данных с семантически размеченными видео)[7] и так далее.

На последнем слайде выступления организаторов ILSVRC в 2017 г. размещена цитата Уинстона Черчилля: «Это не конец. Это даже не начало конца. Но, возможно, это конец начала»[8].

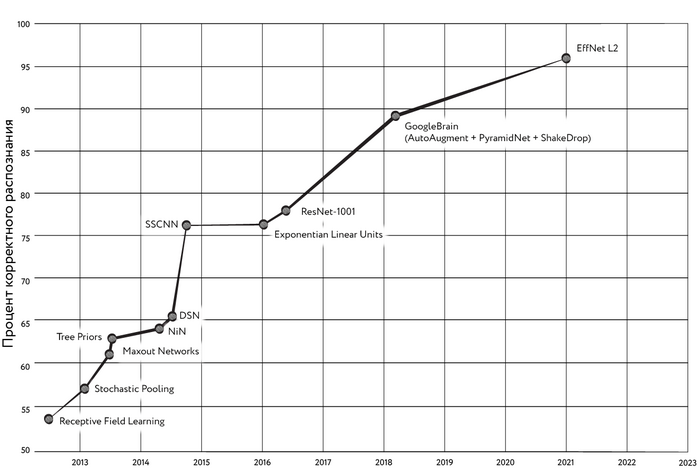

Действительно, прогресс в точности распознавания образов не стоит на месте, а оценить его можно по результатам, приводимым в научных публикациях. Например, точность распознавания образов на массиве CIFAR-100 в 2019 г. выросла до 91,7% (модель EfficientNet)[9] по сравнению с 89,3% (более ранняя модель от GoogleBrain на основе пирамидальных сетей (Feature Pyramid Networks, FPN) — специальной разновидности свёрточных сетей, в которой признаки, относящиеся к разным слоям свёртки, организованы в специальную пирамидальную иерархию, позволяющую более эффективно распознавать объекты разного масштаба[10])[11], [12] в 2018 г. В 2020 г. при помощи модели EfficientNet-L2 на CIFAR-100 удалось получить точность 96,1% (этот показатель по состоянию на сентябрь 2023 г. продолжает оставаться лучшим). Этот результат был достигнут благодаря технологии, получившей название «Минимизация с учётом резкости» (Sharpness-Aware Minimization). Идея этого подхода заключается в том, чтобы предпочитать такие параметры модели, в окрестностях которых функция потерь будет иметь значения, мало отличающиеся от минимума. Такая стратегия оптимизации позволяет достичь более хорошего обобщения в процессе обучения[13].

Рис. 121. Увеличение точности распознавания изображений на массиве CIFAR-100

Модели, побеждавшие на ILSVRC, стали основой систем, широко применяющихся для решения самых разных прикладных задач: жестового управления устройствами, распознавания лиц и дорожных объектов в автомобильных автопилотах, опухолей на медицинских снимках, текста, мимики, почерка, состава блюд и так далее — в наши дни под самые разные задачи распознавания опубликовано огромное количество публичных датасетов. Одна только моя команда за 2022-й и начало 2023 года разместила в открытом доступе два таких набора данных: HaGRID[14], предназначенный для распознавания 18 управляющих жестов для умных устройств, и Slovo[15] — для распознавания слов русского жестового языка.

Несколько модифицировав архитектуру нейронной сети, можно решать и более сложные задачи, чем просто классификация изображений. Мы уже упоминали некоторые из них при перечислении номинаций в рамках ILSVRC. Например, задача локализации объектов предполагает поиск минимальных по размеру прямоугольников, внутри которых находится интересующий нас объект. Сегодня нейронные сети успешно решают и более сложные варианты задачи распознавания образов, например задачу так называемой сегментации [segmentation], когда сеть должна найти точные контуры интересующих нас объектов. С этой задачей успешно справляются такие архитектуры, как, например, U-Net, разработанная на факультете информатики Фрайбургского университета (Albert-Ludwigs-Universität Freiburg) для задач сегментации медицинских изображений ещё в 2015 г.[16] С помощью такой сети можно успешно выявлять аномалии на рентгеновских снимках, находить определённые типы клеток на микрофотографиях тканей живых организмов… А можно, скажем, и удалять нежелательных персонажей с красивых коллективных фото.

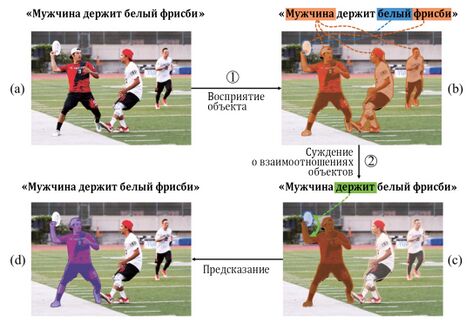

Рис. 122. Пример решения задачи сегментации

Более сложный вариант этой задачи — семантическая сегментация [semantic segmentation], она предполагает выявление на изображениях контуров объектов с заданным названием. Модели, предназначенные для её решения, обычно являются гибридами моделей для решения задач обработки естественного языка и моделей для обработки изображений (обычно свёрточных сетей). К их числу относятся, например, сети, построенные из модулей CMPC (Cross-Modal Progressive Comprehension, Кросс-модальное прогрессивное понимание) и TGFE (Text-Guided Feature Exchange, Управляемое текстом извлечение признаков)[17].

Рис. 123. Пример решения задачи семантической сегментации

Революция в компьютерном зрении существенно трансформирует многие отрасли общественной жизни, но было бы ошибкой думать, что она уже свершилась или близка к завершению. По всей видимости, длиться, захватывая и коренным образом меняя всё новые и новые стороны труда и быта, она будет ещё довольно долго, потому что создание и внедрение на базе экспериментальных систем действительно массовых продуктов и сервисов зачастую требует немалого времени и серьёзных ресурсов. Причём когда речь идёт об ИИ-технологиях, одни из важнейших необходимых ресурсов — это квалифицированные специалисты и качественно размеченные данные в необходимых объёмах. И именно они зачастую — в дефиците.

- ↑ Fei-Fei L., Deng J. (2017). ImageNet: Where have we been? Where are we going? // http://image-net.org/challenges/talks_2017/imagenet_ilsvrc2017_v1.0.pdf

- ↑ Reynolds M. (2017). New computer vision challenge wants to teach robots to see in 3D / New Scientist, Iss. 3121 // https://www.newscientist.com/article/2127131-new-computer-vision-challenge-wants-to-teach-robots-to-see-in-3d/

- ↑ Fei-Fei L., Deng J. (2017). ImageNet: Where have we been? Where are we going? // http://image-net.org/challenges/talks_2017/imagenet_ilsvrc2017_v1.0.pdf

- ↑ Medical Image Net: A petabyte-scale, cloud-based, multi-institutional, searchable, open repository of diagnostic imaging studies for developing intelligent image analysis systems // http://langlotzlab.stanford.edu/projects/medical-image-net/

- ↑ SpaceNet // https://spacenet.ai/datasets/

- ↑ Heilbron F. C., Escorcia V., Ghanem B., Niebles J. C. (2015). ActivityNet: A Large-Scale Video Benchmark for Human Activity Understanding / Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp. 961—970 // http://activity-net.org/

- ↑ Chang S. F., Liu D., Ye G., Li Y., Xu H., Liu H., Wang D., Lin T., Chen Q., Shou Z. A Large Scale Structured Concept Library // http://eventnet.cs.columbia.edu/index.html

- ↑ Fei-Fei L., Deng J. (2017). ImageNet: Where have we been? Where are we going? // http://image-net.org/challenges/talks_2017/imagenet_ilsvrc2017_v1.0.pdf

- ↑ Tan M., Le Q. V. (2019). EfficientNet: Improving Accuracy and Efficiency through AutoML and Model Scaling / Google AI Blog // https://ai.googleblog.com/2019/05/efficientnet-improving-accuracy-and.html

- ↑ Lin T.-Y., Dollár P., Girshick R., He K., Hariharan B., Belongie S. (2016). Feature Pyramid Networks for Object Detection // https://arxiv.org/abs/1612.03144

- ↑ Cubuk E. D., Zoph B., Mane D., Vasudevan V., Le Q. V. (2018). AutoAugment: Learning Augmentation Policies from Data // https://arxiv.org/abs/1805.09501

- ↑ Cubuk E. D., Zoph B. (2018). Improving Deep Learning Performance with AutoAugment / Google AI Blog // https://ai.googleblog.com/2018/06/improving-deep-learning-performance.html

- ↑ Foret P., Kleiner A., Mobahi H., Neyshabur B. (2020). Sharpness-Aware Minimization for Efficiently Improving Generalization // https://arxiv.org/abs/2010.01412

- ↑ Kapitanov A., Makhlyarchuk A., Kvanchiani K. (2022). HaGRID - HAnd Gesture Recognition Image Dataset // https://arxiv.org/abs/2206.08219

- ↑ Kapitanov A., Kvanchiani K., Nagaev A., Petrova E. (2023). Slovo: Russian Sign Language Dataset // https://arxiv.org/abs/2305.14527

- ↑ Ronneberger O., Fischer P., Brox T. (2015). U-Net: Convolutional Networks for Biomedical Image Segmentation // https://arxiv.org/abs/1505.04597

- ↑ Huang S., Hui T., Liu S., Li G., Wei Y., Han J., Liu L., Li B. (2020). Referring Image Segmentation via Cross-Modal Progressive Comprehension // https://arxiv.org/abs/2010.00514