6.3.3.6 Тесты на понимание естественного языка

Прогресс в решении задач, связанных с пониманием естественного языка, нуждался в появлении стандартизированных тестов для численной оценки этого прогресса. Конечно, для этого можно было бы использовать процедуру, подобную тесту Тьюринга, но на практике такие способы оценки не всегда удобны. Они требуют привлечения людей, значительного времени, а также существенных усилий для обеспечения единообразных условий и статистической значимости тестов. Для того чтобы сделать процедуру оценки быстрой, недорогой и максимально стандартизованной, необходимо устранить из неё проблемный элемент, а именно — человека. Примерно этими же соображениями руководствовались создатели тестов SAT или ЕГЭ, и применение последних показывает, что, решая некоторые проблемы, они создают ряд новых: например возможность утечки условий теста или невозможность использования творческих заданий со свободными развёрнутыми (открытыми) ответами. Разработчики систем ИИ, разумеется, видят недостатки подобных методов, но им важно иметь в распоряжении инструменты для быстрой оценки возможностей новых моделей.

В конце 2018 г. на роль такого инструмента был предложен набор тестов под названием GLUE (General Language Understanding Evaluation, Оценка общего понимания языка)[1], на смену которому год спустя пришёл его усложнённый вариант — SuperGLUE[2].

Фактически SuperGLUE объединяет восемь наборов тестов, каждый из которых включает множество однотипных задач.

1. BoolQ (Boolean Questions, Булевские вопросы)[3] — каждая задача в этом наборе состоит из короткого фрагмента текста (позаимствованного из «Википедии») и вопроса, подразумевающего один из двух ответов: «да» или «нет». При этом текст содержит информацию, необходимую для того, чтобы дать ответ на поставленный вопрос.

2. CB (CommitmentBank, Банк убеждений)[4] — это корпус коротких текстов, в каждом из которых есть хотя бы одно сложноподчинённое предложение. Сами тексты взяты из трёх источников: The Wall Street Journal, корпуса художественной литературы British National Corpus и датасета Switchboard. Для каждого текста из придаточной части сложноподчинённого предложения вручную были сформулированы утверждения (обычно в прошедшем времени и без отрицания, например: «…Тесс добежит до финиша» перешло в «Тесс добежала до финиша», а «…Оливия не смогла пройти тест» — в «Оливия прошла тест»), при этом составителям пришлось отбросить множество случаев, когда было трудно построить краткий и точный вариант. После этого разметчики указывали, является ли полученное утверждение истинным, ложным или неопределённым (исходя из исходного текста и логики автора). В состав CommitmentBank были включены только те примеры, для которых с ответом было согласно не менее 80% людей-разметчиков. Таким образом, итоговая задача была оформлена как набор пар (текст и утверждение), для каждой из которых необходимо выбрать один из трёх возможных вариантов: 1) утверждение следует из текста; 2) из текста следует утверждение, противоположное данному; 3) утверждение не следует из текста.

3. COPA (Choice of Plausible Alternatives, Выбор правдоподобных альтернатив)[5] — задачи на установление причинно-следственных связей. При их решении необходимо выбрать одно из двух возможных следствий из некоторого утверждения.

4. MultiRC (Multi-Sentence Reading Computing, Вычисления на основе чтения множества предложений)[6] — каждая задача этого набора включает в себя небольшой текст, вопрос к нему и набор ответов на этот вопрос. Необходимо определить, какие из этих ответов верны, а какие нет (т. е. каждый вопрос может иметь несколько возможных правильных ответов).

5. ReCoRD (Reading Computing with Commonsense Reasoning Dataset, Вычисления на основе чтения с использованием датасета здравого смысла)[7] — в этом наборе каждая задача состоит из новостной статьи и вопроса к ней, в тексте которого одно из существительных заменено пропуском. Также приводится список существительных, в отношении каждого из которых необходимо определить, можно ли подставить это слово вместо пропуска. Статьи для теста позаимствованы из CNN и Daily Mail.

6. RTE (Recognizing Textual Entailment, Распознавание текстуальных импликаций)[8], [9], [10], [11] — этот набор заданий объединяет тесты, используемые на ежегодных соревнованиях по текстуальной импликации ([linguistic] entailment — это построение некоторого вывода на основе имеющихся в тексте посылок, в отечественной лингвистике этот процесс традиционно называют «текстуальной импликацией», отталкиваясь от термина «импликация», означающего логическую операцию следования). Каждое задание состоит из двух утверждений, для которых нужно определить, следует второе утверждение из истинности первого или нет.

7. WiC (Word-in-Context, Слово-в-контексте) — задачи устранения неоднозначности смысла слова. В каждом задании приведены два предложения, в каждом из которых встречается некоторое слово. Необходимо определить, используется ли слово в одном и том же смысле в обоих предложениях. Сами предложения взяты из датасетов WordNet и VerbNet, а также словаря Wiktionary.

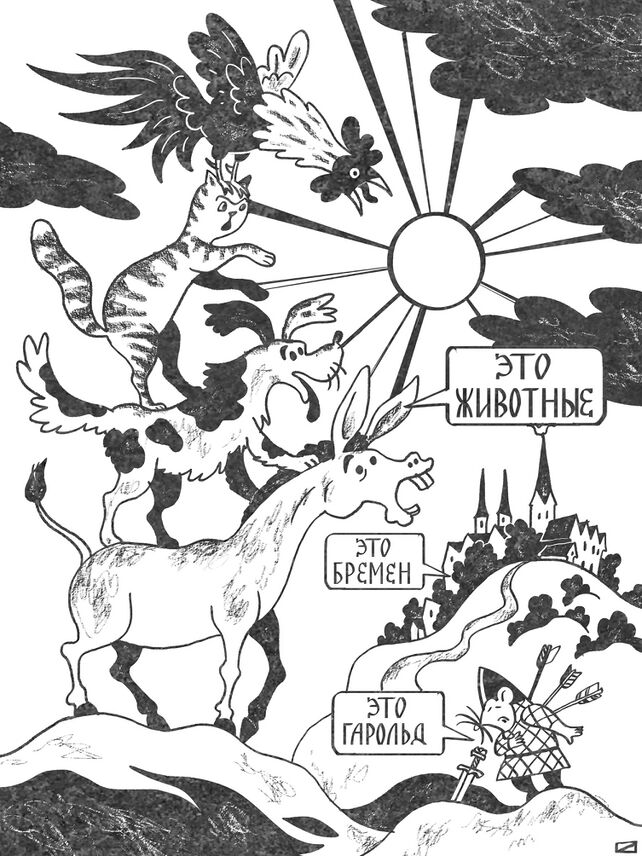

8. WSC (Winograd Schema Challenge, Соревнования по схеме Винограда) — задачи разрешения кореферентности. Кореферентностью, или референциональным тождеством, в лингвистике называют отношение между именами в высказываниях, когда имена ссылаются на один и тот же объект, ситуацию или группу объектов или ситуаций (так называемый референт). Например, в тексте «Это Гарольд. Он скрывает боль» местоимение «он» ссылается на некого Гарольда (являющегося в данном случае референтом), а в тексте «Осёл, собака, кот и петух отправились в город Бремен. По дороге животные нашли себе новый дом» существительное «животные» ссылается на референт, представляющий собой группу, состоящую из осла, собаки, кота и петуха. В WSC используется частный случай кореферентности, называемый анафорой[12]. В случае анафоры слово-отсылка (обычно местоимение), называемое анафором, расположено в тексте после имени, на которое оно ссылается (это имя называется антецедентом). Если порядок следования имени и отсылки противоположный, то такой вид кореферентности называется катафорой. Таким образом, в тексте про Гарольда, скрывающего боль, мы наблюдаем именно анафору, при этом слово «он» является анафором, а слово «Гарольд» — антецедентом.

В WSC каждая задача, называемая «схемой Винограда», заключается в том, чтобы сопоставить местоимение-анафор с одним из имён-существительных, встречающихся в тексте. Для того чтобы произвести такое сопоставление, нужно обладать изрядной толикой здравого смысла и знаний об окружающем мире. Создатель WSC — канадский исследователь в области ИИ Гектор Левеск — назвал свой текст в честь другого известного специалиста в области ИИ — уже знакомого нам Терри Винограда.

Также SuperGLUE содержит два диагностических набора задач. Первый из них аналогичен RTE и предназначен для анализа знаний моделей о языке и окружающем мире. Второй предназначен для анализа гендерных предубеждений, присущих моделям, и основан на датасете WinoGender (от Winograd schemas [схемы Винограда] и gender [гендер]). О каких проблемах идёт речь? Возможно, вы знаете классическую загадку: «Мужчина и его сын попадают в страшную автокатастрофу. Отец погибает, а мальчик тяжело ранен. В больнице хирург смотрит на пациента и восклицает: „Я не могу оперировать этого мальчика, он мой сын!“ Как это может быть?»

Большинство людей испытывает трудности с поиском правильного ответа на этот вопрос и начинает строить гипотезы, связанные с подменой детей в роддоме и тому подобное, хотя в действительности ответ прост: хирург — это мать мальчика. Такого рода затруднения свойственны не только людям, но и моделям, обученным на гендерно несбалансированных датасетах. В результате эти модели оказываются неспособны правильно разрешать кореферентности в некоторых ситуациях. Например, разработанная в Стэнфорде библиотека CoreNLP, использующая для разрешения кореферентности модель, основанную на правилах, оказалась не в состоянии найти кореферентность между словами her [её] и surgeon [хирург] во фразе: The surgeon couldn’t operate on her patient: it was her son [Хирургу нельзя было оперировать пациента: это был её сын][13].

5 января 2021 г. произошло знаковое событие: впервые в истории SuperGLUE моделям машинного обучения удалось потеснить человека[14], [15]. Этого добился ансамбль моделей T5 и Meena, разработанный специалистами Google Brain, который смог набрать в тестах 90,2 балла, что на 0,4 балла выше уровня, демонстрируемого на том же наборе тестов людьми. Но этому рекорду суждено было просуществовать всего один день, потому что уже 6 января на первое место в топ-листе взошла модель DeBERTa (Decoding-enhanced BERT with disentangled attention, BERT с улучшенным декодированием и распутанным вниманием)[16], разработанная специалистами из Microsoft. В результате рекордный показатель вырос ещё на 0,1 балла. В июле 2021 г. команде исследователей из компании Baidu с моделью ERNIE 3.0 удалось улучшить этот результат до 90,6 балла[17]. 2 декабря 2021 г. этот результат был улучшен до 90,9 балла командой исследователей из Microsoft с их моделью Turing NLR v5, однако этот рекорд просуществовал всего пять дней — уже 7 декабря исследователь Уильям Федус из Google смог улучшить его на 0,1 балла за счёт использования нейросетевой модели с архитектурой SS-MoE[18].

В 2020 г. командой AGI NLP под руководством Татьяны Шавриной из «Сбера» был подготовлен и опубликован русскоязычный вариант SuperGLUE, получивший название Russian SuperGLUE[19], [20].

Этот датасет также состоит из восьми наборов задач, не считая диагностического набора LiDiRus (Linguistic Diagnostic for Russian, Лингвистическая диагностика для русского языка), который был получен путём адаптации диагностического набора английской версии SuperGLUE.

1. DaNetQA — набор вопросов на здравый смысл и знания об окружающем мире, подразумевающих ответ «да» или «нет» (набор не является прямым аналогом BoolQ и создан авторами Russian SuperGLUE с нуля).

2. RCB (Russian Commitment Bank, Русскоязычный банк убеждений) — классификация наличия причинно-следственных связей между текстом и некоторой гипотезой (также не является переводом англоязычной версии CommitmentBank и создан авторами Russian SuperGLUE на основе подборки новостей и художественной литературы).

3. PARus (Plausible Alternatives for Russian, Правдоподобные альтернативы для русского языка) — задачи на целеполагание, предполагающие выбор из альтернативных вариантов на основе здравого смысла (создан авторами Russian SuperGLUE на основе подборки новостей и художественной литературы из корпуса TAIGA[21]). Напоминает MultiRC с той лишь разницей, что правильный ответ в списке только один.

4. MuSeRC (Multi-Sentence Reading Comprehension, Понимание прочитанного по нескольким предложениям) — задания содержат текст и вопрос к нему, ответ на который можно дать на основе этого текста.

5. RuCoS (Russian reading comprehension with Commonsense, Понимание прочитанного на основе здравого смысла для русского языка) — аналог ReCoRD, составленный на основе подборки статей с новостных сайтов.

6. TERRa (Textual Entailment Recognition for Russian, Распознавание текстуальной импликации для русского языка) — аналог RTE, созданный авторами Russian SuperGLUE на основе подборки новостей и художественной литературы.

7. RUSSE (Russian Semantic Evaluation, Оценка семантики для русского языка) — задачи распознавания смысла слова в контексте. Первая версия этого набора тестов (RUSSE’15)[22] была разработана ещё в 2015 г., в состав же Russian SuperGLUE вошла его более современная версия[23] — RUSSE’18. Его разработкой занималась большая группа исследователей из университетов и частных компаний.

8. RWSD (Russian Winograd Schema Dataset, Русскоязычный датасет схем Винограда) — переводной вариант датасета WSC.

Первое место в таблице лидеров Russian SuperGLUE на сентябрь 2023 г. принадлежит людям (их результат оценивается в 0,811 балла), второе место (0,762 балла) занимает трансформерная модель FRED-T5 (о ней мы расскажем несколько позже), а третье — ансамбль трансформерных моделей под названием Golden Transformer v2.0 (0,755 балла)[24].

Помимо русскоязычного варианта SuperGLUE, в настоящее время созданы французский (FLUE)[25], китайский (CLUE)[26] и польский (KLEJ)[27] аналоги этого теста. Также исследователи разработали датасеты XGLUE (Cross-lingual GLUE, Межъязыковой GLUE)[28] и XTREME (Cross-lingual TRansfer Evaluation of Multilingual Encoders, Межъязыковая оценка переноса для многоязычных кодировщиков)[29], ориентированные на многоязычные модели.

Сверхчеловеческий уровень понимания естественного языка, демонстрируемый моделями машинного обучения в тестах, подобных SuperGLUE, пока что вызывает некоторые вопросы. Например, Татьяна Шаврина и Валентин Малых обращают внимание на то, что метрики, положенные в основу SuperGLUE, несовершенны — арифметическое усреднение результатов, полученных моделями в разных типах тестов, приводит к заметной переоценке возможностей моделей, и в действительности люди всё же пока что понимают естественный язык лучше машин[30]. Поэтому не исключено, что в ближайшее время наборы тестов будут подвергнуты очередному пересмотру — за счёт добавления новых, более сложных заданий, а также за счёт улучшения самих способов оценки результатов.

Впрочем, некоторые виды задач на понимание естественного языка пока что являются довольно сложными даже для лучших нейросетевых моделей. Например, созданный ещё в 2020 г. набор тестов MMLU (Massive Multitask Language Understanding, Массовое мультизадачное понимание языка), охватывающий 57 типов заданий (задачи из области арифметики, информатики, юриспруденции, истории США и т. д.), всё ещё остаётся крепким орешком. Лучший результат здесь демонстрирует GPT-4 с 86,4% правильных ответов — что пока не дотягивает до уровня людей-экспертов с результатом в 89,8%[31], [32]. Впрочем, последние исследования показывают, что при помощи некоторых алгоритмических трюков можно получить практически «бесплатную» прибавку в несколько процентных пунктов к результатам лучших моделей, а также что в самом наборе тестов есть некоторое количество дефектов и ошибок[33].

В середине 2022 г. благодаря невиданной доселе коллаборации учёных (442 автора из 132 научных коллективов) свет увидел самый большой набор тестов для исследования возможностей генеративных языковых моделей. Он описан в статье «За пределами игры в имитацию: количественная оценка и экстраполяция возможностей языковых моделей» [Beyond the Imitation Game: Quantifying and extrapolating the capabilities of language models][34] и включает в себя 204 различных типа задач. Набор получил название BIG-bench не только из-за своего размера. Слово BIG в данном случае является аббревиатурой от Beyond the Imitation Game [За пределами игры в имитацию], что отсылает нас к тесту Тьюринга и намекает на то, что данный набор тестов является результатом развития методологии, предложенной Тьюрингом.

Результаты тестирования современных моделей машинного обучения на этом наборе тестов показывают, что, хотя прогресс в последние годы очень значителен, сохраняется множество задач, в которых люди пока что уверенно превосходят даже самые совершенные нейросети. При этом если существующие темпы роста возможностей моделей будут сохраняться до конца 2020-х гг., то этот разрыв, скорее всего, будет ликвидирован.

Авторы ещё одной коллекции тестов для больших языковых моделей — HELM (Holistic Evaluation of Language Models, Комплексная оценка языковых моделей) — делают ставку на развитую систему классификации тестовых заданий (по годам создания, языкам, типам решаемых задач и методологиям оценки). Кроме того, они используют для оценки ответов моделей целых семь показателей: точность [accuracy], калибровку [calibration], устойчивость [robustness], справедливость [fairness], предвзятость [bias], токсичность [toxicity] и эффективность [efficiency]. Всё это позволяет авторам агрегатора тестов производить оценку языковых моделей в зависимости от сценариев их предполагаемого использования[35].

Другое направление развития таких тестов — добавление дополнительных модальностей, например зрительной. Одним из хорошо зарекомендовавших себя видов такого рода заданий является ответ на вопросы, заданные к некоторой картинке. Например, к фотографии пиццы можно задать вопросы: «На сколько кусков нарезана эта пицца?» или «Является ли эта пицца вегетарианской?» В научной литературе такой тип заданий обычно именуется «ответом на визуальные вопросы» (Visual Question Answering, VQA)[36]. Если посмотреть на таблицу лидеров для задачи VQA, основанную на популярном датасете COCO (Common Objects in COntext, Обычные объекты в контексте), то в ней всё ещё лидируют люди: трансформерная модель VLMo (Vision-Language pretrained Model, Предобученная модель «зрение — язык»)[37] демонстрирует точность ответов, равную 81,3%, при 83% у людей[38]. Справедливости ради стоит отметить, что за 2021 г. моделям удалось прибавить почти четыре процентных пункта, поэтому и здесь торжество ИИ не за горами.

Впрочем, создатели сложных автоматизированных тестов не отчаиваются: в начале 2022 г. они порадовали научное сообщество новым многоязычным набором сложных заданий, получившим название IGLUE (Image-Grounded Language Understanding Evaluation, Базирующаяся на изображениях оценка понимания языка)[39]. Постепенное усложнение автоматизированных тестов должно помочь исследователям в деле создания новых, ещё более эффективных моделей для решения задач обработки естественного языка.

- ↑ Wang A., Singh A., Michael J., Hill F., Levy O., Bowman S. R. (2018). GLUE: A Multi-Task Benchmark and Analysis Platform for Natural Language Understanding // https://openreview.net/forum?id=rJ4km2R5t7

- ↑ Wang A., Pruksachatkun Y., Nangia N., Singh A., Michael J., Hill F., Levy O., Bowman S. R. (2019). SuperGLUE: A Stickier Benchmark for General-Purpose Language Understanding Systems // https://arxiv.org/abs/1905.00537

- ↑ Clark C., Lee K., Chang M.-W., Kwiatkowski T., Collins M., Toutanova K. (2019). BoolQ: Exploring the Surprising Difficulty of Natural Yes/No Questions // https://arxiv.org/abs/1905.10044

- ↑ de Marneffe M.-C., Simons M., Tonhauser J. (2019). The CommitmentBank: Investigating projection in naturally occurring discourse / Proceedings of Sinn und Bedeutung, Vol. 23 // https://semanticsarchive.net/Archive/Tg3ZGI2M/Marneffe.pdf

- ↑ Roemmele M., Bejan C. A., Gordon A. S. (2011). Choice of Plausible Alternatives: An Evaluation of Commonsense Causal Reasoning / AAAI Spring Symposium on Logical Formalizations of Commonsense Reasoning, Stanford University, March 21—23, 2011 // https://people.ict.usc.edu/~gordon/publications/AAAI-SPRING11A.PDF

- ↑ Khashabi D., Chaturvedi S., Roth M., Upadhyay S., Roth D. (2018). Looking Beyond the Surface: A Challenge Set for Reading Comprehension over Multiple Sentences / Proceedings of North American Chapter of the Association for Computational Linguistics (NAACL) // https://cogcomp.seas.upenn.edu/page/publication_view/833

- ↑ Zhang S., Liu X., Liu J., Gao J., Duh K., Durme B. V. (2018). ReCoRD: Bridging the Gap between Human and Machine Commonsense Reading Comprehension // https://arxiv.org/abs/1810.12885

- ↑ Dagan I., Glickman O., Magnini B. (2006). The PASCAL recognising textual entailment challenge / Machine Learning Challenges. Evaluating Predictive Uncertainty, Visual Object Classification, and Recognising Textual Entailment. Springer, 2006 // link.springer.com/chapter/10.1007/11736790_9

- ↑ Haim R. B., Dagan I., Dolan B., Ferro L., Giampiccolo D., Magnini B., Szpektor I. (2006) / The second PASCAL recognising textual entailment challenge / Proceedings of the Second PASCAL Challenges Workshop on Recognising Textual Entailment, 2006 // http://u.cs.biu.ac.il/~nlp/RTE2/Proceedings/01.pdf

- ↑ Giampiccolo D., Magnini B., Dagan I., Dolan B. (2007). The third PASCAL recognizing textual entailment challenge / Proceedings of the ACL-PASCAL Workshop on Textual Entailment and Paraphrasing. Association for Computational Linguistics, 2007 // https://www.aclweb.org/anthology/W07-1401/

- ↑ Bentivogli L., Dagan I., Dang H. T., Giampiccolo D., Magnini B. (2009). The fifth PASCAL recognizing textual entailment challenge / Textual Analysis Conference (TAC), 2009 // http://citeseerx.ist.psu.edu/viewdoc/summary?doi=10.1.1.232.1231

- ↑ * Анафора (от греч. ἀναφέρειν — относить назад, возвращать, возводить к чему-либо) — зависимость интерпретации выражения от другого (обычно предшествующего) выражения в тексте.

- ↑ Rudinger R., Naradowsky J., Leonard B., Durme B. V. (2018). Gender Bias in Coreference Resolution // https://arxiv.org/abs/1804.09301

- ↑ * Здесь мы сознательно не углубляемся в вопрос, какие именно люди включаются в контрольную группу для оценки способности человека решать те или иные задачи, связанные с пониманием естественного языка (да и вообще любые другие интеллектуальные задачи в ситуациях, когда мы хотим сравнить способности машин и людей). Очевидно, что в идеале состав контрольной группы должен быть достаточно репрезентативным: включать в себя людей с разным уровнем образования, с разными профессиями, принадлежащих к разным социальным группам и культурным общностям. На практике, конечно, формируемые исследователями контрольные группы весьма далеки от идеала. Анализу этой проблемы посвящена весьма поучительная работа исследователей из Гарвардского университета под красноречивым названием «Какие люди?» [Which humans?].

- ↑ Atari M., Xue M. J., Park P. S., Blasi D., Henrich J. (2023). Which humans? // https://doi.org/10.31234/osf.io/5b26t

- ↑ He P., Liu X., Gao J., Chen W. (2021). DeBERTa: Decoding-enhanced BERT with Disentangled Attention // https://paperswithcode.com/paper/deberta-decoding-enhanced-bert-with

- ↑ Sun Y., Wang S., Feng S., Ding S., Pang C., Shang J., Liu J., Chen X., Zhao Y., Lu Y., Liu W., Wu Z., Gong W., Liang J., Shang Z., Sun P., Liu W., Ouyang X., Yu D., Tian H., Wu H., Wang H. (2021). ERNIE 3.0: Large-scale Knowledge Enhanced Pre-training for Language Understanding and Generation // https://arxiv.org/abs/2107.02137

- ↑ SuperGLUE leaderboard, Retreived 2022-01-31 // https://super.gluebenchmark.com/leaderboard/

- ↑ Shavrina T., Fenogenova A., Emelyanov A., Shevelev D., Artemova E., Malykh V., Mikhailov V., Tikhonova M., Chertok A., Evlampiev A. (2020). RussianSuperGLUE: A Russian Language Understanding Evaluation Benchmark // https://arxiv.org/abs/2010.15925

- ↑ Шаврина Т. (2020). Люди ломаются на логике, роботы — на всем понемногу. Экзамены по русскому для NLP-моделей / Хабр, 10 июня // https://habr.com/ru/company/sberbank/blog/506058/

- ↑ Shavrina T., Shapovalova O. (2017). To the methodology of corpus construction for machine learning: «TAIGA» syntax tree corpus and parser / Proceedings of CORPORA2017 international conference, Saint-Petersbourg, 2017 // https://publications.hse.ru/en/chapters/228708483

- ↑ Panchenko A., Loukachevitch N. V., Ustalov D., Paperno D., Meyer C. M., Konstantinova N. (2018). RUSSE: The First Workshop on Russian Semantic Similarity / Proceeding of the International Conference on Computational Linguistics DIALOGUE 2015, pp. 89—105 // https://arxiv.org/abs/1803.05820

- ↑ Panchenko A., Lopukhina A., Ustalov D., Lopukhin K., Arefyev N., Leontyev A., Loukachevitch N. (2018). RUSSE’2018: a Shared Task on Word Sense Induction for the Russian Language / https://arxiv.org/abs/1803.05795

- ↑ RussianSuperGLUE leaderboard, Retreived 2022-01-31 // https://russiansuperglue.com/leaderboard/2

- ↑ Le H., Vial L., Frej J., Segonne V., Coavoux M., Lecouteux B., Allauzen A., Crabbé B., Besacier L., Schwab D. (2019). FlauBERT: Unsupervised Language Model Pre-training for French // https://arxiv.org/abs/1912.05372

- ↑ Xu L., Hu H., Zhang X., Li L., Cao C., Li Y., Xu Y., Sun K., Yu D., Yu C., Tian Y., Dong Q., Liu W., Shi B., Cui Y., Li J., Zeng J., Wang R., Xie W., Li Y., Patterson Y., Tian Z., Zhang Y., Zhou H., Liu S., Zhao Z., Zhao Q., Yue C., Zhang X., Yang Z., Richardson K., Lan Z. (2020). CLUE: A Chinese Language Understanding Evaluation Benchmark // https://arxiv.org/abs/2004.05986

- ↑ Rybak P., Mroczkowski R., Tracz J., Gawlik I. (2020). KLEJ: Comprehensive Benchmark for Polish Language Understanding // https://arxiv.org/abs/2005.00630

- ↑ Liang Y., Duan N., Gong Y., Wu N., Guo F., Qi W., Gong M., Shou L., Jiang D., Cao G., Fan X., Zhang R., Agrawal R., Cui E., Wei S., Bharti T., Qiao Y., Chen J.-H., Wu W., Liu S., Yang F., Campos D., Majumder R., Zhou M. (2020). XGLUE: A New Benchmark Dataset for Cross-lingual Pre-training, Understanding and Generation // https://arxiv.org/abs/2004.01401

- ↑ Hu J., Ruder S., Siddhant A., Neubig G., Firat O., Johnson M. (2020). XTREME: A Massively Multilingual Multi-task Benchmark for Evaluating Cross-lingual Generalization // https://arxiv.org/abs/2003.11080

- ↑ Shavrina T., Malykh V. (2021). How not to Lie with a Benchmark: Rearranging NLP Leaderboards // https://arxiv.org/abs/2112.01342

- ↑ Hendrycks D., Burns C., Basart S., Zou A., Mazeika M., Song D., Steinhardt J. (2020). Measuring Massive Multitask Language Understanding // https://arxiv.org/abs/2009.03300

- ↑ OpenAI (2023). GPT-4 Technical Report // https://arxiv.org/abs/2303.08774

- ↑ AI Explained (2023). SmartGPT: Major Benchmark Broken - 89.0% on MMLU + Exam's Many Errors / YouTube, 28.08.2023 // https://www.youtube.com/watch?v=hVade_8H8mE

- ↑ Srivastava A., Rastogi A., Rao A., Shoeb A. A. M., Abid A., Fisch A., Brown A. R., Santoro A., Gupta A., Garriga-Alonso A., Kluska A., Lewkowycz A., Agarwal A., Power A., Ray A., Warstadt A., Kocurek A. W., Safaya A., Tazarv A., Xiang A., Parrish A., Nie A., Hussain A., Askell A., Dsouza A., Slone A., Rahane A., Iyer A. S., Andreassen A., Madotto A., Santilli A., Stuhlmüller A., Dai A., La A., Lampinen A., Zou A., Jiang A., Chen A., Vuong A., Gupta A., Gottardi A., Norelli A., Venkatesh A., Gholamidavoodi A., Tabassum A., Menezes A., Kirubarajan A., Mullokandov A., Sabharwal A., Herrick A., Efrat A., Erdem A., Karakaş A., Roberts B. R., Loe B. S., Zoph B., Bojanowski B., Özyurt B., Hedayatnia B., Neyshabur B., Inden B., Stein B., Ekmekci B., Lin B. Y., Howald B., Orinion B., Diao C., Dour C., Stinson C., Argueta C., Ramírez C. F., Singh C., Rathkopf C., Meng C., Baral C., Wu C., Callison-Burch C., Waites C., Voigt C., Manning C. D., Potts C., Ramirez C., Rivera C. E., Siro C., Raffel C., Ashcraft C., Garbacea C., Sileo D., Garrette D., Hendrycks D., Kilman D., Roth D., Freeman D., Khashabi D., Levy D., González D. M., Perszyk D., Hernandez D., Chen D., Ippolito D., Gilboa D., Dohan D., Drakard D., Jurgens D., Datta D., Ganguli D., Emelin D., Kleyko D., Yuret D., Chen D., Tam D., Hupkes D., Misra D., Buzan D., Mollo D. C., Yang D., Lee D.-H., Schrader D., Shutova E., Cubuk E. D., Segal E., Hagerman E., Barnes E., Donoway E., Pavlick E., Rodola E., Lam E., Chu E., Tang E., Erdem E., Chang E., Chi E. A., Dyer E., Jerzak E., Kim E., Manyasi E. E., Zheltonozhskii E., Xia F., Siar F., Martínez-Plumed F., Happé F., Chollet F., Rong F., Mishra G., Winata G. I., de Melo G., Kruszewski G., Parascandolo G., Mariani G., Wang G., Jaimovitch-López G., Betz G., Gur-Ari G., Galijasevic H., Kim H., Rashkin H., Hajishirzi H., Mehta H., Bogar H., Shevlin H., Schütze H., Yakura H., Zhang H., Wong H. M., Ng I., Noble I., Jumelet J., Geissinger J., Kernion J., Hilton J., Lee J., Fisac J. F., Simon J. B., Koppel J., Zheng J., Zou J., Kocoń J., Thompson J., Wingfield J., Kaplan J., Radom J., Sohl-Dickstein J., Phang J., Wei J., Yosinski J., Novikova J., Bosscher J., Marsh J., Kim J., Taal J., Engel J., Alabi J., Xu J., Song J., Tang J., Waweru J., Burden J., Miller J., Balis J. U., Batchelder J., Berant J., Frohberg J., Rozen J., Hernandez-Orallo J., Boudeman J., Guerr J., Jones J., Tenenbaum J. B., Rule J. S., Chua J., Kanclerz K., Livescu K., Krauth K., Gopalakrishnan K., Ignatyeva K., Markert K., Dhole K. D., Gimpel K., Omondi K., Mathewson K., Chiafullo K., Shkaruta K., Shridhar K., McDonell K., Richardson K., Reynolds L., Gao L., Zhang L., Dugan L., Qin L., Contreras-Ochando L., Morency L.-P., Moschella L., Lam L., Noble L., Schmidt L., He L., Colón L. O., Metz L., Şenel L. K., Bosma M., Sap M., ter Hoeve M., Farooqi M., Faruqui M., Mazeika M., Baturan M., Marelli M., Maru M., Quintana M. J. R., Tolkiehn M., Giulianelli M., Lewis M., Potthast M., Leavitt M. L., Hagen M., Schubert M., Baitemirova M. O., Arnaud M., McElrath M., Yee M. A., Cohen M., Gu M., Ivanitskiy M., Starritt M., Strube M., Swędrowski M., Bevilacqua M., Yasunaga M., Kale M., Cain M., Xu M., Suzgun M., Walker M., Tiwari M., Bansal M., Aminnaseri M., Geva M., Gheini M., Varma T M., Peng N., Chi N. A., Lee N., Krakover N. G.-A., Cameron N., Roberts N., Doiron N., Martinez N., Nangia N., Deckers N., Muennighoff N., Keskar N. S., Iyer N. S., Constant N., Fiedel N., Wen N., Zhang O., Agha O., Elbaghdadi O., Levy O., Evans O., Casares P. A. M., Doshi P., Fung P., Liang P. P., Vicol P., Alipoormolabashi P., Liao P., Liang P., Chang P., Eckersley P., Htut P. M., Hwang P., Miłkowski P., Patil P., Pezeshkpour P., Oli P., Mei Q., Lyu Q., Chen Q., Banjade R., Rudolph R. E., Gabriel R., Habacker R., Risco R., Millière R., Garg R., Barnes R., Saurous R. A., Arakawa R., Raymaekers R., Frank R., Sikand R., Novak R., Sitelew R., LeBras R., Liu R., Jacobs R., Zhang R., Salakhutdinov R., Chi R., Lee R., Stovall R., Teehan R., Yang R., Singh S., Mohammad S. M., Anand S., Dillavou S., Shleifer S., Wiseman S., Gruetter S., Bowman S. R., Schoenholz S. S., Han S., Kwatra S., Rous S. A., Ghazarian S., Ghosh S., Casey S., Bischoff S., Gehrmann S., Schuster S., Sadeghi S., Hamdan S., Zhou S., Srivastava S., Shi S., Singh S., Asaadi S., Gu S. S., Pachchigar S., Toshniwal S., Upadhyay S., Debnath S., Shakeri S., Thormeyer S., Melzi S., Reddy S., Makini S. P., Lee S.-H., Torene S., Hatwar S., Dehaene S., Divic S., Ermon S., Biderman S., Lin S., Prasad S., Piantadosi S. T., Shieber S. M., Misherghi S., Kiritchenko S., Mishra S., Linzen T., Schuster T., Li T., Yu T., Ali T., Hashimoto T., Wu T.-L., Desbordes T., Rothschild T., Phan T., Wang T., Nkinyili T., Schick T., Kornev T., Tunduny T., Gerstenberg T., Chang T., Neeraj T., Khot T., Shultz T., Shaham U., Misra V., Demberg V., Nyamai V., Raunak V., Ramasesh V., Prabhu V. U., Padmakumar V., Srikumar V., Fedus W., Saunders W., Zhang W., Vossen W., Ren X., Tong X., Zhao X., Wu X., Shen X., Yaghoobzadeh Y., Lakretz Y., Song Y., Bahri Y., Choi Y., Yang Y., Hao Y., Chen Y., Belinkov Y., Hou Y., Hou Y., Bai Y., Seid Z., Zhao Z., Wang Z., Wang Z. J., Wang Z., Wu Z. (2022). Beyond the Imitation Game: Quantifying and extrapolating the capabilities of language models // https://arxiv.org/abs/2206.04615

- ↑ Liang P., Bommasani R., Lee T., Tsipras D., Soylu D., Yasunaga M., Zhang Y., Narayanan D., Wu Y., Kumar A., Newman B., Yuan B., Yan B., Zhang C., Cosgrove C., Manning C. D., Ré C., Acosta-Navas D., Hudson D. A., Zelikman E., Durmus E., Ladhak F., Rong F., Ren H., Yao H., Wang J., Santhanam K., Orr L., Zheng L., Yuksekgonul M., Suzgun M., Kim N., Guha N., Chatterji N., Khattab O., Henderson P., Huang Q., Chi R., Xie S. M., Santurkar S., Ganguli S., Hashimoto T., Icard T., Zhang T., Chaudhary V., Wang W., Li X., Mai Y., Zhang Y., Koreeda Y. (2022). Holistic Evaluation of Language Models // https://arxiv.org/abs/2211.09110

- ↑ Goyal Y., Khot T., Summers-Stay D., Batra D., Parikh D. (2016). Making the V in VQA Matter: Elevating the Role of Image Understanding in Visual Question Answering // https://arxiv.org/abs/1612.00837

- ↑ Wang W., Bao H., Dong L., Wei F. (2021). VLMo: Unified Vision-Language Pre-Training with Mixture-of-Modality-Experts // https://arxiv.org/abs/2111.02358

- ↑ Shrivastava A., Goyal Y., Batra D., Parikh D., Agrawal A. (2021). Welcome to the VQA Challenge 2021! / Visual Question Answering // https://visualqa.org/challenge.html

- ↑ Bugliarello E., Liu F., Pfeiffer J., Reddy S., Elliott D., Ponti E. M., Vulić I. (2021). IGLUE: A Benchmark for Transfer Learning across Modalities, Tasks, and Languages / https://arxiv.org/abs/2201.11732