6.4.3 Синтез речи на ЭВМ и его применение

Электронные вычислительные машины научились воспроизводить звуки ещё на заре своего существования (об этом коротко упоминалось в подглаве, посвящённой шашечной программе Кристофера Стрейчи), и первые эксперименты по компьютерному синтезу речи были начаты уже в 1950-е гг.

Первая программа синтеза на основе правил, способная синтезировать речь из фонематического представления, была, что вполне ожидаемо, создана в недрах Bell Laboratories. Её написали Джон Келли, Кэрол Лохбаум и Лу Герстман в первой половине 1960‑х гг. для компьютера IBM 704. Исследователи использовали синтезатор с тремя формантами. Хотя длительности и форма кривой F0 были скопированы из естественной речи, а также в некоторых случаях использовалась ручная коррекция вывода правил, результаты были весьма впечатляющими. Келли, Герстман и Лохбаум не только порадовали публику несколькими простыми фразами, они заставили IBM 704 зачитать монолог Гамлета («Быть или не быть?») и даже научили свою программу исполнять фрагмент песни Daisy Bell под музыкальный аккомпанемент, который генерировался другой программой.

Свидетелем этой демонстрации стал Артур Кларк, приглашённый в Bell Laboratories своим другом, инженером и фантастом Джоном Пирсом. Кларк был настолько впечатлён увиденным, что использовал машинное исполнение Daisy Bell в одной из наиболее ярких сцен своего романа и сценария фильма «2001 год: Космическая одиссея», увидевшего свет в 1968 г. Именно эту песню поёт компьютер HAL 9000 перед тем, как астронавт Дейв Боуман окончательно отключит его[1], [2], [3], [4].

Первая полноценная компьютерная система для преобразования текста в речь (text-to-speech, TTS) была продемонстрирована в 1968 г. на VI Международном конгрессе по акустике в Токио[5], [6], [7], [8]. Её создательницей была Норико Умеда из Электротехнической лаборатории (Electrotechnical Laboratory, ETL) в Японии. Созданная Умедой и её коллегами система предназначалась для синтеза английской речи и была основана на артикуляционной модели (т. е. на моделировании работы речевого тракта и артикуляционного процесса). Система включала в себя модуль синтаксического анализа текста, основанный на довольно сложных эвристиках. Спустя год Норико Умеда стала сотрудницей Bell Laboratories, где объединила усилия с инженером Сесилом Кокером и лингвистом Кэтрин Браумен для работы над первой TTS-системой Bell Laboratories. Работа системы была продемонстрирована на Международной конференции по речевым коммуникациям и обработке речи (International Conference of Speech Communication and Processing, ICSCP) в 1972 г.[9], [10], [11]

В 1970-е гг. по мере удешевления и миниатюризации вычислительной техники задача компьютерного синтеза речи постепенно переходит из разряда теоретических в прикладную область. Например, появляются первые проекты систем, предназначенных для помощи незрячим и слабовидящим людям. Самый ранний из них был предпринят в начале 1970-х гг. лингвистом Игнациусом Мэттингли из Лабораторий Хаскинса. Помимо набора правил для транскрипции слов в последовательность фонем, Мэттингли использовал фонетический словарь, состоявший из 140 000 слов. Кроме того, Мэттингли стремился оптимизировать темп речи своей системы, чтобы добиться наилучшего восприятия слушателями[12], [13], [14]. К сожалению, этот новаторский проект был остановлен из-за нехватки средств, и устройство, частью которого должна была стать система Мэттингли, так и не пошло в серию. В итоге первое коммерческое устройство для чтения, предназначенное для незрячих пользователей, разработала в 1975 г. компания уже знакомого нам Рэя Курцвейла — Kurzweil Computer Products (позже компания была приобретена корпорацией Xerox). Машина была оснащена оптическим сканером (для распознания напечатанного) и поступила в продажу в конце 1970‑х гг.[15]

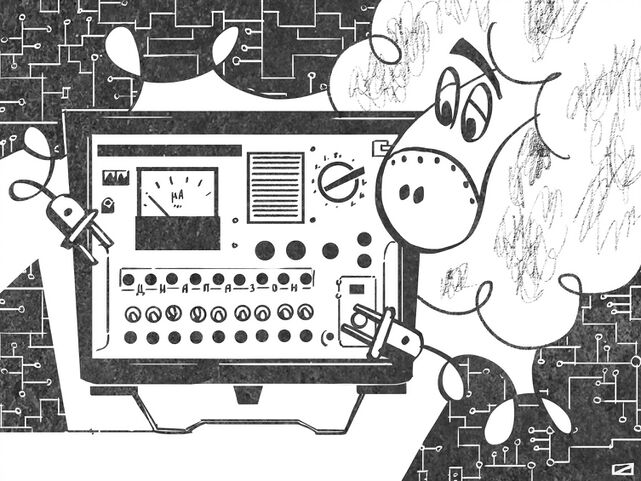

Подобные работы шли и в СССР. Первый русскоязычный синтезатор речи «Фонемофон‑1» был создан в начале 1970-х гг. в Минске под руководством Бориса Лобанова. «Фонемофон-1» был способен не только синтезировать русскую речь, но и читать введённый текст на нескольких иностранных языках, а также синтезировать пение. В основу работы синтезатора был положен формантный метод[16].

Рис. 138. Синтезатор речи «Фонемофон-1»

Первым серийным синтезатором речи в СССР стал цифровой «Фонемофон-4», выпуск которого был начат в середине 1980-х гг. В «Фонемофоне-5» на смену формантному методу синтеза пришёл новый, микроволновой метод синтеза речевых сигналов (при его использовании речь конструируется из элементов, являющихся отдельными периодами звуковых волн, составляющих звуковой сигнал)[17]. Этот синтезатор до сих пор нередко используется незрячими пользователями ЭВМ, поскольку он стал частью русскоязычной версии системы JAWS (Job access with speech, Доступ к работе при помощи речи) — одного из наиболее популярных в мире средств чтения с экрана. JAWS позволяет незрячему или слабовидящему пользователю слышать текст, отображаемый на экране компьютера, либо воспринимать его при помощи дисплея Брайля.

- ↑ Smith III J. O. (2010). Physical Audio Signal Processing. W3K Publishing // https://ccrma.stanford.edu/~jos/pasp/Singing_Kelly_Lochbaum_Vocal_Tract.html

- ↑ O’Dell C. (2009). “Daisy Bell (Bicycle Built for Two)” — Max Mathews, John L. Kelly, Jr., and Carol Lochbaum (1961) // https://www.loc.gov/static/programs/national-recording-preservation-board/documents/DaisyBell.pdf

- ↑ Facetti P. (2014). IBM 704 — Speech Synthesis. Daisy Bell on IBM 7094 / Aneddotica magazine, Sep. 11, 2014 // https://www.aneddoticamagazine.com/ibm-704-speech-synthesis/

- ↑ Mattingly I. G. (1974). Speech synthesis for phonetic and phonological models / Sebeok T. A. (1974). Current trends in linguistics, Vol. 12, Mouton, The Hague, pp. 2451—2487 / Smithsonian Speech Synthesis History Project // https://amhistory.si.edu/archives/speechsynthesis/im_2457.htm

- ↑ Klatt D. H. (1987). Review of text-to-speech conversion for English / Journal of the Acoustical Society of America 82 (3), September 1987 // https://amhistory.si.edu/archives/speechsynthesis/dk_757.htm

- ↑ Umeda N., Teranishi R. (1975). The parsing program for automatic text-to-speech synthesis developed at the electrotechnical laboratory in 1968 / IEEE Transactions on Acoustics, Speech, and Signal Processing, Vol. 23, Iss. 2 // https://doi.org/10.1109/TASSP.1975.1162663

- ↑ Teranishi R., Umeda N. (1968). Use of pronouncing dictionary in speech synthesis experiments (B-5-2) / Reports of the 6th International Congress on Acoustics, Vol. 2, pp. 151—155 // https://www.icacommission.org/Proceedings/ICA1968Tokyo/ICA06%20Proceedings%20Vol2%20OCR.pdf

- ↑ Umeda N., Matsui E., Suzuki T., Omura H. (1968). Synthesis of fairy tales using vocal tract (B-5-3). Reports of the 6th International Congress on Acoustics, Vol. 2, pp. 155—159 // https://www.icacommission.org/Proceedings/ICA1968Tokyo/ICA06%20Proceedings%20Vol2%20OCR.pdf

- ↑ Klatt D. H. (1987). Review of text-to-speech conversion for English / Journal of the Acoustical Society of America 82 (3), September 1987 // https://amhistory.si.edu/archives/speechsynthesis/dk_757.htm

- ↑ Coker C. H., Umeda N., Browman C. P. (1973). Automatic synthesis from ordinary English text / IEEE Transactions on Audio Electroacoustics, Vol. 21, pp. 293—297.

- ↑ Gold B., Morgan N., Ellis D. (2011). Speech and Audio Signal Processing: Processing and Perception of Speech and Music. John Wiley & Sons // https://books.google.ru/books?id=M1TM8-GA_YkC

- ↑ Nye P. W., Cooper F. S. (2007). Haskins Laboratories / Smithsonian Speech Synthesis History Project (SSSHP), 1986—2002 // https://amhistory.si.edu/archives/speechsynthesis/ss_hask.htm

- ↑ Cooper F. S., Gaitenby J. H., Mattingly I. G., Nye P. W., Sholes G. N. (1973). Audible outputs of reading machines for the blind. Status Report on Speech Research SR-35/36, Haskins Laboratories, New Haven, CT // http://www.haskins.yale.edu/SR/SR028/SR028_10.pdf

- ↑ Cooper F. S., Gaitenby J. H., Nye P. W. (1984). Evolution of Reading Machines for the Blind: Haskins Laboratories' Research as a Case History / Journal of Rehabilitation Research & Development, Vol. 21 (1), pp. 51—87 // https://pubmed.ncbi.nlm.nih.gov/6396402/

- ↑ Klatt D. H. (1987). Review of text-to-speech conversion for English / Journal of the Acoustical Society of America 82 (3), September 1987 // https://amhistory.si.edu/archives/speechsynthesis/dk_753.htm

- ↑ Калиев А., Рыбин С. В. (2019). Синтез речи: прошлое и настоящее / Компьютерные инструменты в образовании. № 1. С. 5—28 // https://doi.org/10.32603/2071-2340-2019-1-5-28

- ↑ Лобанов Б. М. (2017). «Мультифон» — система персонализированного синтеза речи по тексту на славянских языках / Лингвистическая полифония. Сборник статей в честь юбилея профессора Р. К. Потаповой // https://books.google.ru/books?id=lmmPCgAAQBAJ