6.6.4 GPT-3 и гонка за триллионом параметров

Появление в мае 2020 г. новой модели семейства GPT под названием GPT-3 вызвало волну обсуждений как среди специалистов, так и в среде широкой общественности. Эта модель совместила в себе блоки обычного, «плотного» [dense] трансформера и блоки разреженного трансформера, при этом размер её рецептивного поля составляет 2048 токенов. Самый большой вариант GPT-3 со 175 млрд весов стал на момент появления самой большой моделью в своём семействе. Специалисты OpenAI описали в своей публикации[1] множество интересных экспериментов с этой моделью. В одном из них люди должны были в двойном слепом тесте отличить короткие (около 200 слов) статьи, сгенерированные моделью, от статей, написанных людьми. Всего было использовано 25 пар статей. Люди (их было 80) справились с задачей в 52% случаев, что при 95%-ном доверительном интервале даёт разброс 49–54%, из чего можно сделать вывод, что выбор людей статистически значимо не отличался от случайного. Ниже пример статьи, написанной GPT-3.

Название: Объединённые методисты договорились об историческом расколе

Подзаголовок: Те, кто выступает против однополых браков, сформируют свою собственную деноминацию

Статья: После двух дней интенсивных дебатов Объединённая методистская церковь согласилась на исторический раскол — тот, который, как ожидается, закончится созданием новой деноминации, которая будет «богословски и социально консервативной», согласно The Washington Post. Большинство делегатов, присутствовавших на ежегодной Генеральной конференции церкви в мае, проголосовали за усиление ограничений на рукоположение духовенства, принадлежащего к LGBTQ, и за разработку новых правил, включающих дисциплинарные меры против священнослужителей, которые исполняют обязанности на однополых свадьбах. Но те, кто выступал против этих мер, имеют свой план: они говорят, что к 2020 г. сформируют отдельную деноминацию, назвав свою церковь Христианской методистской деноминацией.

Post отмечает, что деноминация, которая заявляет численность в 12,5 млн членов, была в начале 20-го века «крупнейшей протестантской деноминацией в США», но в последние десятилетия её численность сокращалась. Новый раскол станет вторым в истории церкви. Первый произошёл в 1968 г., когда примерно 10 процентов деноминации ушли в Евангелическую объединённую церковь братьев. Post отмечает, что предлагаемый раскол «наступил в критический момент для церкви, которая теряет членов в течение многих лет», которая была «выдвинута на грань раскола из-за роли людей LGBTQ в церкви». Однополые браки — не единственная проблема, которая разделила церковь. В 2016 г. деноминация была разделена по вопросу трансгендерного духовенства, при этом Северно-Тихоокеанская региональная конференция проголосовала за то, чтобы запретить им выполнять функции духовенства, а Южно-Тихоокеанская — против запрета.

[Title: United Methodists Agree to Historic Split

Subtitle: Those who oppose gay marriage will form their own denomination

Article: After two days of intense debate, the United Methodist Church has agreed to a historic split - one that is expected to end in the creation of a new denomination, one that will be “theologically and socially conservative,” according to The Washington Post. The majority of delegates attending the church’s annual General Conference in May voted to strengthen a ban on the ordination of LGBTQ clergy and to write new rules that will “discipline” clergy who officiate at same-sex weddings. But those who opposed these measures have a new plan: They say they will form a separate denomination by 2020, calling their church the Christian Methodist denomination.

The Post notes that the denomination, which claims 12.5 million members, was in the early 20th century the “largest Protestant denomination in the U. S.,” but that it has been shrinking in recent decades. The new split will be the second in the church’s history. The first occurred in 1968, when roughly 10 percent of the denomination left to form the Evangelical United Brethren Church. The Post notes that the proposed split “comes at a critical time for the church, which has been losing members for years,” which has been “pushed toward the brink of a schism over the role of LGBTQ people in the church.” Gay marriage is not the only issue that has divided the church. In 2016, the denomination was split over ordination of transgender clergy, with the North Pacific regional conference voting to ban them from serving as clergy, and the South Pacific regional conference voting to allow them.]

GPT-3 оказалась способна не только генерировать тексты (в том числе стихи, шутки и литературные пародии), но и исправлять грамматические ошибки, вести диалоги и даже (ВНЕЗАПНО!) писать более-менее осмысленный программный код. Множество интересных применений GPT-3 можно найти на сайте независимого исследователя Гверна Бренуэна. Бренуэн, развивая идею, высказанную в шуточном твите Андрея Карпатого, задаётся интересным вопросом: не являемся ли мы свидетелями появления новой парадигмы программирования?

Вот текст исходного твита Карпатого: «Мне нравится идея Программного обеспечения 3.0 😂. Программирование переходит от подготовки датасетов к подготовке запросов, позволяющих системе метаобучения „понять“ суть задачи, которую она должна выполнить. ЛОЛ» [Love the idea for Software 3.0 😂. Programming moving from curating datasets to curating prompts to make the meta learner “get” the task it’s supposed to be doing. LOL][2].

Развивая идею Карпатого, Бренуэн пишет:

Нейронная сеть GPT-3 настолько огромна с точки зрения мощности и набора [использованных для обучения] данных, что демонстрирует качественно иное поведение: вы не применяете её к фиксированному набору задач, представленных в обучающем датасете, что требует повторного обучения модели на дополнительных данных, если вы хотите решить новую задачу (именно так надо переучивать GPT-2); вместо этого вы взаимодействуете с моделью, выражая любую задачу в виде описаний, запросов и примеров на естественном языке, подстраивая текст затравки [prompt], подаваемой на вход модели, до тех пор, пока она не «поймёт» и не научится на метауровне решать новую задачу, основываясь на высокоуровневых абстракциях, которые она выучила во время предобучения. Это принципиально новый способ использования модели глубокого обучения, и его лучше рассматривать как новый вид программирования, где затравка теперь является «программой», которая программирует GPT-3 для выполнения новых задач. «Затравочное программирование» похоже не столько на обычное программирование, сколько на попытку научить суперинтеллектуального кота освоить новый трюк: вы можете попросить его выполнить трюк, и иногда он выполняет его идеально, что делает ещё более неприятной ситуацию, когда в ответ на запрос он сворачивается, чтобы вылизать свою задницу, при этом вы будете понимать, что проблема не в том, что он не может, а в том, что он не хочет[3].

Заголовок статьи, рассказывающей о модели GPT-3, звучит следующим образом: «Языковые модели — ученики, способные учиться всего на нескольких примерах» (Language Models are Few-Shot Learners). Что в данном случае имеется в виду? Возьмём для примера следующий текст: «русский: яблоко, английский: apple; русский: кошка, английский: cat; русский: дерево, английский: tree; русский: стол, английский:» и используем его в качестве затравки для GPT-3. Какое продолжение сгенерирует модель? Очевидно, что разумным продолжением такого текста является слово table, являющееся переводом на английский язык русского слова «стол». Оказывается, что GPT-3 способна «понять» это и сгенерировать правильное продолжение текста, опираясь всего на несколько примеров, помещённых в затравку. Способ обучения модели на крайне малом количестве примеров принято обозначать термином few-shot learning (обучение всего на нескольких примерах). Правда, если подумать, то указание примеров в затравке сложно считать полноценным обучением (learning) модели, ввиду чего некоторые исследователи стали называть такой подход few-shot prompting (составление затравки или запроса, содержащего небольшое количество примеров) или просто «натаскивание» [priming].

Удивительно, но применение этого метода позволяет использовать модель для решения огромного количества интеллектуальных задач: нужно лишь сформулировать задачу в виде текста, состоящего из вопросов и ответов.

Конечно, многие задачи GPT-3 решить таким образом не может, но всё же полученные результаты стали серьёзным шагом в направлении создания универсальных систем искусственного интеллекта. Более того, модели, подобные GPT-3, способны решать некоторые задачи в ещё более экстремальных условиях: когда затравка и вовсе не содержит ни одного примера! Такой способ называется zero-shot learning (обучение при отсутствии примеров) или даже, если пожелаете, zero-shot prompting — то есть вы можете написать в затравке «русский: стол, английский:» и надеяться, что модель «догадается», что правильным продолжением будет table. Оказывается, что иногда и этот подход работает![4]

Конечно, никто не мешает использовать для GPT-3 и классический для предобученных моделей подход, заключающийся в дообучении [fine-tuning] модели на целевых данных в течение ограниченного числа шагов и с небольшим значением параметра скорости обучения. Но в случае версий модели с достаточно большим числом параметров такой подход может оказаться вычислительно затратным, а иногда и вовсе невозможным в отсутствие дорогого специализированного оборудования. Возможным решением может стать обучение, затрагивающее не всё множество весов модели, а лишь их некоторую часть. Этого можно добиться путём «заморозки» части слоёв модели или использования адаптеров — новых нейросетевых блоков, вставляемых между слоями предобученной сети, веса которой при этом остаются неизменными[5], [6]. Именно на этом подходе основан популярный в наши дни метод LoRA (Low-Rank Adaptation, Низкоранговая адаптация)[7].

Интересно, что иногда ограничение числа подстраиваемых в ходе дообучения параметров может приводить к улучшению результатов модели при решении целевой задачи. Например, авторы работы «Воспитайте ребёнка в большой языковой модели: на пути к эффективному и обобщаемому дообучению» [Raise a Child in Large Language Model: Towards Effective and Generalizable Fine-tuning][8] разработали подход, позволяющий выбирать подсеть большой сети, наиболее важную для дообучения модели под конкретную задачу. Иногда специалисты в области машинного обучения предпочитают использовать и другие, более экономные, чем полноценное дообучение модели, методы, такие как ансамблирование [ensembling][9], пробинг («зондирование») [probing][10], [11], [12], [13], заморозку слоёв [layer freezing][14] или подстройку затравки [prompt tuning, prefix tuning, p-tuning][15], [16], [17], [18].

Идея ансамблирования заключается в том, чтобы комбинировать выход большой предобученной модели с выходом сравнительно небольшой модели, обученной решению целевой задачи на небольшом датасете. Например, маленькую версию GPT-3 можно обучить генерации текста в стиле определённого автора, а затем в качестве распределения вероятностей токенов при генерации текста использовать усреднённое распределение двух моделей — предобученной на огромном наборе разнообразных текстов гигантской версии GPT-3 и маленькой «авторской» версии. При этом оценки моделей можно сочетать и более умным образом, чем путём простого усреднения: например, можно использовать взвешенное усреднение или вовсе приспособить для генерации итогового распределения отдельную модель.

Идея пробинга заключается в том, чтобы обучить маленькую модель, решающую целевую задачу, отталкиваться от представлений, выученных большой предобученной моделью. По сути, этот подход похож на послойное обучение нейронной сети. Более того, нередко глубокие трансформерные модели действительно обучают послойно, «замораживая» веса в части слоёв предобученной модели. Но пробинг нередко имеет более изощрённую форму, когда на вход обучаемой модели-«надстройки» могут подаваться активации (выходы) из разных слоёв предобученной сети. Часто в качестве «надстройки» применяются простые линейные модели, такую разновидность пробинга называют линейным пробингом [Linear Probing или Linear Probe].

И наконец, последний подход, подстройка затравки, получил популярность именно благодаря развитию генеративных текстовых моделей. В рамках этого подхода развиваются алгоритмы, позволяющие разными автоматизированными способами модифицировать затравку при генерации, чтобы добиться от модели нужного поведения.

В конце 2020 г. в результате совместных усилий нескольких исследовательских команд «Сбера» (в числе которых было и моё Управление экспериментальных систем машинного обучения департамента SberDevices) на свет появилась русскоязычная версия GPT-3 под названием ruGPT-3. Используя суперкомпьютер «Кристофари», мы обучили несколько версий модели (с числом весов от 125 млн до 13 млрд).

В обучающую выборку, помимо традиционного для GPT-3 подмножества корпуса Common Crawl (результата сплошного сканирования интернет-сайтов), вошла солидная подборка книг на русском языке, русскоязычная «Википедия», огромные коллекции новостей, научных статей и диалогов, подборки вопросов и ответов на различные темы и множество других наборов текстовых данных. Первые эксперименты с моделью показывают, что она довольно хорошо справляется с задачей генерации текстов самой различной тематики.

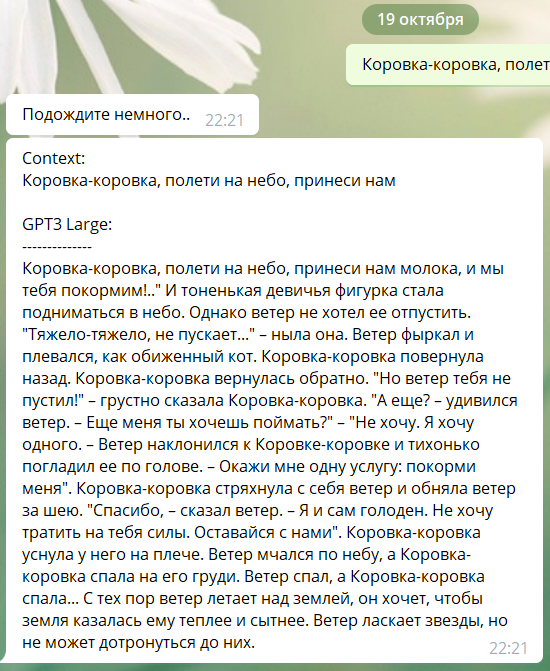

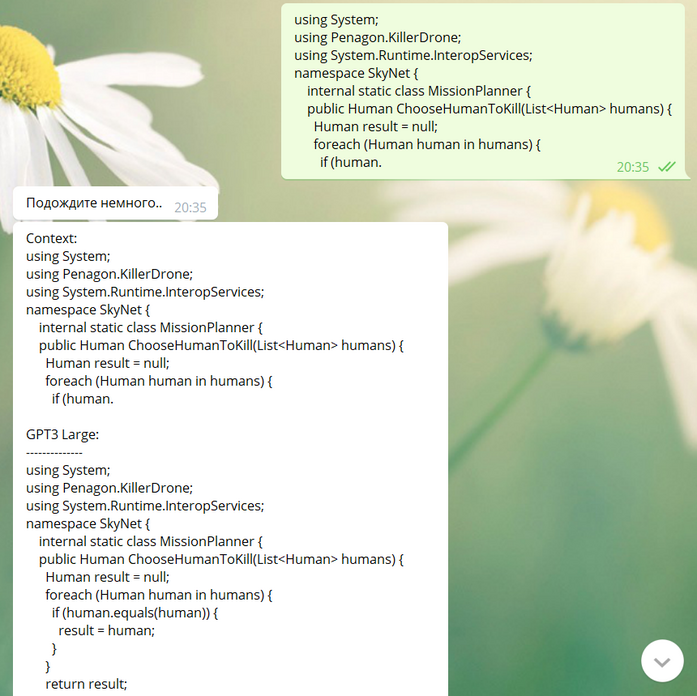

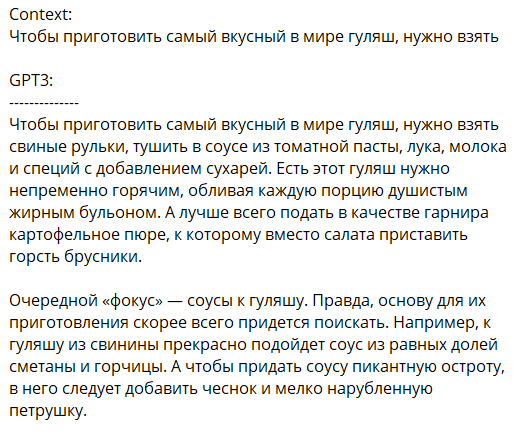

Рис. 146. Примеры генерации текстов от модели ruGPT-3

Рекламные тексты, гороскопы и жёлтые статьи[19] в исполнении ruGPT-3 ничем не уступают настоящим. Впрочем, подобные тексты и при написании их людьми редко относятся к разряду шедевров. Однако ruGPT-3 неплохо подходит и для генерации образцов художественной литературы. Вот, например, литературный анекдот в стиле Хармса, сочинённый нейросетью:

Навсегда запомнилось Пушкину, как Гоголь стал матросом. Он вышел из кабака и заглянул в один кабак, заглянул в другой, потом пошел домой, постучал в свою мазанку и сказал: «Я матрос!»

В мае 2022 г. издательство Individuum выпустило весьма примечательный сборник рассказов под названием «Пытаясь проснуться». Его соавторами стали писатель Павел Пепперштейн и нейросеть «Нейропепперштейн», представлявшая собой специальную версию ruGPT-3, дообученную на текстах самого Пепперштейна с небольшой примесью текстов других авторов (оказавших, по мнению экспертов, влияние на авторский стиль писателя). Двенадцать рассказов в сборнике принадлежат перу человека и ещё двенадцать написаны нейросетью. Хотя эта книга и не стала первым примером содружества искусственных и «органических» писателей (в качестве иллюстрации можно привести вышедшую ещё в 2013 г. книгу Дарби Ларсона «Раздражитель» [Irritant][20], в которой писатель использовал фрагменты текста, написанные генеративной LSTM-сетью, или созданную уже в трансформерную эпоху книгу Олли Грина «Робот Боб: Исследование Вселенной — Уютная сказка на ночь, созданная искусственным интеллектом» [Bob The Robot: Exploring the Universe — A Cozy Bedtime Story Produced by Artificial Intelligence][21], написанную в 2020 г. в соавторстве с GPT-3[22]); она, по всей видимости, стала первой книгой, написанной человеком в соавторстве с нейросетью-«двойником», обучавшейся имитировать стиль своего белкового соавтора. Читателям предлагается самостоятельно угадать: какие тексты были написаны машиной, а какие — человеком[23], [24].

Сегодня в содружестве с генеративными языковыми моделями созданы уже десятки, если не сотни книг[25], [26].

Наследниками ruGPT-3 стали модели ruGPT-3.5[27], [28], [29] и mGPT[30]. Первая представляет собой усовершенствованную версию модели (с более современной реализацией блоков внимания), дообученную на расширенной версии датасета (в него, в частности, вошли обширные библиотеки правовых текстов и программного кода), вторая — многоязычную версию модели, способную работать с текстами на 61 языке. Многоязычность сегодня стала одним из важных направлений развития языковых моделей[31] — многоязычные версии в наши дни можно найти практически для любых трансформерных архитектур. Например, многоязычными аналогами BERT являются модели mBERT[32] (обученная авторами оригинальной модели) и XLM-R[33], а среди множества многоязычных GPT помимо нашей mGPT можно отметить модель XGLM[34] от исследователей из Meta AI.

Модели семейства GPT на сегодняшний день являются не единственными представителями класса NLP-моделей, претендующих на универсальность при решении широкого спектра задач, связанных с обработкой естественного языка. Ещё в октябре 2019 г. в статье под названием «Исследование пределов переноса знаний при помощи унифицированного трансформера вида „текст-в-текст“» [Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer] публике была представлена модель T5 (Text-to-Text Transfer Transformer, Основанный на переносе трансформер вида «текст-в-текст») от исследователей из Google. Эта модель содержит равное количество блоков трансформера в кодирующей и декодирующей частях сети. Самый большой обученный создателями модели вариант T5 содержит 11 млрд параметров. Для обучения использовался корпус объёмом около 750 Гб, получивший название C4 (Colossal Clean Crawled Corpus, Колоссальный, очищенный, собранный в интернете корпус), являющийся отфильтрованной версией корпуса Common Crawl. T5 успешно справляется с такими задачами, как классификация высказываний, ответы на вопросы, перевод текста или его реферирование, показывая на ряде задач SOTA-результаты[35]. В октябре 2020 г. исследователи из Google выложили в общий доступ многоязычную версию своей модели, получившую название mT5. Для её обучения был использован гигантский датасет mC4, включающий в себя 6,6 млрд веб-страниц на 101 языке. Суммарный объём файлов датасета составляет почти 27 терабайт, что соответствует 6,3 млрд токенов[36].

В ноябре 2021 г. свет увидела ещё одна усовершенствованная версия модели T5, получившая название ExT5. В данном случае фокус был сделан на экстремальной многозадачности модели. Датасет для её обучения, получивший название ExMix (Extreme Mixture, Экстремальная смесь), включает в себя тексты заданий и решений для 107 различных задач, относящихся к разным доменам и семействам. ExT5 смогла заметно превзойти свою прародительницу на задачах из набора SuperGLUE и других сборниках тестов[37].

Модели, подобные GPT-3 или T5, нередко генерируют тексты хотя и грамматически корректные, но не слишком достоверные с фактической точки зрения. Скормив в ruGPT-3 список «интересных фактов», взятых с одного из развлекательных интернет-сайтов, для затравки, я однажды получил среди прочих такие «факты»:

- В Австралии бытует мнение, что если на тебя пристально смотрит лев, то это значит, что у тебя в руках морковка.

- В Арктике нет почтовых голубей. Все письма для белых медведей доставляет летчик-истребитель по радио.

- Выросший в утробе матери скорпион быстрее развивает скорость, чем обычный.

- Джентльмены делятся своими сигарами, если хотят произвести впечатление на женщин.

- Первый государственный банк открылся в России в 1769 г., в США — в 1792-м и так далее.

К такого рода фантазиям склонны в большей мере модели с небольшим числом параметров, но даже от модели с 13 млрд параметров не стоит ждать 100% проверенных фактов. В какой-то мере этим свойством модели можно управлять (например, изменяя параметры генератора последовательностей), но стоит задаться вопросом: а насколько с фактической точки зрения хороши ответы людей? Мир, полный псевдонаучных фриков, сторонников различных теорий заговора, антипрививочников, плоскоземельцев и так далее, генерирует соответствующий цифровой след. Неудивительно, что модели, обученные на случайных текстах из интернета, да ещё и использующие значительную случайную компоненту при выборе токенов во время генерации, периодически начинают производить на свет полную ересь. Обычно, если мне задают вопрос, требующий тех или иных фактических знаний, я обращаюсь к более-менее надёжным источникам во Всемирной сети, таким, например, как энциклопедии, научные статьи и обзоры и так далее. И главным помощником тут становятся поисковые сервисы, такие как Google (кстати говоря, алгоритмы их работы также основаны на современных моделях машинного обучения). Может быть, можно сделать ещё один шаг вперёд и научить нейронную сеть автоматически формировать поисковые запросы для извлечения фактических знаний из большой базы данных? Возможность этого продемонстрировали исследователи из DeepMind, создавшие модель, получившую название RETRO (Retrieval-Enhanced Transformer, Трансформер, усовершенствованный за счёт поиска). RETRO извлекает из большого набора документов релевантные фрагменты текста, чтобы затем использовать их при формировании ответа. Сравнивая сгенерированные тексты с отрывками, на которые модель опиралась при генерации, можно понять, на чём именно основаны полученные ответы[38]. В 2022 г. создатели модели Re-Imagen (Retrieval-augmented Text-to-Image Generator, Дополненный поиском генератор изображений по тексту)[39] применили аналогичный подход при генерации изображений, позволяя модели при генерации картинки «подглядывать» в извлекаемые из базы данных изображения объектов, редко встречающихся в обучающей выборке.

В январе 2021 г. исследователи из Google сообщили[40] о создании новой архитектуры для разреженных трансформерных моделей, названной Switch Transformer (дословно «переключатель-трансформер» или «коммутатор-трансформер»), — наследника архитектуры GShard[41]. Самая большая модель на основе этой архитектуры получила название Switch-C. Число обучаемых параметров этой модели — 1,571 трлн, что почти в девять раз больше, чем у GPT-3. Таким образом, Switch-C стала первой трансформерной моделью, преодолевшей порог в триллион параметров. Помимо увеличения размера модели, авторам удалось также добиться существенного ускорения её работы по сравнению с предшественниками. Впрочем, сравнивать Switch-трансформеры с моделями типа GPT-3 или T5 не совсем правильно, поскольку в данном случае речь идёт не о монолитной нейросетевой архитектуре, а о сети с разреженным типом активации, состоящей из множества отдельных подсетей-экспертов, переключение между которыми выполняет отдельная нейросетевая модель-диспетчер (Gating Network). При этом каждая сеть-эксперт может располагаться на отдельном узле вычислительного кластера. В итоге на каждом шаге обучения сети обновляется лишь сравнительно небольшое подмножество весов сети, что делает задачу обучения и выполнения сети более экономной с вычислительной точки зрения (впрочем, ценой некоторого падения точности модели). Такую архитектуру сети называют «смесь экспертов» (Mixture-of-Experts, MoE). Процесс обучения MoE-модели чем-то похож на послойное обучение глубоких сетей, популярное на границе тысячелетий. Неслучайно, что первое описание MoE-подхода мы находим в работах[42], [43] Джеффри Хинтона и его коллег с начала 1990-х гг.

В наши дни исследования в области MoE-моделей ведутся довольно активно. Например, в сентябре 2021 г. исследователи из Microsoft рассказали о модели под названием Z-code M3 (M3 означает Multitask, Multilingual и MoE — Многозадачная, многоязычная и MoE)[44], в декабре появилась новая MoE-модель от Google под названием GLaM (Generalist Language Model, Универсальная языковая модель)[45], а под конец года о создании собственных языковых моделей на основе парадигмы MoE заявили исследователи из Meta (бывшей Facebook)[46]. По слухам, MoE-подход был использован и при создании GPT-4 от OpenAI[47].

В апреле 2021 г. исследователи из китайской компании Huawei опубликовали генеративную языковую модель для китайского языка, получившую название PANGU-α[48]. В древнекитайской мифологии Пань-гу (кит. трад. 盤古, упр. 盘古, пиньинь Pángǔ) — первый человек на земле, появившийся из вселенского яйца и взмахом огромного топора отделивший мутную часть — землю (Инь) от светлой части — неба (Ян).

В самой большой версии PANGU-α 207 млрд параметров, что на 32 млрд параметров больше, чем в самой большой версии GPT-3. Модель обучена на специально созданном текстовом корпусе объёмом около 1,1 терабайта.

Не остались без внимания китайских исследователей и MoE-модели. Исследователи из Пекинской академии искусственного интеллекта (北京智源人工智能研究院, Beijing Academy of Artificial Intelligence, BAAI) создали собственную платформу для обучения таких моделей, получившую название FastMoE. Эта платформа позволяет использовать для обучения MoE-моделей как суперкомпьютеры, так и обычные GPU. Благодаря FastMoE китайские исследователи весной 2021 г. смогли обучить модель под названием Wudao (悟道, так зовут повара-монаха, героя Джеки Чана в фильме «Новый храм Шаолинь»), вторая версия которой, представленная общественности 31 мая, имела 1,75 трлн параметров (что на 150 млрд больше, чем у модели Switch-C)[49].

В октябре 2021 г. исследователи из Академии DAMO (Academy for Discovery, Adventure, Momentum and Outlook, Академия открытий, авантюр, импульса и перспектив) — исследовательского подразделения компании Alibaba — сообщили[50] о создании новой версии своей MoE-модели M6 (MultiModality-to-MultiModality Multitask Mega-Transformer, Многозадачный мегатрансформер из мультимодальных представлений в мультимодальные) с 10 трлн параметров.

В апреле 2022 г. группа китайских исследователей из DAMO, Университета Цинхуа, Пекинской академии искусственного интеллекта и Лаборатории Чжэцзян (之江实验室) (научно-исследовательского учреждения, созданного совместно правительством провинции Чжэцзян, Чжэцзянским университетом и Alibaba Group) сообщила[51] о создании MoE-модели MoDa-174T (от MoE и Data — название отсылает к гибридной стратегии параллелизма MoE и данных) с 173,9 трлн параметров, в состав которой входят целых 96 000 сетей-экспертов. Для обучения модели использовались фреймворк BaGuaLu[52] и суперкомпьютер Sunway последнего поколения. Модель обучали на самом большом китайском мультимодальном датасете — M6‑Corpus[53], содержащем 1,9 Тб изображений и 292 Гб текстов. К сожалению, авторы не приводят информации о результатах решения моделью различных тестовых задач, поэтому о способностях MoDa-174T мы пока что можем только догадываться.

На сентябрь 2023 г. MoDa-174T, по всей видимости, является самой большой MoE-нейросетевой моделью, а первую по числу параметров позицию среди «монолитных» генеративных языковых трансформерных моделей (и нейросетевых моделей вообще) заняла сеть Megatron-Turing NLG 530B с 530 млрд параметров, созданная специалистами из Nvidia и Microsoft[54], [55].

Если же рассматривать только модели, веса которых были выложены в открытый доступ, то лидерство принадлежит опубликованной в сентябре 2023 г. самой крупной версии модели Falcon[56] со 180 млрд параметров от Института технологических инноваций (Technology Innovation Institute) — правительственной исследовательской организации из Объединённых Арабских Эмиратов. Второе место принадлежит модели BLOOM[57] со 176 млрд параметров, увидевшей свет в ноябре 2022 г. и созданной международной группой из 391 исследователя, входящих в коллаборацию BigScience (в их числе и Татьяна Шаврина из моей команды в Сбере). Третье место удерживает модель OPT-175B[58], [59], созданная ещё полугодом ранее исследователями компании Meta (бывшая Facebook) и отставшая от BLOOM на 1 млрд параметров. Четвёртое же место достаётся вышедшей на неделю позже BLOOM модели Galactica[60] со 120 млрд параметров, в обучающий корпус которой вошли преимущественно научные тексты.

- ↑ Brown T. B., Mann B., Ryder N., Subbiah M., Kaplan J., Dhariwal P., Neelakantan A., Shyam P., Sastry G., Askell A., Agarwal S., Herbert-Voss A., Krueger G., Henighan T., Child R., Ramesh A., Ziegler D. M., Wu J., Winter C., Hesse C., Chen M., Sigler E., Litwin M., Gray S., Chess B., Clark J., Berner C., McCandlish S., Radford A., Sutskever I., Amodei D. (2020). Language Models are Few-Shot Learners // https://arxiv.org/abs/2005.14165

- ↑ Karpathy A. (2020) / Twitter // https://twitter.com/karpathy/status/1273788774422441984

- ↑ Branwen G. (2020). GPT-3 Creative Fiction // https://www.gwern.net/GPT-3

- ↑ Reynolds L., McDonell K. (2021). Prompt Programming for Large Language Models: Beyond the Few-Shot Paradigm // https://arxiv.org/abs/2102.07350

- ↑ Rebuffi S.-A., Bilen H., Vedaldi A. (2017). Learning multiple visual domains with residual adapters // https://arxiv.org/abs/1705.08045

- ↑ Houlsby N., Giurgiu A., Jastrzebski S., Morrone B., de Laroussilhe Q., Gesmundo A., Attariyan M., Gelly S. (2019). Parameter-Efficient Transfer Learning for NLP // https://arxiv.org/abs/1902.00751

- ↑ Hu E. J., Shen Y., Wallis P., Allen-Zhu Z., Li Y., Wang S., Wang L., Chen W. (2021). LoRA: Low-Rank Adaptation of Large Language Models // https://arxiv.org/abs/2106.09685

- ↑ Xu R., Luo F., Zhang Z., Tan C., Chang B., Huang S., Huang F. (2021). Raise a Child in Large Language Model: Towards Effective and Generalizable Fine-tuning // https://arxiv.org/abs/2109.05687

- ↑ Duan Z., Zhang H., Wang C., Wang Z., Chen B., Zhou M. (2021). EnsLM: Ensemble Language Model for Data Diversity by Semantic Clustering / Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers), pp. 2954—2967 // https://doi.org/10.18653/v1/2021.acl-long.230

- ↑ Conneau A., Kruszewski G., Lample G., Barrault L., Baroni M. (2018). What you can cram into a single vector: Probing sentence embeddings for linguistic properties // https://arxiv.org/abs/1805.01070

- ↑ Şahin G. G., Vania C., Kuznetsov I., Gurevych I. (2019). LINSPECTOR: Multilingual Probing Tasks for Word Representations // https://arxiv.org/abs/1903.09442

- ↑ Kim N., Patel R., Poliak A., Wang A., Xia P., McCoy R. T., Tenney I., Ross A., Linzen T., Durme B. V., Bowman S. R., Pavlick E. (2019). Probing What Different NLP Tasks Teach Machines about Function Word Comprehension // https://arxiv.org/abs/1904.11544

- ↑ Shi X., Padhi I., Knight K. (2016). Does String-Based Neural MT Learn Source Syntax? / Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing, pp. 1526—1534 // https://doi.org/10.18653/v1/D16-1159

- ↑ Lee J., Tang R., Lin J. (2019). What Would Elsa Do? Freezing Layers During Transformer Fine-Tuning // https://arxiv.org/abs/1911.03090

- ↑ Li X. L., Liang P. (2021). Prefix-Tuning: Optimizing Continuous Prompts for Generation // https://arxiv.org/abs/2101.00190

- ↑ Liu X., Zheng Y., Du Z., Ding M., Qian Y., Yang Z., Tang J. (2021). GPT Understands, Too // https://arxiv.org/abs/2103.10385

- ↑ Lester B., Al-Rfou R., Constant N. (2021). The Power of Scale for Parameter-Efficient Prompt Tuning // https://arxiv.org/abs/2104.08691

- ↑ Конодюк Н. (2021). Управляем генерацией ruGPT-3: библиотека ruPrompts / Хабр, 17 декабря 2021 // https://habr.com/ru/company/sberdevices/blog/596103/

- ↑ * Чего стоит хотя бы такой пассаж: «Кроме того, Пугачёва раскрыла подробности своей биографии, в которой оказалось немало скандальных эпизодов. Например, она утверждала, что в молодости была гейшей, а также что у неё в шкафу хранился сухой паёк на случай атомной войны, а её зять Г. Л. Рамазанов открыл для себя ясновидение».

- ↑ Larson D. (2013). Irritant. Blue Square Press // https://books.google.ru/books?id=lOdOmwEACAAJ

- ↑ Green O. (2020). Bob The Robot: Exploring the Universe — A Cozy Bedtime Story Produced by Artificial Intelligence. Kindle Edition // https://www.amazon.com/Bob-Robot-Exploring-Artificial-Intelligence-ebook/dp/B08GL2YWGY

- ↑ Green O. (2020). How to write and publish a book using Machine Learning (GPT-3) // https://www.youtube.com/watch?v=oKh_Jxfeae0

- ↑ Пепперштейн Н., Пепперштейн П. (2022). Пытаясь проснуться // https://www.litres.ru/book/neyro-peppershteyn/pytayas-prosnutsya-68292629/

- ↑ Шаврина Т. (2022). Это наконец произошло: нейросеть и человек написали книгу. Вместе! Рассказываем, как им помогали разработчики. / Хабр, 25 мая 2022 // https://habr.com/ru/companies/sberdevices/articles/667582/

- ↑ Thompson D. A. (2022). Books by AI (GPT-3, GPT-3.5, ChatGPT) / LifeArchitect.ai // https://lifearchitect.ai/books-by-ai/

- ↑ Branwen G. (2020). GPT-3 Creative Fiction // https://www.gwern.net/GPT-3

- ↑ Аверкиев С. (2023). Сбер открывает доступ к нейросетевой модели ruGPT-3.5 / Хабр, 20 июля 2023 // https://habr.com/ru/companies/sberbank/articles/746736/

- ↑ Аверкиев С. (2023). Это не чат, это GigaChat. Русскоязычная ChatGPT от Сбера / Хабр, 24 апреля 2023 // https://habr.com/ru/companies/sberbank/articles/730108/

- ↑ Zmitrovich D., Abramov A., Kalmykov A., Tikhonova M., Taktasheva E., Astafurov D., Baushenko M., Snegirev A., Shavrina T., Markov S., Mikhailov V., Fenogenova A. (2023). A Family of Pretrained Transformer Language Models for Russian // https://arxiv.org/abs/2309.10931

- ↑ Shliazhko O., Fenogenova A., Tikhonova M., Mikhailov V., Kozlova A., Shavrina T. (2022). mGPT: Few-Shot Learners Go Multilingual // https://arxiv.org/abs/2204.07580

- ↑ Ruder S. (2023). The State of Multilingual AI // https://www.ruder.io/state-of-multilingual-ai/

- ↑ Devlin J., Chang M.-W., Lee K., Toutanova K. (2018). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding // https://arxiv.org/abs/1810.04805

- ↑ Conneau A., Khandelwal K., Goyal N., Chaudhary V., Wenzek G., Guzmán F., Grave E., Ott M., Zettlemoyer L., Stoyanov V. (2019). Unsupervised Cross-lingual Representation Learning at Scale // https://arxiv.org/abs/1911.02116

- ↑ Lin X. V., Mihaylov T., Artetxe M., Wang T., Chen S., Simig D., Ott M., Goyal N., Bhosale S., Du J., Pasunuru R., Shleifer S., Koura P. S., Chaudhary V., O'Horo B., Wang J., Zettlemoyer L., Kozareva Z., Diab M., Stoyanov V., Li X. (2021). Few-shot Learning with Multilingual Language Models // https://arxiv.org/abs/2112.10668

- ↑ Raffel C., Shazeer N., Roberts A., Lee K., Narang S., Matena M., Zhou Y., Li W., Liu P. J. (2019). Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer // https://arxiv.org/abs/1910.10683

- ↑ Xue L., Constant N., Roberts A., Kale M., Al-Rfou R., Siddhant A., Barua A., Raffel C. (2020). mT5: A massively multilingual pre-trained text-to-text transformer // https://arxiv.org/abs/2010.11934

- ↑ Aribandi V., Tay Y., Schuster T., Rao J., Zheng H. S., Mehta S. V., Zhuang H., Tran V. Q., Bahri D., Ni J., Gupta J., Hui K., Ruder S., Metzler D. (2021). ExT5: Towards Extreme Multi-Task Scaling for Transfer Learning // https://arxiv.org/abs/2111.10952

- ↑ Rae J., Irving G., Weidinger L. (2021). Language modelling at scale: Gopher, ethical considerations, and retrieval / DeepMind blog, 08 Dec 2021 // https://deepmind.com/blog/article/language-modelling-at-scale

- ↑ Chen W., Hu H., Saharia C., Cohen W. W. (2022). Re-Imagen: Retrieval-Augmented Text-to-Image Generator // https://arxiv.org/abs/2209.14491

- ↑ Fedus W., Zoph B., Shazeer N. (2021). Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity // https://arxiv.org/abs/2101.03961

- ↑ Lepikhin D., Lee H., Xu Y., Chen D., Firat O., Huang Y., Krikun M., Shazeer N., Chen Z. (2020). GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding // https://arxiv.org/abs/2006.16668

- ↑ Jacobs R. A., Jordan M. I., Nowlan S. J., Hinton G. E. (1991). Adaptive Mixtures of Local Experts // http://www.cs.toronto.edu/~fritz/absps/jjnh91.pdf

- ↑ Shazeer N., Mirhoseini A., Maziarz K., Davis A., Le Q., Hinton G., Dean J. (2017). Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer // https://arxiv.org/abs/1701.06538

- ↑ Kim Y. J., Awan A. A., Muzio A., Salinas A. F. C., Lu L., Hendy A., Rajbhandari S., He Y., Awadalla H. H. (2021). Scalable and Efficient MoE Training for Multitask Multilingual Models // https://arxiv.org/abs/2109.10465

- ↑ Du N., Huang Y., Dai A. M., Tong S., Lepikhin D., Xu Y., Krikun M., Zhou Y., Yu A. W., Firat O., Zoph B., Fedus L., Bosma M., Zhou Z., Wang T., Wang Y. E., Webster K., Pellat M., Robinson K., Meier-Hellstern K., Duke T., Dixon L., Zhang K., Le Q. V., Wu Y., Chen Z., Cui C. (2021). GLaM: Efficient Scaling of Language Models with Mixture-of-Experts // https://arxiv.org/abs/2112.06905

- ↑ Artetxe M., Bhosale S., Goyal N., Mihaylov T., Ott M., Shleifer S., Lin X. V., Du J., Iyer S., Pasunuru R., Anantharaman G., Li X., Chen S., Akin H., Baines M., Martin L., Zhou X., Koura P. S., O'Horo B., Wang J., Zettlemoyer L., Diab M., Kozareva Z., Stoyanov V. (2021). Efficient Large Scale Language Modeling with Mixtures of Experts // https://arxiv.org/abs/2112.10684

- ↑ Schreiner M. (2023). GPT-4 architecture, datasets, costs and more leaked. / The Decoder, Jul. 11, 2023. // https://the-decoder.com/gpt-4-architecture-datasets-costs-and-more-leaked/

- ↑ Zeng W., Ren X., Su T., Wang H., Liao Y., Wang Z., Jiang X., Yang Z., Wang K., Zhang X., Li C., Gong Z., Yao Y., Huang X., Wang J., Yu J., Guo Q., Yu Y., Zhang Y., Wang J., Tao H., Yan D., Yi Z., Peng F., Jiang F., Zhang H., Deng L., Zhang Y., Lin Z., Zhang C., Zhang S., Guo M., Gu S., Fan G., Wang Y., Jin X., Liu Q., Tian Y. (2021). PanGu-α: Large-scale Autoregressive Pretrained Chinese Language Models with Auto-parallel Computation // https://arxiv.org/abs/2104.12369

- ↑ Du C. (2021). Chinese AI lab challenges Google, OpenAI with a model of 1.75 trillion parameters / PingWest, June 1, 2021 // https://en.pingwest.com/a/8693

- ↑ Lin J., Yang A., Bai J., Zhou C., Jiang L., Jia X., Wang A., Zhang J., Li Y., Lin W., Zhou J., Yang H. (2021). M6-10T: A Sharing-Delinking Paradigm for Efficient Multi-Trillion Parameter Pretraining // https://arxiv.org/abs/2110.03888

- ↑ Ma Z., He J., Qiu J., Cao H., Wang Y., Sun Z., Zheng L., Wang H., Tang S., Zheng T., Lin J., Feng G., Huang Z., Gao J., Zeng A., Zhang J., Zhong R., Shi T., Liu S., Zheng W., Tang J., Yang H., Liu X., Zhai J., Chen W. (2022). BaGuaLu: targeting brain scale pretrained models with over 37 million cores // PPoPP '22: Proceedings of the 27th ACM SIGPLAN Symposium on Principles and Practice of Parallel Programming, pp. 192–204. // https://doi.org/10.1145/3503221.3508417

- ↑ * BaGuaLu (八卦炉), печь восьми триграмм (восьми гуа), волшебная печь из древнекитайской мифологии, позволяющая создавать эффективные лекарства. Восемь триграмм гуа используются в даосской космологии, чтобы представить фундаментальные принципы бытия.

- ↑ Lin J., Men R., Yang A., Zhou C., Ding M., Zhang Y., Wang P., Wang A., Jiang L., Jia X., Zhang J., Zhang J., Zou X., Li Z., Deng X., Liu J., Xue J., Zhou H., Ma J., Yu J., Li Y., Lin W., Zhou J., Tang J., Yang H. (2021). M6: A Chinese Multimodal Pretrainer // https://arxiv.org/abs/2103.00823

- ↑ Kharya P., Alvi A. (2021). Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, the World’s Largest and Most Powerful Generative Language Model / Nvidia Developer Blog, Oct 11, 2021 // https://developer.nvidia.com/blog/using-deepspeed-and-megatron-to-train-megatron-turing-nlg-530b-the-worlds-largest-and-most-powerful-generative-language-model/

- ↑ Smith S., Patwary M., Norick B., LeGresley P., Rajbhandari S., Casper J., Liu Z., Prabhumoye S., Zerveas G., Korthikanti V., Zhang E., Child R., Aminabadi R. Y., Bernauer J., Song X., Shoeybi M., He Y., Houston M., Tiwary S., Catanzaro B. (2022). Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, A Large-Scale Generative Language Model // https://arxiv.org/abs/2201.11990

- ↑ Almazrouei E., Alobeidli H., Alshamsi A., Cappelli A., Cojocaru R., Alhammadi M., Mazzotta D., Heslow D., Launay J., Malartic Q., Noune B., Pannier B., Penedo G. (2023). The Falcon Series of Language Models: Towards Open Frontier Models // https://huggingface.co/tiiuae/falcon-180B

- ↑ Le Scao T., Fan A., Akiki C., Pavlick E., Ilić S., Hesslow D., Castagné R., Luccioni A. S., Yvon F., Gallé M., Tow J., Rush A. M., Biderman S., Webson A., Ammanamanchi P. S., Wang T., Sagot B., Muennighoff N., Moral A. V. d., Ruwase O., Bawden R., Bekman S., McMillan-Major A., Beltagy I., Nguyen H., Saulnier L., Tan S., Suarez P. O., Sanh V., Laurençon H., Jernite Y., Launay J., Mitchell M., Raffel C., Gokaslan A., Simhi A., Soroa A., Aji A. F., Alfassy A., Rogers A., Nitzav A. K., Xu C., Mou C., Emezue C., Klamm C., Leong C., Strien D. v., Adelani D. I., Radev D., Ponferrada E. G., Levkovizh E., Kim E., Natan E. B., Toni F. D., Dupont G., Kruszewski G., Pistilli G., Elsahar H., Benyamina H., Tran H., Yu I., Abdulmumin I., Johnson I., Gonzalez-Dios I., Rosa J. d. l., Chim J., Dodge J., Zhu J., Chang J., Frohberg J., Tobing J., Bhattacharjee J., Almubarak K., Chen K., Lo K., Von Werra L., Weber L., Phan L., allal L. B., Tanguy L., Dey M., Muñoz M. R., Masoud M., Grandury M., Šaško M., Huang M., Coavoux M., Singh M., Jiang M. T., Vu M. C., Jauhar M. A., Ghaleb M., Subramani N., Kassner N., Khamis N., Nguyen O., Espejel O., Gibert O. d., Villegas P., Henderson P., Colombo P., Amuok P., Lhoest Q., Harliman R., Bommasani R., López R. L., Ribeiro R., Osei S., Pyysalo S., Nagel S., Bose S., Muhammad S. H., Sharma S., Longpre S., Nikpoor S., Silberberg S., Pai S., Zink S., Torrent T. T., Schick T., Thrush T., Danchev V., Nikoulina V., Laippala V., Lepercq V., Prabhu V., Alyafeai Z., Talat Z., Raja A., Heinzerling B., Si C., Taşar D. E., Salesky E., Mielke S. J., Lee W. Y., Sharma A., Santilli A., Chaffin A., Stiegler A., Datta D., Szczechla E., Chhablani G., Wang H., Pandey H., Strobelt H., Fries J. A., Rozen J., Gao L., Sutawika L., Bari M. S., Al-shaibani M. S., Manica M., Nayak N., Teehan R., Albanie S., Shen S., Ben-David S., Bach S. H., Kim T., Bers T., Fevry T., Neeraj T., Thakker U., Raunak V., Tang X., Yong Z., Sun Z., Brody S., Uri Y., Tojarieh H., Roberts A., Chung H. W., Tae J., Phang J., Press O., Li C., Narayanan D., Bourfoune H., Casper J., Rasley J., Ryabinin M., Mishra M., Zhang M., Shoeybi M., Peyrounette M., Patry N., Tazi N., Sanseviero O., von Platen P., Cornette P., Lavallée P. F., Lacroix R., Rajbhandari S., Gandhi S., Smith S., Requena S., Patil S., Dettmers T., Baruwa A., Singh A., Cheveleva A., Ligozat A., Subramonian A., Névéol A., Lovering C., Garrette D., Tunuguntla D., Reiter E., Taktasheva E., Voloshina E., Bogdanov E., Winata G. I., Schoelkopf H., Kalo J., Novikova J., Forde J. Z., Clive J., Kasai J., Kawamura K., Hazan L., Carpuat M., Clinciu M., Kim N., Cheng N., Serikov O., Antverg O., Wal O. v. d., Zhang R., Zhang R., Gehrmann S., Mirkin S., Pais S., Shavrina T., Scialom T., Yun T., Limisiewicz T., Rieser V., Protasov V., Mikhailov V., Pruksachatkun Y., Belinkov Y., Bamberger Z., Kasner Z., Rueda A., Pestana A., Feizpour A., Khan A., Faranak A., Santos A., Hevia A., Unldreaj A., Aghagol A., Abdollahi A., Tammour A., HajiHosseini A., Behroozi B., Ajibade B., Saxena B., Ferrandis C. M., Contractor D., Lansky D., David D., Kiela D., Nguyen D. A., Tan E., Baylor E., Ozoani E., Mirza F., Ononiwu F., Rezanejad H., Jones H., Bhattacharya I., Solaiman I., Sedenko I., Nejadgholi I., Passmore J., Seltzer J., Sanz J. B., Dutra L., Samagaio M., Elbadri M., Mieskes M., Gerchick M., Akinlolu M., McKenna M., Qiu M., Ghauri M., Burynok M., Abrar N., Rajani N., Elkott N., Fahmy N., Samuel O., An R., Kromann R., Hao R., Alizadeh S., Shubber S., Wang S., Roy S., Viguier S., Le T., Oyebade T., Le T., Yang Y., Nguyen Z., Kashyap A. R., Palasciano A., Callahan A., Shukla A., Miranda-Escalada A., Singh A., Beilharz B., Wang B., Brito C., Zhou C., Jain C., Xu C., Fourrier C., Periñán D. L., Molano D., Yu D., Manjavacas E., Barth F., Fuhrimann F., Altay G., Bayrak G., Burns G., Vrabec H. U., Bello I., Dash I., Kang J., Giorgi J., Golde J., Posada J. D., Sivaraman K. R., Bulchandani L., Liu L., Shinzato L., Bykhovetz M. H. d., Takeuchi M., Pàmies M., Castillo M. A., Nezhurina M., Sänger M., Samwald M., Cullan M., Weinberg M., Wolf M. D., Mihaljcic M., Liu M., Freidank M., Kang M., Seelam N., Dahlberg N., Broad N. M., Muellner N., Fung P., Haller P., Chandrasekhar R., Eisenberg R., Martin R., Canalli R., Su R., Su R., Cahyawijaya S., Garda S., Deshmukh S. S., Mishra S., Kiblawi S., Ott S., Sang-aroonsiri S., Kumar S., Schweter S., Bharati S., Laud T., Gigant T., Kainuma T., Kusa W., Labrak Y., Bajaj Y. S., Venkatraman Y., Xu Y., Xu Y., Xu Y., Tan Z., Xie Z., Ye Z., Bras M., Belkada Y., Wolf T. (2022). BLOOM: A 176B-Parameter Open-Access Multilingual Language Model // https://arxiv.org/abs/2211.05100

- ↑ Zhang S., Roller S., Goyal N., Artetxe M., Chen M., Chen S., Dewan C., Diab M., Li X., Lin X. V., Mihaylov T., Ott M., Shleifer S., Shuster K., Simig D., Koura P. S., Sridhar A., Wang T., Zettlemoyer L. (2022). OPT: Open Pre-trained Transformer Language Models // https://arxiv.org/abs/2205.01068

- ↑ Zhang S., Diab M., Zettlemoyer L. (2022). Democratizing access to large-scale language models with OPT-175B / Meta AI, May 3, 2022 // https://ai.facebook.com/blog/democratizing-access-to-large-scale-language-models-with-opt-175b/

- ↑ Taylor R., Kardas M., Cucurull G., Scialom T., Hartshorn A., Saravia E., Poulton A., Kerkez V., Stojnic R. (2022). Galactica: A Large Language Model for Science // https://arxiv.org/abs/2211.09085