6.6.7 Машина как художник. Первые шаги: раскраска и стилизация

Впрочем, если литературные успехи машин пока ещё не столь известны широкой публике, об их достижениях в изобразительном искусстве знают сегодня почти все. Возможно, дело тут в большей наглядности результатов или в том, что революция глубокого обучения началась именно с успехов в обработке изображений. А может быть, дело в том, что здесь более заметен быстрый и внушительный прогресс — какие-никакие тексты машины умели писать ещё в эпоху GOFAI, а вот успехи с генерацией изображений были куда более скромными. Конечно, основываясь на генераторе псевдослучайных чисел и небольшом наборе графических примитивов (точка, отрезок, окружность и т. п.), можно было создавать различные узоры, напоминающие картинки калейдоскопа. В принципе, и сам калейдоскоп вполне можно считать специализированной машиной для генерации изображений. Название «калейдоскоп» происходит от греческих слов καλός — красивый, εἶδος — вид и σκοπέω — смотрю, наблюдаю. Это устройство стало побочным продуктом опытов с поляризацией света, которые проводил в начале XIX в. шотландский физик Дейвид Брюстер. Брюстер запатентовал калейдоскоп в 1816 г., и с тех пор это удивительное в своей простоте устройство начало триумфальное шествие по миру.

Со временем было предложено множество модификаций калейдоскопа, а появление «алгоритмических калейдоскопов» открыло совершенно новые возможности. Теперь любители калейдоскопического жанра не были больше скованы ограничениями механических систем. В какой-то мере к этому же жанру можно отнести моду на визуализацию различных математических функций. Особенной популярностью здесь пользуются фракталы — множества, обладающие свойством самоподобия. Множество Мандельброта, множество Жюлиа, треугольник и ковёр Серпинского, губка Менгера, кривые Коха, Пеано, Леви и Гильберта, а также многие другие математические формализмы способны порождать удивительные узоры, приятные глазу. Многие природные объекты обладают структурой, напоминающей фракталы (поэтому их часто называют квазифракталами), — снежинки, кораллы, морские звёзды и ежи, ракушки, некоторые растения и их цветы. В общем, совмещение фрактальных моделей с продвинутыми средствами визуализации, безусловно, способно подарить нам множество весьма изящных произведений генеративного искусства. Однако отношения машин с реалистическим искусством в эпоху GOFAI не сложились. Заметный шаг вперёд удалось сделать лишь в эру глубокого обучения.

Дети, постигающие премудрости изобразительного искусства, от каляк-маляк обычно переходят к книжкам-раскраскам. Если нейронная сеть способна распознавать на изображениях различные объекты, то, быть может, она сможет и раскрасить чёрно-белое изображение? Действительно, при работе с раскраской ключевым умением является именно узнавание объекта. Опознав на картинке солнце, мы берём жёлтый фломастер, а увидев ёлочку — зелёный. Получить обучающую выборку в эпоху цифровой фотографии и интернета проще простого, достаточно взять множество цифровых изображений и обесцветить их, получив тем самым множество пар бесцветных и цветных картинок. Неудивительно, что число работ по нейросетевой раскраске изображений стало быстро увеличиваться по мере роста популярности свёрточных нейронных сетей.

В начале 2016 г. свою первую нейросетевую модель для раскраски фотографий представил[1] на суд общественности американский программист Райан Даль, известный в компьютерном мире как первоначальный разработчик популярной программной платформы Node.js. Даль использовал для раскраски модель VGG-16, предварительно обученную распознаванию изображений из массива ImageNet. Ему даже не пришлось переобучать модель — вместо этого он воспользовался идеей, предложенной уже упоминавшимися нами создателями сети ZFNet Робом Фергюсом и Мэтью Зейлером. Дело в том, что обученная свёрточная сеть, предназначенная для решения задачи классификации, помимо собственно метки класса, способна предоставить нам некоторую дополнительную информацию. Для каждого пикселя входного изображения можно извлечь соответствующие ему значения функций активации из разных слоёв сети. Эта идея была окончательно оформлена в 2015 г. авторами статьи[2] «Гиперколонки для [задач] сегментации объектов и точной локализации» (Hypercolumns for Object Segmentation and Fine-grained Localization). В этой работе предлагается использовать вектор, составленный из значений функций активации из разных слоёв, соответствующий каждому пикселю, в качестве источника информации для сегментации изображений и выявления местоположения различных объектов. Этот вектор получил название «гиперколонка» [hypercolumn]. По сути, гиперколонка — это набор интенсивностей каждого из признаков, выявляемых сетью для поля свёртки, центром которого является наш пиксель. Более глубокие слои свёрточной сети отвечают, как мы уже говорили ранее, за более абстрактные признаки. Например, автомобильные колёса и фигуры людей распознаются в районе третьего свёрточного слоя. Информация о выявляемых признаках, ассоциированных с каждым пикселем входного изображения, является отличным источником информации о цвете. Модель Даля работала с изображением размером 224 × 224 пикселя, при этом размер гиперколонки, извлекаемой из сети VGG-16, составлял 963 значения. Итоговый «тензор» с размерностью 224 × 224 × 963 подавался на вход отдельной свёрточной сети, выходом которой являлась карта цветов. Эксперименты показали, что такая сеть в большинстве случаев позволяла достичь вполне адекватной раскраски.

Рис. 147. Примеры раскраски изображений (слева направо): чёрно-белое изображение, вариант раскраски от модели Райана Даля, картинка в своих настоящих цветах

Впрочем, ранние модели для нейросетевой раскраски изображений обладали и рядом недостатков. Например, объекты, чей цвет очевидным образом определить было нельзя (например, цвет одежды людей может быть практически каким угодно, как и, например, цвет автомобилей и т. п.), часто приобретали некий среднестатистический «серо-буро-малиновый» цвет, равноудалённый от цветов соответствующих объектов, представленных в обучающей выборке. Возникали и другие дефекты раскраски, что стало мотивацией для дальнейших исследований в этой области.

В 2017 г. свет увидела новая работа[3] Даля, выполненная в соавторстве с его новыми коллегами из Google (в 2016 г. Райан присоединился[4] к Google Brain Residency Program). В работе была представлена модель под названием PixColor, лишённая многих недостатков своей предшественницы. Новый метод был основан на наблюдении, что задача автоматической раскраски достаточно проста для нейронной сети в случае изображений с низким разрешением. Поэтому авторы сначала уменьшали размер картинки, затем при помощи свёрточной нейронной сети производили раскраску полученного уменьшенного изображения, а затем использовали вторую свёрточную сеть для раскраски исходного полноразмерного изображения с использованием цветовой карты, полученной первой сетью для маленькой версии картинки.

Для оценки качества раскраски создатели модели использовали методику, получившую громкое название «визуальный тест Тьюринга» (Visual Turing Test). Суть этого метода заключается в том, что людям-оценщикам предлагают пары изображений, при этом одно из изображений в этой паре обесцвечено, а затем раскрашено при помощи PixColor, а другое сохраняет первоначальные, «естественные» цвета. Оценщик должен выбрать тот вариант раскраски, который он считает более правильным. По итогам теста вычисляется доля случаев, в которых оценщики предпочли раскрашенное изображение. Эту долю авторы назвали VTT‑баллом [VTT score]. В ходе нескольких сессий оценки (с разными инициализациями генератора псевдослучайных чисел) PixColor получила VTT-балл от 33,2 ± 1,0% до 35,4 ± 1,0%, что на несколько процентных баллов выше результатов, продемонстрированных другими методами раскраски.

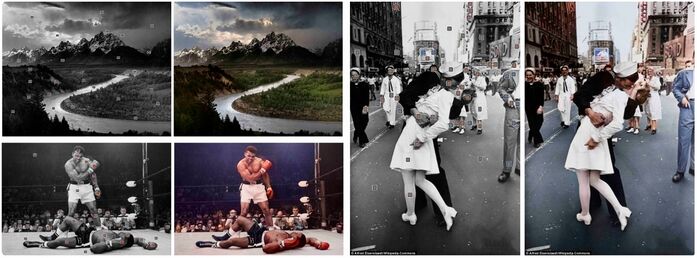

Рис. 148. Пример раскраски изображений (слева направо): обесцвеченное изображение, три варианта раскраски от PixColor, оригинальные цвета

В том же году команда исследователей из Калифорнийского университета в Беркли под руководством профессора Алексея Эфроса представила[5] свою нейросетевую модель для раскраски изображений. В отличие от Даля и его коллег специалисты из Беркли стремились создать систему, способную выполнять раскраску, используя подсказки от людей. При помощи таких подсказок можно было разрешать возникающие при раскраске неопределённости.

Рис. 149. Пример раскраски изображений моделью Алексея Эфроса

В наши дни продолжается быстрое развитие моделей для автоматической и полуавтоматической раскраски изображений. За 2020–2021 гг. только в реестре PapersWithCode появилось 82 статьи, посвящённые этой области (для 38 из них доступен исходный код моделей)[6]. Даже поверхностный обзор этих работ занял бы непростительно много места.

Ну хорошо, допустим, модели глубокого обучения более-менее справились с задачей раскраски изображений. Но способны ли они перейти на новый уровень визуального творчества — скажем, выполнить стилизацию изображения в соответствии с манерой известного художника?

В 2015 г. социальные сети захлестнула волна картинок, на которых привычные предметы превращались в различные части собачьих морд: носы, глаза, лапы. Виной этому стала модель под названием DeepDream, созданная разработчиком из Google Александром Мордвинцевым.

Рис. 150. Пример «собачьих» метаморфоз изображения

в результате работы модели DeepDream

Метаморфозы, которые изображения претерпевали при помощи DeepDream, быстро окрестили «алгоритмической парейдолией». Слово «парейдолия» происходит от древнегреческих слов παρά — рядом, около; отклонение от чего-либо и εἴδωλον — изображение; и означает разновидность зрительных иллюзий, заключающихся в формировании иллюзорных образов на основе деталей реального объекта. Типичный пример парейдолической зрительной иллюзии — восприятие тёмных пятен на видимой поверхности Луны в качестве фигуры зайца или кролика. Считается, что именно эта иллюзия послужила основой для появления в фольклоре разных народов истории о лунном зайце (или кролике). Другой известный пример парейдолии — лицо Марса — образованное причудливой игрой света и тени подобие человеческого лица на ранних фотографиях поверхности Марса.

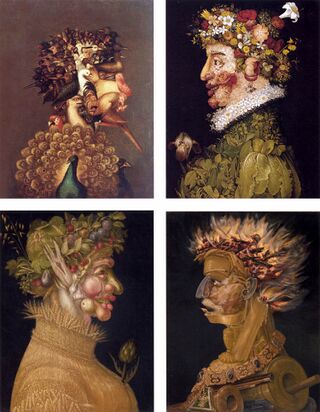

Склонность человека узнавать знакомые образы издревле популярна у художников. Например, миланский художник XVI в. Джузеппе Арчимбольдо создал сразу несколько картин, основанных на этом эффекте («Времена года», «Четыре стихии», «Повар», «Юрист»). На них портреты людей при ближайшем рассмотрении оказываются нагромождением различных предметов, растений и животных.

Рис. 151. Четыре картины Джузеппе Арчимбольдо

В DeepDream после обучения сеть используется в обратном направлении, для коррекции изображения, причём таким образом, чтобы увеличить значение на выходе выбранного выходного нейрона (например, «нейрона собаки», т. е. нейрона выходного слоя сети, соответствующего метке класса «собака»). Эта процедура похожа на метод обратного распространения ошибки, однако корректируются не веса, а значения на входе каждого из нейронов. В результате всё, что в исходном изображении «напоминало» сети собаку, начинает «напоминать» её ещё больше, то есть само изображение как бы увеличивает «степень собачности».

Сама идея подобного использования нейросетевых моделей появилась ещё во времена первых успехов свёрточных нейронных сетей. Так, в 1988 г. на Международной конференции IEEE по нейронным сетям (IEEE 1988 International Conference on Neural Networks) была представлена работа Джона Льюиса под названием «Создание путём переработки: творческая парадигма для нейронных сетей, обучаемых методом градиентного спуска» (Creation By Refinement: A Creativity Paradigm for Gradient Descent Learning Networks)[7]. Статья описывает «парадигму для создания новых экземпляров класса объектов, распознаваемых обученной при помощи метода градиентного спуска ассоциативной сети. Подход состоит из фазы обучения, на которой сеть учится идентифицировать объекты желаемого класса, за которой следует простой алгоритм синтеза, в котором полученное случайным образом „творение“ уточняется путём поиска методом градиентного спуска, дополняющим метод, используемый при обучении».

Удивительно, что в наши дни профессор Льюис известен не как основатель инцепционизма [inceptionism] (так сегодня нередко называют этот подход в искусстве), а как «самый терпеливый человек интернета». Дело в том, что он является владельцем учётной записи @johnlewis в Twitter, и ежегодно сотни пользователей со всего мира по ошибке отправляли ему твиты, предназначенные для сети британских универмагов John Lewis & Partners или члена Палаты представителей США от Джорджии Джона Льюиса. Профессор Льюис с присущими ему юмором и вежливостью перенаправлял отправленные ему сообщения (которых становилось особенно много в канун Рождества), чем заслужил у пользователей соцсети славу самого терпеливого человека в интернете[8], [9], [10]. В 2014 г. сеть универмагов прислала Льюису подарочный набор (игрушечного пингвина Мэйбл и набор для опеки над пингвином от Международного фонда дикой природы) в знак признательности и в качестве извинения за доставленные неудобства[11].

Всё это, конечно, не умаляет достижений исследователей из Google. После того как компания опубликовала подробное описание алгоритма и выложила в открытый доступ исходный код DeepDream, появилось множество инструментов в виде веб-сервисов, мобильных приложений и программ для персональных компьютеров, позволивших широким народным массам производить эксперименты с собственными изображениями.

Многие другие исследовательские группы занялись созданием собственных улучшенных вариантов DeepDream. Некоторые из этих экспериментов были весьма курьёзными. Например, энтузиаст машинного обучения Габриэль Го, ныне сотрудник OpenAI, использовал для генерации алгоритмических галлюцинаций нейронную сеть, созданную группой исследователей из компании Yahoo!, для обнаружения «взрослого» изобразительного контента. В итоге получился генератор довольно криповых порнографических фантазий[12].

Рост интереса к алгоритмической парейдолии подстегнул дальнейшие исследования в этой области. В результате появилось множество улучшений исходного подхода (например, были предложены различные способы регуляризации, позволяющие улучшать те или иные качества итоговых изображений), а также были расширены границы его применения. В частности, развитие получили два важных направления в области генеративных моделей — перенос (художественного) стиля [(Artistic) Style Transfer] и семантическая манипуляция изображениями [Semantic Image Manipulation]. Поговорим сначала о первом из них.

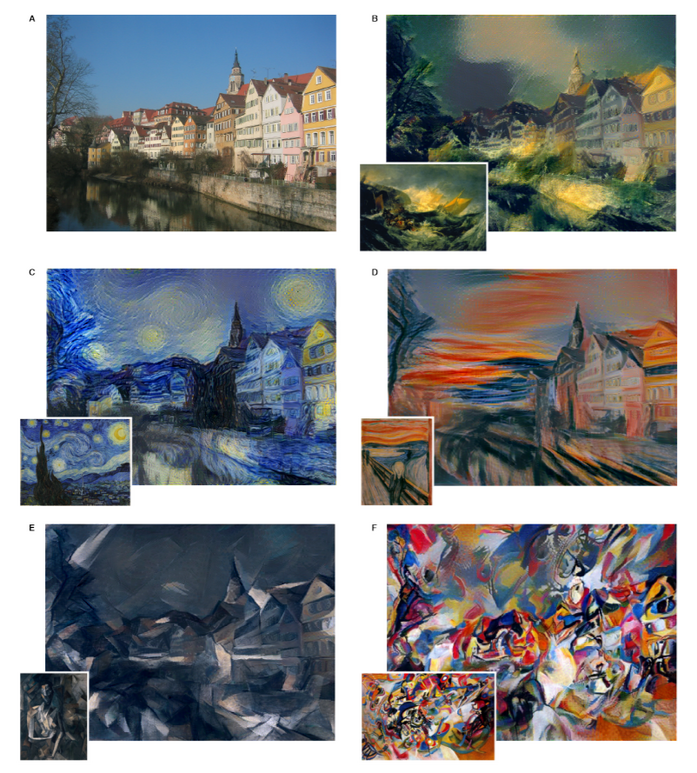

Спустя примерно месяц после публикации материалов по DeepDream на сайте научных препринтов ArXiv.org появилась статья исследователей из Тюбингенского университета (Eberhard Karls Universität Tübingen) Леона Гатиса, Александра Эккера и Маттиаса Бетге под названием «Нейронный алгоритм художественного стиля» (A Neural Algorithm of Artistic Style)[13].

При обучении свёрточных сетей распознаванию объектов они, как уже было отмечено ранее, формируют иерархию признаков распознаваемых объектов, начиная от наиболее простых, конкретных, относящихся к картам признаков, расположенным ближе ко входному слою сети, и заканчивая сложными, абстрактными, распознаваемыми более глубокими слоями. Ключевым выводом статьи исследователей из Тюбингена стало то, что представления содержания и стиля в свёрточной нейронной сети разделимы (по крайней мере отчасти). То есть существует возможность управлять обоими представлениями независимо друг от друга для создания новых изображений, в которых происходит замена оригинальной содержательной или стилевой составляющей на другую (например, позаимствованную из другого изображения). Более того, Гатису и его коллегам удалось создать алгоритм, способный выполнять подобные манипуляции.

Идея данного алгоритма основана на том, что в структуре обученной сети за представление содержания отвечают карты признаков с небольшим разбросом значений для объектов одного и того же класса. Например, почти все изображения кошек будут содержать в себе глаза, усы, лапы и хвост, поэтому карты признаков, выявляющие подобные содержательные признаки, будут обладать сравнительно малой степенью вариации по сравнению с картами, выявляющими, например, текстуру или цвет меха.

Поскольку в большинстве случаев алгоритм не способен полностью разделить содержание и стиль изображения, то при синтезе картинки, которая объединяет содержимое одного изображения со стилем другого, обычно не существует решения, которое идеально соответствует обоим ограничениям. Поэтому авторы предусмотрели возможность регулировки «акцента модели», то есть меры, с которой модель предпочитает передать стиль изображения в ущерб содержанию.

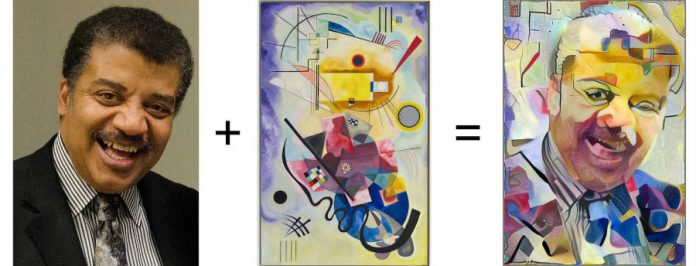

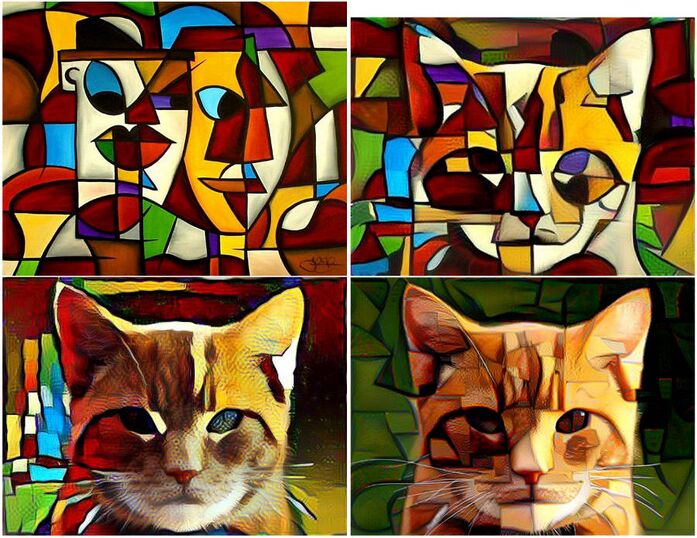

Рис. 152. Перенос художественного стиля моделью Леона Гатиса и его коллег

Поскольку учёные из Тюбингена, как и их коллеги из Google, опубликовали исходный код своей модели, то вскоре появилось множество улучшенных версий исходного метода, а также доступные публике инструменты, позволяющие производить собственные опыты по переносу стиля. Как следствие, в соцсетях и электронных медиа вскоре оказалось большое количество продуктов этих опытов (причём не только для статических изображений, но и для видео).

Рис. 153. Другие примеры переноса художественного стиля

Если при помощи свёрточных сетей можно изменять стиль изображения, то нельзя ли осуществлять более тонкие манипуляции, например подменять отдельные признаки? Разумеется, модели для выполнения подобных действий вскоре появились. Однако, прежде чем говорить о них, давайте зададимся одним интересным вопросом: можно ли считать полноценными творениями, оригинальными произведениями искусства галлюцинации DeepDream или изображения, полученные в результате переноса стиля? Если ответ на этот вопрос будет положительным, то нам придётся признать за машинами наличие у них способности творить. И конечно же, такой вывод является крайне некомфортным для разного рода критиков научно-технического прогресса и тех, кто считает, что успехи вычислительных моделей способны нанести ущерб человеческой гордости. Таких людей мы будем в шутку называть человеческими шовинистами.

Прежде чем рассуждать о возможностях моделей, нужно отметить, что понятие «оригинальность произведения» определено достаточно слабо и в отношении продуктов творчества людей. Является ли оригинальным произведением перерисовка шедевра в ином стиле? Является ли оригинальной работа ученика, подражающего учителю? Вообще в какой мере влияние учителя на творчество ученика делает произведения последнего неоригинальными? Мнение об оригинальности произведения нередко субъективно, и в ряде случаев за ним не стоит даже шаткого общественного консенсуса. Словом, между произведениями, повсеместно признанными оригинальными, и произведениями бесспорно подражательными лежит большая серая зона. Но мы всё же попробуем разобраться в этом вопросе чуть более детально — ведь раз люди нередко рассуждают об оригинальности творчества, то значит, они вкладывают в это понятие некий смысл.

Итак, какого рода возражения могут выдвинуть человеческие шовинисты (и просто скептики) в отношении способности нейронных сетей создавать оригинальные произведения?

Ну, во-первых, можно отметить, что ни DeepDream, ни модель исследователей из Тюбингена не оригинальны. На вход этих моделей подаются готовые изображения. При всей своей кажущейся серьёзности это возражение при более детальном рассмотрении не выглядит особенно основательным. На вход этих моделей можно подать совершенно случайный набор точек. В результате DeepDream сгенерирует случайные галлюцинации, а модель для переноса стиля создаст абстрактную картину в заданном стиле. Кроме того, существуют и более продвинутые методы порождения изображений с нуля, чем просто генерация случайного набора цветных точек. Например, мы уже упоминали автокодировщики. Обучив свёрточный автокодировщик на большом наборе изображений, можно затем подать на вход декодера случайно сгенерированное латентное представление и в результате получить совершенно новое изображение, напоминающее изображения из обучающей выборки (но в общем случае не идентичное ни одному из них).

Во-вторых, можно обвинить нейронные сети в «отсутствии замысла», однако понятие замысла плохо формализуемо. Этот аргумент напоминает знаменитую «китайскую комнату» Сёрля. Откуда мы знаем, что исходные посылки художника к созданию шедевра являются «настоящим» замыслом, а случайно сгенерированное латентное пространство свёрточного автокодировщика «ненастоящим»? Ведь сигналы в естественной нейронной сети тоже могут быть выражены в виде наборов чисел. Кто-то может сказать, что художник опирается на определённый жизненный опыт, социальную практику и наблюдения, но ведь и нейронная сеть в процессе обучения знакомится с человеческой социальной практикой, опосредованной прецедентами обучающей выборки.

Со вторым возражением тесно связано третье — обвинение генеративных моделей в подражательности. По всей видимости, это мнение сформировалось под влиянием сообщений в прессе об успехах машин в деле генерации изображений и текстов, стилизованных под произведения различных известных авторов. Конечно, создание собственного узнаваемого стиля — важная творческая задача, своего рода метатворчество, но вряд ли у человека есть в решении этой задачи какие-то радикальные преимущества перед машиной. На самом деле при создании стиля художники и литераторы всё равно опираются на свои знания и опыт, то есть новый стиль — это также комбинация «пройденного», просто комбинируются более глубинные признаки. Обычно генеративные модели, способные создавать произведения, стилизованные под разных авторов, выучивают для каждого из авторов и/или каждого из произведений некоторые стилистические векторы. Например, в работах авторов «Нейронной обороны» это эмбеддинги текстов и их авторов; в моделях, основанных на вариационных автокодировщиках, — соответствующие латентные векторы. Стилистические векторы составляют «пространство стилей», и задача создания нового стиля технически представляет собой выбор некоторой точки в этом пространстве. Творческий путь автора представляет собой траекторию, которую проходят в «пространстве стилей» его произведения с течением времени. Я думаю, что в ближайшем будущем мы увидим немало исследований, посвящённых влиянию на индивидуальный стиль различных событий в жизни авторов. Создание машиной нового творческого стиля — задача очень простая, если единственным требованием к этому стилю является его новизна. С этой задачей вполне справится генератор псевдослучайных чисел, выбирающий случайную точку в стилистическом пространстве. На деле проблема заключается не столько в новизне, сколько в связи этого стиля с социальной действительностью. Именно эта связь делает тот или иной стиль востребованным в обществе. Поэтому генеративным моделям скорее нужна не новая степень новизны, а новая степень «социализации». Но и в этой задаче, по-моему, нет ничего принципиально неразрешимого — современные системы машинного обучения в некоторой степени уже «социальны», поскольку социальная практика находит отражение в прецедентах, включаемых в обучающие выборки.

Но вернёмся к вопросу о качестве результатов работы моделей.

По всей видимости, единственной более-менее адекватной оценкой творчества машины является уже упоминавшийся нами визуальный тест Тьюринга: можно попросить людей оценивать компьютерные творения в слепом тесте, в котором они будут сравниваться с признанными шедеврами или фотореалистичными изображениями.

Конечно, существуют и способы автоматизированной оценки качества сгенерированных изображений. Например, весьма популярна «оценка на базе Inception» [Inception score][14], основанная на оценке энтропии распределения значений в выходном слое сети Inception, когда на её вход подаётся сгенерированное изображение. Авторы этой метрики сообщают в своей работе, что оценка на базе Inception сильно коррелирует с оценкой качества изображений людьми, хотя и не приводят ни численной оценки этой корреляции, ни данных об экспериментальной проверке этого заявления. Потенциальная проблема Inception score заключается в том, что при желании генеративная модель может быть обучена таким образом, чтобы целенаправленно максимизировать подобную оценку, при этом качество изображений с точки зрения людей может и не расти. Мы подробнее расскажем об этой проблеме в разделе, посвящённом актуальным проблемам глубокого обучения.

- ↑ Dahl R. (2016). Automatic Colorization // https://tinyclouds.org/colorize/

- ↑ Hariharan B., Arbeláez P., Girshick R., Malik J. (2015). Hypercolumns for Object Segmentation and Fine-grained Localization // https://arxiv.org/abs/1411.5752

- ↑ Guadarrama S., Dahl R., Bieber D., Norouzi M., Shlens J., Murphy K. (2017). PixColor: Pixel recursive colorization // https://arxiv.org/abs/1705.07208

- ↑ Dahl R. (2016). Google Brain Residency // https://tinyclouds.org/residency/

- ↑ Zhang R., Zhu J.-Y., Isola P., Geng X., Lin A. S., Yu T., Efros A. A. (2017). Real-Time User-Guided Image Colorization with Learned Deep Priors // https://arxiv.org/abs/1705.02999

- ↑ Colorization (2022) // https://paperswithcode.com/task/colorization/latest, https://paperswithcode.com/task/colorization/codeless#code

- ↑ Lewis J. P. (1988). Creation By Refinement: A Creativity Paradigm for Gradient Descent Learning Networks / IEEE International Conference on Neural Networks // https://doi.org/10.1109/icnn.1988.23933

- ↑ Alice P. (2013). John Lewis, the most patient man on the internet / Daily Telegraph, 11 Nov 2013 // https://www.telegraph.co.uk/news/uknews/10440185/John-Lewis-the-most-patient-man-on-the-internet.html

- ↑ White A. (2015). The Worst Time Of Year For The Most Patient And Polite Man On The Internet Has Begun. We should probably honour him with a statue or something / BuzzFeed, Nov 6, 2015 // https://www.buzzfeed.com/alanwhite/whats-the-definition-of-madness-again

- ↑ Sanusi V. (2016). The Most Patient And Polite Man On The Internet Is Back At It Again / BuzzFeed, Nov 10, 2016 // https://www.buzzfeed.com/victoriasanusi/its-the-worst-time-of-year-for-the-most-patient-and-polite-m

- ↑ Massey N. (2014). Man called John Lewis sent Christmas advert penguin after being bombarded with tweets directed at store / Mirror, 20 Nov 2014 // https://www.mirror.co.uk/news/uk-news/man-called-john-lewis-sent-4658776

- ↑ Vincent J. (2016). This AI program sees genitals everywhere it looks. Do androids dream of electric dicks? / The Verge, Oct 24, 2016 // https://www.theverge.com/2016/10/24/13379208/ai-nsfw-neural-nets-deep-dream-genitals

- ↑ Gatys L. A., Ecker A. S., Bethge M. (2015). A Neural Algorithm of Artistic Style // https://arxiv.org/abs/1508.06576

- ↑ Salimans T., Goodfellow I., Zaremba W., Cheung V., Radford A., Chen X. (2016). Improved Techniques for Training GANs // https://arxiv.org/abs/1606.03498