6.6.8 Машина как художник. Генеративно-состязательные сети и ганизм

На деле «творческие способности» генеративных моделей в начале 2010-х гг. были по большей мере весьма скромными. Сгенерированное порно скорее пугало, а не возбуждало, сгенерированные «фотореалистичные» лица напоминали не шедевры, а неудачные попытки их реставрации и, казалось, молили: «Убей меня!» Радикально решить эти проблемы удалось лишь во второй половине 2010-х гг., при этом существенный прогресс наметился в 2014 г. с выходом на сцену генеративно-состязательных сетей (Generative Adversarial Networks, GAN). При этом даже появился термин «ганизм» [GANism, или просто ganism] — направление в искусстве, основанное на применении генеративно-состязательных сетей.

Что нужно человеку-художнику для развития мастерства? Часто нужен кто-то, кто критически оценит очередной образец творчества, подскажет направление дальнейшего совершенствования навыка. Конечно, для развития алгоритмического художника можно было бы привлечь критиков-людей, однако это медленно и дорого. А нельзя ли роль критика поручить другой нейронной сети? Сеть-генератор будет учиться генерировать изображения, а сеть-критик (её называют «дискриминатор») будет учиться отличать созданные изображения от настоящих. В ходе этого соревнования сеть-генератор в конце концов может научиться создавать изображения, которые критик не сможет отличить от реальных или по крайней мере будет отличать не слишком уверенно. Именно эта состязательная парадигма легла в основу нового поколения генеративных моделей.

Детальное описание этой концепции, а также сам термин «генеративно-состязательные сети» появились впервые в знаменитой одноимённой работе[1] Яна Гудфеллоу и его соавторов, в числе которых был и уже знакомый нам Йошуа Бенджио.

Гудфеллоу получил степени бакалавра и магистра в Стэнфордском университете под руководством Эндрю Ына, а затем защитил диссертацию в Монреальском университете под руководством Бенджио и Аарона Курвилля. После защиты Гудфеллоу присоединился к команде GoogleBrain, затем покинул Google, чтобы присоединиться к недавно основанной OpenAI, а затем вновь вернулся в Google в марте 2017 г. Перу Гудфеллоу, Бенджио и Курвилля принадлежит одна из наиболее популярных книг о методах глубокого обучения. В 2017 г. Гудфеллоу был упомянут в рейтинге MIT Technology Review «35 новаторов моложе 35 лет», а в 2019-м — включён в список «100 глобальных мыслителей» по версии Foreign Policy. В том же году он покинул Google, чтобы занять пост директора по машинному обучению Группы специальных проектов в компании Apple.

Интересно, что идея использовать нейронную сеть в роли художественного критика нашла воплощение не только в концепции генеративно-состязательных сетей, но и при решении других задач, связанных с изобразительным искусством. Например, нейросетевые модели регулярно применяют для определения авторства художественных произведений. Совсем недавно нейронные сети помогли разрешить вопрос о создателе приписываемой Рубенсу картины «Самсон и Далила» (спойлер: картина предположительно является подделкой)[2].

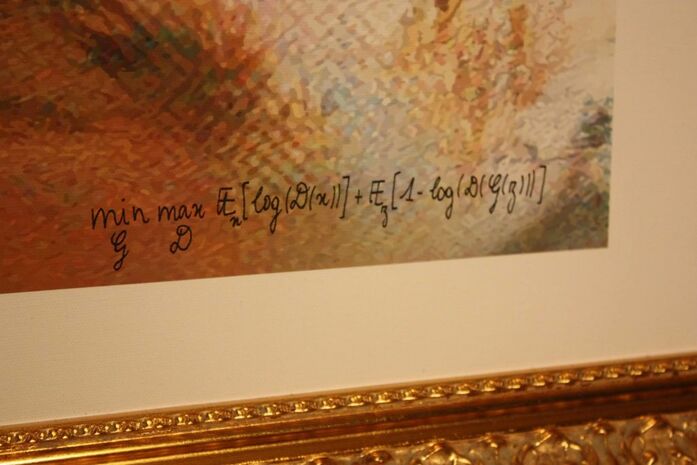

В феврале 2018 г. французский коллекционер живописи Николя Лагро-Лассер, известный большой коллекцией городского искусства (Shepard Fairey, Ivader, Banksy, Swoon), приобрёл на аукционе Sotheby’s картину под названием «Граф Белами» (Le Comte de Belamy), созданную моделью на основе генеративно-состязательных сетей. В самом названии картины кроется «пасхальное яйцо» — фамилия Belamy является дословным переводом на французский фамилии Goodfellow. В качестве подписи художника на картине красуется математическая формулировка генеративно-состязательного подхода.

Рис. 154. Созданная нейросетью картина «Граф Белами»

с формулой вместо подписи художника

Впрочем, идеи, напоминающие парадигму GAN’ов, высказывались и ранее. Ещё в 1992 г. свет увидела статья изобретателя LSTM Юргена Шмидхубера под названием «Обучение факториальным кодам путём минимизации предсказуемости» (Learning Factorial Codes by Predictability Minimization)[3]. В ней процесс обучения был также основан на двух противоборствующих действиях: шаги градиентного спуска, направленные на снижение уровня ошибок, чередовались с шагами, направленными на снижение предсказуемости. В 2010 г. финский исследователь Олли Ниемитало предложил в своём блоге метод, практически идентичный GAN’ам, однако эта идея не получила у него дальнейшего развития. Гудфеллоу и его коллеги, судя по всему, не были в курсе этих ранних работ. Открыв генеративно-состязательную парадигму независимо от своих предшественников, они продвинулись дальше, разработав теоретическую основу метода, осуществив серию экспериментов, показавших жизнеспособность GAN’ов, а также поделившись с сообществом исходным кодом модели.

Поскольку GAN’ы по своей сути были не просто моделью, а целой новой парадигмой в создании генеративных моделей, их появление вызвало к жизни множество интересных вопросов, различные ответы на которые привели к появлению множества различных воплощений изначальной идеи. Какие архитектуры должны быть у генератора и дискриминатора? Как должны соотноситься сложности этих моделей? Какое количество шагов обучения дискриминатора должно чередоваться с каким числом шагов обучения генератора? Какие целевые функции при обучении обеспечивают наилучший результат? Какие способы регуляризации этих моделей должны использоваться? Как должна меняться скорость обучения со временем? Какие факторы влияют на сходимость системы, не войдёт ли ошибка при обучении в колебательный тренд без тенденции к снижению? Многие из этих вопросов активно исследуются и в наши дни, и каждые несколько месяцев появляются новые разновидности GAN’ов для решения тех или иных специфических задач генерации изображений, звуков и даже текстов.

Давайте посмотрим на успехи нескольких популярных версий GAN.

В ноябре 2014 г. на ArXiv появилась работа Мехди Мирзы и Саймона Осиндеро «Обусловленные генеративно-состязательные сети» (Conditional Generative Adversarial Nets)[4]. На момент публикации Мирза работал над диссертацией в Монреальском университете под руководством Бенджио и Курвилля, а бывший постдок Хинтона Осиндеро руководил исследованиями и разработкой в области компьютерного зрения в компании Flickr (на тот момент принадлежавшей Yahoo!). Идея модели, изобретённой Мирзой и Осиндеро (сегодня её кратко называют CGAN — от ConditionalGAN), довольно проста и эффективна. На вход генератора, помимо шума, подаётся некоторая обусловливающая информация (например, метка класса изображения, которое следует сгенерировать, в виде one-hot-вектора). Этой же обусловливающей информацией дополняется вход дискриминатора. Авторы специально подчёркивают, что эта информация может быть не только меткой класса, но и любыми другими данными, обусловливающими результирующее изображение. Более того, CGAN можно использовать для генерации не только изображений. В частности, авторы показывают, как эта модель успешно справляется с задачей автоматической генерации тегов для картинок, загруженных на Flickr, при этом сами теги представлены в виде классических векторов признаков, построенных при помощи алгоритма Skip-gram.

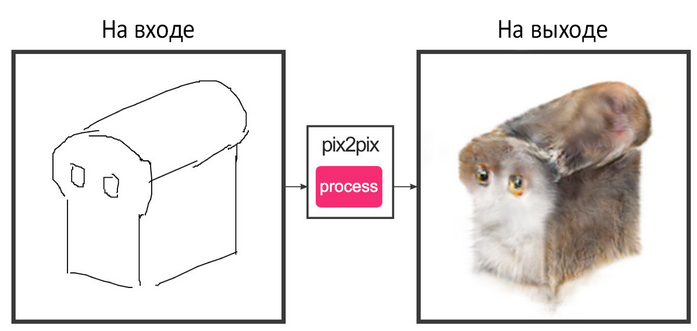

Идея обусловливания GAN’ов получила дальнейшее развитие в ряде других исследований. Например, в конце 2016 г. в работе «Трансляция изображений в изображения при помощи обусловленных состязательных сетей» (Image-to-Image Translation with Conditional Adversarial Networks)[5] была представлена популярная и в наши дни модель pix2pix. В этой модели в качестве обусловливающей информации при генерации изображения выступает другое изображение. Список задач, которые могут быть решены при помощи pix2pix, весьма обширен. Например, в задаче раскраски чёрно-белое изображение транслируется в цветное (т. е. в данном случае чёрно-белое изображение является обусловливающим изображением при генерации цветного). Таким путём спутниковые снимки могут превращаться в карты, дневные фотоснимки — в ночные (и наоборот), фотографии людей — в их же фотографии с удалённым фоном, наброски картинок, сделанные на скорую руку в редакторе типа Paint, — в законченные фотореалистичные изображения.

Для обучения pix2pix необходимы датасеты, состоящие из пар изображений (обусловливающего и результирующего). Для многих задач возможны простые преобразования, позволяющие выполнять обратную операцию: получать обусловливающее изображение из результирующего. Такие преобразования обычно связаны с потерей некоторой части информации, например с обесцвечиванием, выделением контуров (путём простых алгоритмов трассировки или же при помощи моделей, выполняющих семантическую сегментацию — выделение на изображении контуров различных объектов). Используя эти преобразования, можно создавать большие синтетические датасеты.

Рис. 155. Примеры разнообразных трансляций изображений в изображения моделью pix2pix

Обученная на некотором классе изображений pix2pix иногда ведёт себя довольно забавно, если на её вход подать «неожиданное» для неё обусловливающее изображение. Например, контуры объекта, который совсем не похож на объекты, содержавшиеся в обучающей выборке (один из примеров был приведён в конце раздела 1.3.2, а другой вы можете наблюдать ниже — это изображение стало локальным мемом сообщества разработчиков генеративных моделей).

Рис. 156. «Котобуханка» от модели pix2pix

В начале 2017 г. на суд общественности была представлена статья «Непарное преобразование изображения в изображение с использованием согласованных по циклу состязательных сетей» (Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks)[6], давшая начало архитектуре, получившей название CycleGAN. Авторами работы, как и в случае с pix2pix, была команда уже знакомого нам Алексея Эфроса, в которую, помимо самого профессора, вошли его ученики — Цзюнь-Янь Чжу, Тхэсон Пак и Филипп Исола.

CycleGAN — это генеративно-состязательная сеть, использующая два генератора и два дискриминатора. Изображения, с которыми работает CycleGAN, разделены на две группы (для обозначения групп прецедентов, объединённых какими-либо общими признаками, в машинном обучении часто используют термин «домен») — X (например, изображения лошадей) и Y (например, изображения зебр). Первый генератор (G) учится преобразовывать X в Y, а второй (F), напротив, из Y в X. Каждой из групп также сопоставлен соответствующий дискриминатор: DX учится отличать оригинальное изображение из группы X от изображения, порождённого генератором F, аналогично дискриминатор DY учится отличать оригинальное изображение из группы Y от изображения, порождённого генератором G. Изюминкой модели является целевая функция модели (в нейросетевых моделях часто используют термин «функция потерь» [loss function] для того, чтобы подчеркнуть, что для данной функции решается задача минимизации, т. е. снижения потерь). Помимо классической для GAN’ов состязательной компоненты (на этапе обучения дискриминатора это ошибка дискриминатора в различении сгенерированных изображений и настоящих, а на этапе генератора — эта же ошибка, взятая с противоположным знаком), к ней прибавляется (умноженная на некоторый масштабный коэффициент) ошибка согласованности цикла, то есть отличие изображения от себя самого, прошедшего через двойное преобразование при помощи генераторов (т. е. изображение из X сначала преобразуется генератором G, а затем результат этого преобразования преобразуется генератором F, т. е. мы пытаемся превратить лошадь в зебру, а затем полученную зебру превратить снова в лошадь; аналогичную операцию мы проводим с зебрами — пытаемся сделать их лошадьми, а потом полученных лошадей пытаемся превратить обратно в зебр). Если генераторы идеальны, то после такого двойного преобразования изображение превратится само в себя. При помощи обученной CycleGAN можно будет превращать лошадей на картинках в зебр и наоборот — это является простым примером семантической манипуляции изображением.

Рис. 157. Пример превращения лошадей в зебр и наоборот моделью CycleGAN

Когда говорят о семантической манипуляции, то обычно имеют в виду, что каждому изображению сопоставлены одна или несколько семантических меток: например, фотографии человека сопоставлены метки возраста, пола, цвета кожи, типа причёски, наличия бороды и так далее. Алгоритм семантической манипуляции позволяет сгенерировать изображение, соответствующее исходному, но с другим значением семантических меток. Например, изменив признак наличия бороды для моей фотографии, можно взглянуть на то, как я мог бы выглядеть без бороды.

CycleGAN использовала некоторые решения, предложенные в более ранних исследованиях по GAN’ам. Например, вслед за авторами статьи 2016 г. «Обучение на основе симулированных и неразмеченных изображений при помощи состязательного подхода» (Learning from Simulated and Unsupervised Images through Adversarial Training)[7] для исключения сильных колебаний при обучении модели создатели CycleGAN передавали в дискриминаторы не одно, а 50 последних сгенерированных изображений. Архитектура самих дискриминаторов была позаимствована у более ранней архитектуры[8], созданной командой Эфроса, под названием PatchGAN.

Спустя несколько месяцев после появления CycleGAN была опубликована другая популярная в наши дни архитектура — StarGAN. Статья, в которой она была описана, так и называлась «StarGAN: унифицированные генеративно-состязательные сети для мультидоменного преобразования изображения в изображение» (StarGAN: Unified Generative Adversarial Networks for Multi-Domain Image-to-Image Translation)[9].

Создателями новой архитектуры стали Юньдзей Чхве и его коллеги из Университета Корё (고려대학교) в Сеуле и исследовательского центра компании Clova AI (NAVER Clova AI Research). StarGAN стала ответом исследователей на проблему преобразования изображений в случае наличия множества доменов. В примере с лошадьми и зебрами из работы авторов CycleGAN необходимо использование двух генераторов. Однако если мы добавим к лошадям и зебрам, допустим, пони, единорогов и жирафов, то нам потребуется уже целых 5 × 4 = 20 генераторов (из каждого домена мы должны уметь преобразовывать изображение во все домены, кроме исходного). При 10 доменах это будет уже 10 × 9 = 90 генераторов и так далее. Быстрый рост числа необходимых генераторов с увеличением числа доменов ведёт к пропорциональному росту вычислительных затрат на обучение модели. Чтобы решить эту проблему, создатели StarGAN предложили возложить на дискриминатор StarGAN сразу две задачи классификации. Первая из них — это обычная для дискриминаторов оценка степени правдоподобия того факта, что изображение, поданное на вход дискриминатора, является сгенерированным. Вторая задача — определение домена, к которому относится изображение. Генератор в StarGAN получает на вход, помимо исходного изображения, указание на целевой домен (кого мы хотим получить в результате: лошадь, зебру, жирафа и т. п.?). При этом, так же как и в CycleGAN, оценивается качество обратного преобразования (для этого генератор получает на вход сгенерированное изображение и указание на оригинальный домен изображения как на целевой).

Модели, подобные StarGAN и CycleGAN, лежат в основе популярных в наши дни фильтров для семантической манипуляции фотографиями, позволяющих превратить безбородого человека в бородача (и наоборот), юношу в старика (и наоборот) и тому подобное.

Рис. 158. Примеры семантической манипуляции фотографиями людей при помощи модели CycleGAN

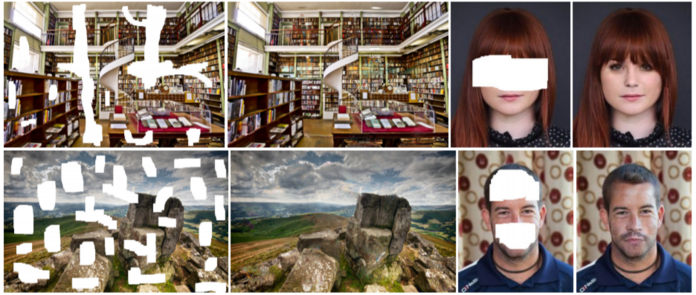

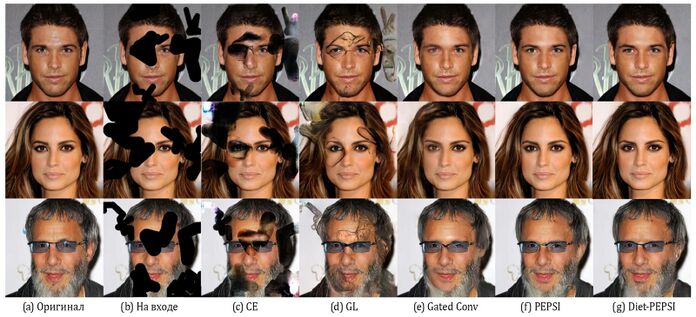

Модель на базе GAN, предложенная[10] в 2017 г. исследователями из японского Университета Васэда (早稲田大学), использует в качестве обусловливающего изображения для генератора изображение с закрашенными фрагментами. Благодаря применению GAN исследователям удалось добиться локальной и глобальной согласованности при заполнении недостающих частей картинки.

Рис. 159. Пример восстановления закрашенных или несуществовавших фрагментов изображения при помощи модели исследователей из Университета Васэда

Ту же задачу успешно решают более современные модели (2019 г.), такие как PEPSI[11] и PEPSI++ (Diet-PEPSI)[12].

Рис. 160. Пример восстановления закрашенных или несуществовавших фрагментов изображения при помощи модели PEPSI

Используя модель PEPSI, энтузиасты быстро соорудили инструмент[13] под названием DeepCreamPy, предназначенный для удаления цензуры с изображений, относящихся к жанру хентай (жанр японских комиксов и анимации, отличающийся наличием элементов эротики и/или порнографии).

Различных моделей GAN и их модификаций в наши дни создано превеликое множество: DCGAN[14], InfoGAN[15], DiscoGAN[16], ProGAN[17], WGAN[18], ImprovedWGAN[19], StyleGAN[20], StyleGAN2[21], StyleGAN3[22], StarGAN v2[23] и так далее.

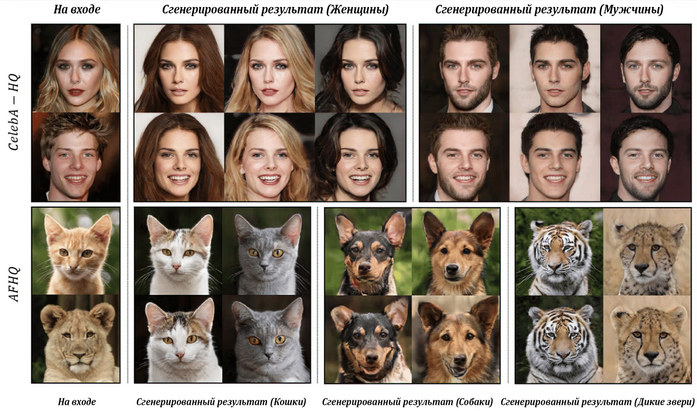

Вот пример работы модели (StarGAN v2) для трансляции изображений между доменами:

Рис. 161. Пример трансляции изображений между доменами (модель StarGAN v2)

А вот фотографии несуществующих людей, созданные при помощи модели StyleGAN2 от компании Nvidia:

Рис. 162. Фотографии несуществующих людей (модель StyleGAN2)

В 2022 г. исследователи из Google Research продемонстрировали[24], как при помощи специальной техники, получившей название «самодистилляция» [self-distillation], можно обучать StyleGAN на неразмеченных изображениях, собранных в интернете. При этом модель успешно генерирует картинки высокого качества во многих доменах (в работе приводятся примеры генерации изображений львов, жирафов, слонов, попугаев и т. д.).

На сайте thisxdoesnotexist.com можно найти коллекцию GAN’ов для генерации изображений самых разных объектов: человеческих лиц, котиков, интерьеров, посуды, еды и даже несуществующих членов британского парламента.

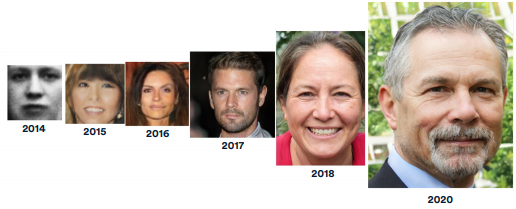

Ниже приведено изображение из стэнфордского ежегодного доклада Artificial Intelligence Index Report за 2021 г. (AIIR-2021)[25], которое наглядно показывает прогресс в области генерации лиц.

Рис. 163. Прогресс в области генерации лиц

Тема генеративно-состязательных моделей заслуживает, бесспорно, отдельной книги. Но создание такой книги является довольно непростой задачей, поскольку новые архитектуры появляются так быстро, что автору книги будет непросто поспевать за исследователями.

В последнее время появляются модели, работающие более чем с двумя модальностями. Например, модель VATT (Video-Audio-Text Transformer, Видеоаудиотекстовый трансформер), созданная совместными усилиями исследователей Google, Корнеллского и Колумбийского университетов[26], а также модель data2vec от Meta (бывшей Facebook)[27], помимо текста и изображений, умеют оперировать со звуковыми данными.

Исследователи из DeepMind развивают технологию, получившую название ReLIC (Representation Learning via Invariant Causal Mechanisms, Обучение представлениям через инвариантные причинные механизмы), позволяющую обучать большие свёрточные сети с архитектурной ResNet в режиме самообучения [self-supervised learning], чтобы затем использовать выученные ими представления в решении самых разных задач, в которых востребовано компьютерное зрение, — от классификации картинок до создания систем искусственного интеллекта для аркадных игр[28], [29].

Несмотря на популярность генеративно-состязательного подхода при создании изображений, он обладает и некоторыми недостатками. Из-за сложных нелинейных эффектов, которые возникают при совместном обучении двух моделей, процесс обучения может растягиваться на длительное время или вовсе не приводить к желаемому результату. Часто бывает сложно найти обеспечивающее успех обучения соотношение архитектур моделей, структур функций потерь и различных гиперпараметров, что делает эксперименты в области генеративно-состязательных систем вычислительно затратными и довольно плохо предсказуемыми. Поэтому параллельно с генеративно-состязательной парадигмой развиваются и альтернативные подходы, например авторегрессионные модели[30]. Наверное, самыми известными моделями такого рода в середине 2010-х гг. стали PixelRNN[31] и PixelCNN[32]. Эти модели в явном виде эксплуатируют зависимости между пикселями изображения, пытаясь предсказать очередной пиксель, опираясь на уже сгенерированные. При этом PixelRNN — это рекуррентная архитектура на базе LSTM, которая рассматривает изображения в качестве последовательностей пикселей, а PixelCNN — свёрточная архитектура, получающая на вход уже сгенерированную часть картинки. Дополнительно на вход сети можно подавать различного рода обусловливающие векторы, например содержащие информацию о классе генерируемого объекта или о наборе его признаков. Этот набор признаков можно получить в результате подачи эталонной картинки на вход свёрточной нейронной сети, обученной решению задачи классификации. В таком случае при помощи генеративной модели можно создавать альтернативные изображения объекта на эталонной картинке.

Вскоре после появления оригинальной PixelCNN (и предложенной в оригинальной работе её модифицированной версии — Gated PixelCNN) был создан и её усовершенствованный вариант — PixelCNN++[33]. Сама по себе идея авторегрессионного моделирования многомерных дискретных данных при помощи глубоких нейронных сетей появилась задолго до PixelRNN и PixelCNN, но популярность в области генерации изображений она обрела только в середине 2010-х гг., под влиянием возросшего интереса к этой области.

Авторегрессионные модели можно рассматривать в качестве декодеров, роль латентного пространства в которых выполняет обусловливающий вектор.

Ещё одной альтернативой генеративно-состязательным сетям являются так называемые диффузионные модели [Diffusion Model], создатели которых черпали своё вдохновение в неравновесной термодинамике. Обычно диффузионные модели учатся выполнять шаги, восстанавливающие изображение по его зашумлённой версии, для чего в обучающую выборку включаются пары картинок, в которых одна картинка была создана из другой путём диффузии, то есть добавления шума. Научившись обращать процесс диффузии вспять, модель затем может быть использована для того, чтобы в ходе цепочки последовательных шагов создавать картинки вообще из случайного шума. В качестве примеров диффузионных моделей можно назвать «Диффузионные вероятностные модели» [Diffusion probabilistic models][34] и «Диффузионные вероятностные модели, устраняющие шум» [Denoising diffusion probabilistic models][35], [36]. Исследования последних лет демонстрируют способность диффузионных моделей превзойти генеративно-состязательные сети в качестве генерации изображений[37], но сам процесс синтеза у диффузионных моделей вычислительно более затратен, так как требует выполнения большого количества шагов.

В принципе, в рамках GAN роль генератора вполне может выполнять авторегрессионная или даже диффузионная модель, однако в реальных генеративно-состязательных сетях в качестве генераторов обычно используются относительно легковесные модели (например, развёрточные [deconvolutional] сети, а в последнее время даже и трансформеры[38]), в противном случае и без того затратный и плохо предсказуемый процесс обучения GAN грозит стать непомерно дорогим и рискованным. Если же исключить из обучения состязательную часть, то можно позволить себе использование более сложной модели, в том числе такой, которая будет генерировать изображение при помощи многошагового процесса. Выбор конкретного подхода, как всегда, зависит во многом от специфики задачи — требований к скорости генерации и к её качеству, объёма обучающей выборки, наличия и типа разметки и так далее.

- ↑ Goodfellow I. J., Pouget-Abadie J., Mirza M., Xu B., Warde-Farley D., Ozair S., Courville A., Bengio Y. (2014). GenerativeAdversarialNetworks // https://arxiv.org/abs/1406.2661

- ↑ Alberge D. (2021). Was famed Samson and Delilah really painted by Rubens? No, says AI / The Guardian, 26 Sep 2021 // https://www.theguardian.com/artanddesign/2021/sep/26/was-famed-samson-and-delilah-really-painted-by-rubens-no-says-ai

- ↑ Schmidhuber J. (1992). Learning factorial codes by predictability minimization / Neural Computation, Vol. 4 (6), pp. 863—879 // https://doi.org/10.1162/neco.1992.4.6.863

- ↑ Mirza M., Osindero S. (2014). Conditional Generative Adversarial Nets // https://arxiv.org/abs/1411.1784

- ↑ Isola P., Zhu J.-Y., Zhou T., Efros A. A. (2016). Image-to-Image Translation with Conditional Adversarial Networks // https://arxiv.org/abs/1611.07004

- ↑ Zhu J.-Y., Park T., Isola P., Efros A. A. (2017). Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks // https://arxiv.org/abs/1703.10593

- ↑ Shrivastava A., Pfister T., Tuzel O., Susskind J., Wang W., Webb R. (2016). Learning from Simulated and Unsupervised Images through Adversarial Training // https://arxiv.org/abs/1612.07828

- ↑ Isola P., Zhu J.-Y., Zhou T., Efros A. A. (2016). Image-to-Image Translation with Conditional Adversarial Networks // https://arxiv.org/abs/1611.07004

- ↑ Choi Y., Choi M., Kim M., Ha J.-W., Kim S., Choo J. (2017). StarGAN: Unified Generative Adversarial Networks for Multi-Domain Image-to-Image Translation // https://arxiv.org/abs/1711.09020

- ↑ Iizuka S., Simo-Serra E., Ishikawa H. (2017). Globally and Locally Consistent Image Completion / ACM Transactions on Graphics, Vol. 36, Iss. 4, Article 107, July 2017 // http://dx.doi.org/10.1145/3072959.3073659

- ↑ Sagong M.-C., Shin Y.-G., Kim S.-W., Park S., Ko S.-J. (2019). PEPSI: Fast Image Inpainting With Parallel Decoding Network / 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) // https://doi.org/10.1109/CVPR.2019.01162

- ↑ Shin Y.-G., Sagong M.-C., Yeo Y.-J., Kim S.-W., Ko S.-J. (2019). PEPSI++: Fast and Lightweight Network for Image Inpainting // https://arxiv.org/abs/1905.09010

- ↑ DeepCreamPy: Decensoring Hentai with Deep Neural Networks // https://github.com/deeppomf/DeepCreamPy

- ↑ Radford A., Metz L., Chintala S. (2015). Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks // https://arxiv.org/abs/1511.06434

- ↑ Chen X., Duan Y., Houthooft R., Schulman J., Sutskever I., Abbeel P. (2016). InfoGAN: Interpretable Representation Learning by Information Maximizing Generative Adversarial Nets // https://arxiv.org/abs/1606.03657

- ↑ Kim T., Cha M., Kim H., Lee J. K., Kim J. (2017). Learning to Discover Cross-Domain Relations with Generative Adversarial Networks // https://arxiv.org/abs/1703.05192

- ↑ Karras T., Aila T., Laine S., Lehtinen J. (2017). Progressive Growing of GANs for Improved Quality, Stability, and Variation // https://arxiv.org/abs/1710.10196

- ↑ Arjovsky M., Chintala S., Bottou L. (2017). Wasserstein GAN // https://arxiv.org/abs/1701.07875

- ↑ Gulrajani I., Ahmed F., Arjovsky M., Dumoulin V., Courville A. (2017). Improved Training of Wasserstein GANs // https://arxiv.org/abs/1704.00028

- ↑ Karras T., Laine S., Aila T. (2018). A Style-Based Generator Architecture for Generative Adversarial Networks // https://arxiv.org/abs/1812.04948

- ↑ Karras T., Laine S., Aittala M., Hellsten J., Lehtinen J., Aila T. (2019). Analyzing and Improving the Image Quality of StyleGAN // https://arxiv.org/abs/1912.04958

- ↑ Karras T., Aittala M., Laine S., Härkönen E., Hellsten J., Lehtinen J., Aila T. (2021). Alias-Free Generative Adversarial Networks // https://arxiv.org/abs/2106.12423

- ↑ Choi Y., Uh Y., Yoo J., Ha J.-W. (2019). StarGAN v2: Diverse Image Synthesis for Multiple Domains // https://arxiv.org/abs/1912.01865

- ↑ Mokady R., Yarom M., Tov O., Lang O., Cohen-Or D., Dekel T., Irani M., Mosseri I. (2022). Self-Distilled StyleGAN: Towards Generation from Internet Photos // https://arxiv.org/abs/2202.12211

- ↑ Stanford Human-Centered Artificial Intelligence (HAI) (2021). Artificial Intelligence Index Report 2021 // https://aiindex.stanford.edu/wp-content/uploads/2021/03/2021-AI-Index-Report_Master.pdf

- ↑ Akbari H., Yuan L., Qian R., Chuang W.-H., Chang S.-F., Cui Y., Gong B. (2021). VATT: Transformers for Multimodal Self-Supervised Learning from Raw Video, Audio and Text // https://arxiv.org/abs/2104.11178

- ↑ Baevski A., Hsu W.-N., Xu Q., Babu A., Gu J., Auli M. (2022). The first high-performance self-supervised algorithm that works for speech, vision, and text / Meta AI, January 20, 2022

- ↑ Mitrovic J., McWilliams B., Walker J., Buesing L., Blundell C. (2020). Representation Learning via Invariant Causal Mechanisms // https://arxiv.org/abs/2010.07922

- ↑ Tomasev N., Bica I., McWilliams B., Buesing L., Pascanu R., Blundell C., Mitrovic J. (2022). Pushing the limits of self-supervised ResNets: Can we outperform supervised learning without labels on ImageNet? // https://arxiv.org/abs/2201.05119

- ↑ * В машинном обучении авторегрессионными обычно называют модели для предсказания следующего элемента последовательности на основе предыдущих её элементов.

- ↑ van den Oord A., Kalchbrenner N., Kavukcuoglu K. (2016). Pixel Recurrent Neural Networks // https://arxiv.org/abs/1601.06759

- ↑ van den Oord A., Kalchbrenner N., Vinyals O., Espeholt L., Graves A., Kavukcuoglu K. (2016). Conditional Image Generation with PixelCNN Decoders // https://arxiv.org/abs/1606.05328

- ↑ Salimans T., Karpathy A., Chen X., Kingma D. P. (2017). PixelCNN++: Improving the PixelCNN with Discretized Logistic Mixture Likelihood and Other Modifications // https://arxiv.org/abs/1701.05517

- ↑ Sohl-Dickstein J., Weiss E. A., Maheswaranathan N., Ganguli S. (2015). Deep Unsupervised Learning using Nonequilibrium Thermodynamics // https://arxiv.org/abs/1503.03585

- ↑ Ho J., Jain A., Abbeel P. (2020). Denoising Diffusion Probabilistic Models // https://arxiv.org/abs/2006.11239

- ↑ Nichol A., Dhariwal P. (2021). Improved denoising diffusion probabilistic models // https://arxiv.org/abs/2102.09672

- ↑ Dhariwal P., Nichol A. (2021). Diffusion Models Beat GANs on Image Synthesis // https://arxiv.org/abs/2105.05233

- ↑ Jiang Y., Chang S., Wang Z. (2021). TransGAN: Two Pure Transformers Can Make One Strong GAN, and That Can Scale Up // https://arxiv.org/abs/2102.07074