8.1 Перспективные направления исследований

Отдельный жанр статей в жёлтой прессе составляют публикации, утверждающие, что исследования в области ИИ зашли в тупик. Причём в роли непроходимого тупика фигурируют самые разные проблемы, некоторые из них и вовсе не являются проблемами, какие-то просто иллюстрируют глубокое непонимание автором вопроса, который он взялся освещать, а иные, напротив, соответствуют активно развивающимся секторам. Быстрый прогресс в области ИИ привёл к расширению фронта исследований, при этом прогресс продолжается во множестве направлений. Мы уже рассмотрели немало примеров того, как постепенно улучшаются значения метрик при решении различных задач, как появляются новые модели и подходы, как под напором исследовательских усилий сдаются задачи, которые публика ещё вчера считала неразрешимыми. Конечно, громко заявить, что прогресса нет, — верный способ привлечь к себе внимание, и многие заявления следует воспринимать сквозь призму экономики современных медиа, ориентированной на максимизацию числа просмотров. Но это вовсе не значит, что прогресс даже в такой стремительно развивающейся области, как ИИ, — это лёгкая увеселительная прогулка для учёных. За решениями проблем часто стоят нелёгкий труд, множество экспериментов, размышлений и неудач, остающихся сокрытыми от читателей очередных статей, устанавливающих новую планку SOTA в решении той или иной задачи. Какие вопросы стоят сегодня перед исследователями в области ИИ? Какие направления исследований вызывают наибольший интерес у учёных? В каких сферах мы можем ждать революционных достижений в грядущее десятилетие? Давайте попробуем разобраться и в этом.

Начнём мы с направления, которое традиционно называют AutoML. В отношении коннекционистских моделей одной из наиболее актуальных задач, относящихся к AutoML, является «поиск нейросетевой архитектуры» (Neural architecture search, NAS). Работа специалиста по машинному обучению в наши дни нередко связана с поиском оптимальных параметров модели, а также параметров процесса обучения (которые ещё называют гиперпараметрами, чтобы отличать их от параметров самой модели). В глубоком обучении вслед за подготовкой первой версии обучающей выборки обычно следует этап экспериментов с нейросетевыми архитектурами из нескольких последних SOTA-работ, посвящённых решаемой задаче или задаче, напоминающей решаемую, а затем начинается длительный период экспериментов по модификации выбранной архитектуры, подбору гиперпараметров и различных параметров процесса аугментации данных. Многие из этих действий имеют преимущественно механический характер, что подталкивает к идее о том, что такая работа может быть автоматизирована. Почему бы не использовать какую-нибудь модель машинного обучения, которая будет самостоятельно проектировать другие модели наиболее оптимальным образом? Перспективы этого подхода будоражат воображение: оно тут же начинает рисовать картину самосовершенствующейся системы ИИ, подобной предложенной Юргеном Шмидхубером гипотетической машине Гёделя [Gödel machine][1], и того самого «интеллектуального взрыва». Неудивительно, что в этом направлении ведутся активные исследования.

В «классическом» машинном обучении (предназначенном для работы с данными сравнительно небольшой размерности) возможность автоматического подбора параметров модели встроена во многие популярные программные библиотеки: auto-sklearn[2], AutoWEKA[3], AutoGluon[4], H2O[5], [6], TPOT[7], FLO[8], CatBoost[9] — эти названия обычно хорошо знакомы тем, кто работает с «неглубокими» моделями машинного обучения. Семь лет назад мы с коллегами также разработали одну из таких библиотек, получившую название Est1mator. Однако «классические» модели обладают существенно меньшим числом параметров, чем «глубокие» модели, да и вычислительные затраты на один эксперимент по обучению модели в случае «неглубоких» моделей обычно заметно скромнее. Долгое время возможность применения методов AutoML к глубокому обучению рассматривалась специалистами как перспектива сравнительно отдалённого будущего. Однако начиная с 2016 г. исследователи Google и DeepMind опубликовали сразу несколько серьёзных работ[10],[11], [12], [13], [14], [15],[16], [17], посвящённых этому направлению. Сегодня исследованиями в области NAS занимаются исследователи и других технологических компаний, таких как Samsung[18], [19], Microsoft[20], Facebook[21], [22] и Bosch[23]. Не отстают и университетские[24] учёные, особенно исследователи из Китая[25], [26], [27]. Собственным инструментом для поиска нейросетевых архитектур обзавелась и одна из популярных библиотек для глубокого обучения — Keras. Этот инструмент, как несложно догадаться, получил наименование Auto-Keras[28].

За последние годы было создано несколько специальных наборов тестов для оценки возможностей систем поиска эффективных нейросетевых архитектур и гиперпараметров их обучения, например: NAS-bench-101[29], [30], NAS-Bench-201[31], NAS-Bench-360[32], NAS‑Bench‑x11[33], HW-NAS-Bench[34], NAS-Bench-ASR[35], NATS-Bench[36], NAS-HPO-Bench[37] и NAS-HPO-Bench-II[38]. Наверное, самым большим триумфом этого подхода на сегодняшний день стало создание[39], [40] семейства свёрточных нейросетевых архитектур EfficientNet, которые позволили достичь большей точности и эффективности, чем предыдущие свёрточные архитектуры. В частности, в 2019 г. архитектура EfficientNet-B7 позволила при классификации изображений ImageNet достичь[41] точности top-1 в 84,3% и точности top-5 в 97,0%, будучи в 8,4 раза меньше и в 6,1 раза быстрее при выполнении, чем лучшая из предшествовавших архитектур (AmoebaNet, обученная с применением библиотеки GPipe)[42]. В том же году исследователям из Google Brain при помощи более хитрой процедуры обучения, задействующей две нейросети («ученика» и «учителя»), удалось «выжать» из архитектуры EfficientNet-L2 при классификации изображений ImageNet значения точности top-1 и top-5, равные 90,2 и 98,8% соответственно[43].

Однако, несмотря на столь внушительные успехи, в области поиска нейросетевых архитектур существует ещё множество открытых вопросов. Как сделать процесс поиска наиболее вычислительно эффективным? Эксперименты в этой области пока что требуют значительных вычислительных ресурсов. Можно ли повторить успехи NAS в других областях, не связанных с обработкой изображений, и какие алгоритмы позволят добиться наибольшей эффективности в этом направлении? И наконец, нельзя ли создать универсальные методы, позволяющие осуществлять эффективный поиск нейросетевых архитектур для решения произвольных задач?

Все эти проблемы изучаются в рамках области машинного обучения, получившей название «метаобучение» [meta-learning]. Основная цель метаобучения — улучшение производительности существующих методов машинного обучения; по сути, перед метаобучением стоит задача «научиться учиться» [learn to learn].

Другое важное направление исследований — перенос обучения (знаний) [transfer learning] (мы коротко затрагивали эту тему, рассуждая о возможностях импульсных нейронных сетей). Эта область занимается поиском методов, позволяющих использовать знания, полученные при решении одной задачи, для решения других, сходных с ней. Например, модель, обученная различать различных животных на изображениях, может быть использована для распознавания пород собак. Одной из разновидностей переноса знаний является дообучение, или тонкая настройка [fine-tuning], модели с применением сравнительно небольших датасетов, содержащих примеры решения целевых задач. В некотором роде триумфом переноса обучения стало появление предобученных моделей для обработки естественного языка, основанных на трансформерных архитектурах, — мы подробно обсуждали этот вопрос в ходе рассказа о моделях семейства GPT. Проклятием переноса обучения является проблема «катастрофического забывания» [catastrophic forgetting][44], которая заключается в том, что в процессе доучивания модель быстро теряет полученные ранее знания. Чтобы не допустить этого, доучивание обычно ограничивают небольшим количеством эпох обучения, а также используют низкие значения скорости обучения. Однако это делает сам процесс доучивания вычислительно более дорогим, менее эффективным и менее стабильным. Для борьбы с катастрофическим забыванием предложен ряд весьма остроумных техник, таких как, например, «эластическая консолидация весов» [elastic weights consolidation][45], [46] или «ослабление скоростей весов» [weight velocity attenuation][47], однако они нередко связаны с существенными дополнительными затратами (вычислительными или в виде использования дополнительного объёма памяти).

Хотя в наши дни нейросетевые модели обычно обучают при помощи различных методов градиентного спуска, исследователи задумываются над тем, чтобы использовать более «умные» алгоритмы для подстройки весов нейронных сетей. Теоретически, «изучив» множество сессий обучения, некоторая модель может научиться более эффективно модифицировать веса нейронной сети, чтобы достигать меньшего значения ошибки за меньшее число шагов обучения. Решением этой задачи по «воспитанию воспитателя» в настоящее время занимается ряд исследователей, и уже получены первые обнадёживающие результаты[48] в этой области. Не исключено, что развитие именно этого направления позволит совершить очередной прорыв в области машинного обучения в ближайшем будущем.

Возможно, новые исследования позволят найти замену даже такому, казалось бы, фундаментальному элементу нейросетевых технологий, как метод обратного распространения ошибки. Авторы статьи «Градиенты без обратного распространения ошибки» (Gradients without Backpropagation)[49], вышедшей в свет в начале 2022 г., показывают в своём исследовании, что градиенты весов нейронной сети можно рассчитывать при помощи более быстрого алгоритма, который авторы назвали «прямым градиентом» [forward gradient].

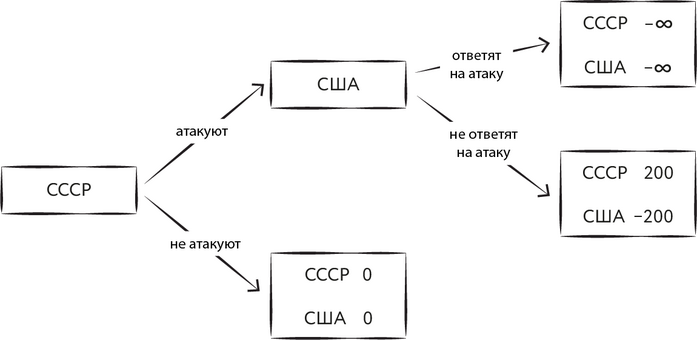

Рост интереса к большим языковым моделям вслед за громким успехом таких проектов, как GPT-3 и ChatGPT, привёл к расширению исследований в этой и смежных областях — мы говорили в разделах 6.6.5 и 6.6.6 о многих актуальных вызовах, стоящих перед создателями будущих LLM. Одной из наиболее амбициозных стратегических целей здесь является выстраивание «мостика» от современных LLM и MLLM к будущим системам общего искусственного интеллекта. Развитие моделей, способных строить цепочки и деревья рассуждений, ставит вопрос о возможности применения продвинутых языковых моделей к задачам стратегического планирования. Ни для кого не секрет, что теория игр, и в частности деревья (и графы) возможных решений, активно использовалась в стратегическом планировании ещё в годы холодной войны (Первой холодной войны?).

Рис. 178. Пример дерева возможных альтернатив для принятия стратегического решения

В наши дни важным инструментом для создания и анализа таких деревьев могут стать большие языковые модели. Поскольку они в некоторой мере уже сегодня являются пусть и упрощёнными, но моделями мира, их можно использовать как для генерации возможных альтернатив, так и для оценки всей совокупности совершённых акторами действий в терминальных узлах дерева. Таким образом, деревья стратегических решений могут стать куда более сложными и разветвлёнными. Все эти идеи наводят на мысль о возможности создания обобщающей теории применения фундаментальных моделей в решении сложных интеллектуальных задач. Например, на роль такой теории может претендовать концепция программ на базе больших языковых моделей [Large Language Model Programs][50], [51]. Скорее всего, в ближайшие годы в этой области появится множество новых проектов и стартапов.

В 2022 г. своим видением на развитие ИИ в ближайшее десятилетие поделился Ян Лекун[52]. По его мнению, сейчас перед отраслью стоят три основных вызова:

системы ИИ должны научиться представлять мир;

системы ИИ должны научиться строить умозаключения и планы путями, совместимыми с обучением на основе градиентных методов оптимизации;

системы ИИ должны научиться строить иерархии планов действий.

Лекун видит решение первой проблемы в развитии методов самообучения [self-supervised learning]. Их успешное применение будет означать, что системы ИИ способны создавать сложные модели мира. При этом, по мнению Лекуна, роль данных для обучения для следующего поколения систем машинного обучения уготована уже не языку и не изображениям, а видео. В настоящее время Meta (бывшая Facebook) прилагает много усилий для сбора видеоданных от первого лица. Впрочем, по словам Лекуна, видео с YouTube также являются подходящим учебным материалом.

Лекун считает, что системы искусственного интеллекта смогут из таких видеороликов узнать о физических основах нашего мира. А эти знания, в свою очередь, станут основой для развития способностей ИИ, связанных с реальным миром (например, хватание предметов или вождение автомобиля). Вообще весьма интересным является вопрос о том, можно ли создать универсальный искусственный интеллект путём машинного обучения, опирающегося только на имеющийся цифровой след человечества, или же для этого необходимо активное взаимодействие с окружающим миром при помощи физических аватаров (или хотя бы программных агентов, взаимодействующих с человеческим обществом при помощи Всемирной сети).

Опираясь на выученные представления, системы ИИ должны научиться рассуждать и действовать. Почему, с точки зрения Лекуна, важно при этом, чтобы в основе обучения лежали именно градиентные методы (вторая задача)? Именно градиентным методам мы во многом обязаны началом революции глубокого обучения. Возможность представить задачу в виде, который позволяет на каждом шаге оптимизации определять наиболее перспективное направление поиска, даёт возможность существенно сэкономить время для нахождения решения. Конечно, оптимум можно найти и путём случайных блужданий по пространству возможных решений, но вычислительные затраты при таком подходе обычно непомерно велики, особенно в случае задач, относящихся к такой сложной среде, как реальный мир. Хотя Лао-цзы и говорил: «Путь в тысячу ли начинается с первого шага», но важно, чтобы сделанные шаги приближали нас к цели, а не отдаляли от неё. Способность правильно определять направление легко может превратить бесцельное блуждание длиною в жизнь в получасовую прогулку. Однако определить правильное направление часто бывает непросто, и тут нам на помощь приходит способность находить промежуточные цели. Именно к ней отсылает нас третья проблема, обозначенная Лекуном: необходимость научить системы ИИ строить иерархии планов. Многие интеллектуальные задачи подобны огромному пирогу — съесть их можно только по частям. Но для этого важно освоить высокое искусство разделки пирога, в котором вполне преуспели люди и которое пока что с трудом даётся системам ИИ.

В конце июня 2022 г. на сайте OpenReview появилась первая версия статьи Лекуна под названием «Путь к автономному машинному интеллекту» [A Path Towards Autonomous Machine Intelligence][53]. Эта статья обобщает и систематизирует взгляды учёного по обозначенному в заголовке вопросу. Конечно, многие из идей, изложенных в статье, не являются изобретением самого Лекуна. В обсуждении, возникшем под текстом статьи, можно, в частности, найти комментарии Юргена Шмидхубера, который проделал большую работу по установлению генезиса высказываемых Лекуном идей в истории современной науки. Некоторые из них появились уже в работах, написанных в 1980-е гг., некоторые изложены в работах самого Шмидхубера, написанных в последние три десятилетия. Однако будет неправильным сказать, что вклад Лекуна заключался только в сборе и систематизации идей. Например, Лекун сделал серьёзный шаг в сторону постановки конкретного вычислительного эксперимента, предложив в качестве шага к будущему AGI конкретные классы нейросетевых архитектур под не совсем благозвучными для русского уха названиями JEPA (Joint Embedding Predictive Architectures, Предсказывающие архитектуры [на основе векторных] вложений) и Hierarchical JEPA (Иерархические JEPA). В 2023 г. появились первые функциональные модели, относящиеся к классу JEPA, например созданная при участии самого Лекуна I-JEPA (Image-based JEPA; JEPA, базирующаяся на изображениях)[54]. Лекун резюмирует масштабную задачу ИИ на следующее десятилетие в форме одного вопроса: как сформировать у машин способность выучивать модели, которые смогут оперировать неопределённостью и отражать реальный мир во всей его сложности?

Для Лекуна ответ начинается с методов самообучения. Действительно, сегодня это одна из самых горячих тем в области ИИ. Но давайте посмотрим и на другие важные аспекты развития технологий в этой сфере.

- ↑ Schmidhuber J. (2003). Goedel Machines: Self-Referential Universal Problem Solvers Making Provably Optimal Self-Improvements // https://arxiv.org/abs/cs/0309048

- ↑ Feurer M., Eggensperger K., Falkner S., Lindauer M., Hutter F. (2020). Auto-Sklearn 2.0: The Next Generation // https://arxiv.org/abs/2007.04074

- ↑ Kotthoff L., Thornton C., Hoos H. H., Hutter F., Leyton-Brown K. (2016). Auto-WEKA 2.0: Automatic model selection and hyperparameter optimization in WEKA / Journal of Machine Learning Research, Vol. 17 (2016) // http://www.cs.ubc.ca/labs/beta/Projects/autoweka/papers/16-599.pdf

- ↑ Erickson N., Mueller J., Shirkov A., Zhang H., Larroy P., Li M., Smola A. (2020). AutoGluon-Tabular: Robust and Accurate AutoML for Structured Data // https://arxiv.org/abs/2003.06505

- ↑ Arora A., Candel A., Lanford J., LeDell E., Parmar V. (Oct. 2016). Deep Learning with H2O / http://docs.h2o.ai/h2o/latest-stable/h2o-docs/booklets/DeepLearningBooklet.pdf

- ↑ Click C., Lanford J., Malohlava M., Parmar V., Roark H. (Oct. 2016). Gradient Boosted Models with H2O / http://docs.h2o.ai/h2o/latest-stable/h2o-docs/booklets/GBMBooklet.pdf

- ↑ Le T. T., Fu W., Moore J. H. (2020). Scaling tree-based automated machine learning to biomedical big data with a feature set selector / Bioinformatics, Vol. 36 (1), pp. 250—256 // https://doi.org/10.1093/bioinformatics/btz470

- ↑ Wang C., Wu Q. (2019). FLO: Fast and Lightweight Hyperparameter Optimization for AutoML // https://arxiv.org/abs/1911.04706

- ↑ Prokhorenkova L., Gusev G., Vorobev A., Dorogush A. V., Gulin A. (2017). CatBoost: unbiased boosting with categorical features // https://arxiv.org/abs/1706.09516

- ↑ Zoph B., Le Q. V. (2016). Neural Architecture Search with Reinforcement Learning // https://arxiv.org/abs/1611.01578

- ↑ Real E., Moore S., Selle A., Saxena S., Suematsu Y. L., Tan J., Le Q., Kurakin A. (2017). Large-Scale Evolution of Image Classifiers // https://arxiv.org/abs/1703.01041

- ↑ Kaiser L., Gomez A. N., Shazeer N., Vaswani A., Parmar N., Jones L., Uszkoreit J. (2017). One Model To Learn Them All // https://arxiv.org/abs/1706.05137

- ↑ Zoph B., Vasudevan V., Shlens J., Le Q. V. (2017). Learning Transferable Architectures for Scalable Image Recognition // https://arxiv.org/abs/1707.07012

- ↑ Chen L.-C., Collins M. D., Zhu Y., Papandreou G., Zoph B., Schroff F., Adam H., Shlens J. (2018). Searching for Efficient Multi-Scale Architectures for Dense Image Prediction // https://arxiv.org/abs/1809.04184

- ↑ Liu H., Simonyan K., Yang Y. (2018). DARTS: Differentiable Architecture Search // https://arxiv.org/abs/1806.09055

- ↑ Howard A., Sandler M., Chu G., Chen L.-C., Chen B., Tan M., Wang W., Zhu Y., Pang R., Vasudevan V., Le Q. V., Adam H. (2019). Searching for MobileNetV3 // https://arxiv.org/abs/1905.02244v5

- ↑ Xiong Y., Liu H., Gupta S., Akin B., Bender G., Kindermans P.-J., Tan M., Singh V., Chen B. (2020). MobileDets: Searching for Object Detection Architectures for Mobile Accelerators // https://arxiv.org/abs/2004.14525v2

- ↑ Abdelfattah M. S., Mehrotra A., Dudziak Ł., Lane N. D. (2021). Zero-Cost Proxies for Lightweight NAS // https://arxiv.org/abs/2101.08134

- ↑ Dudziak Ł., Chau T., Abdelfattah M. S., Lee R., Kim H., Lane N. D. (2020). BRP-NAS: Prediction-based NAS using GCNs // https://arxiv.org/abs/2007.08668

- ↑ Zhang Y., Zhang Q., Yang Y. (2020). How Does Supernet Help in Neural Architecture Search? // https://arxiv.org/abs/2010.08219

- ↑ Dai X., Zhang P., Wu B., Yin H., Sun F., Wang Y., Dukhan M., Hu Y., Wu Y., Jia Y., Vajda P., Uyttendaele M., Jha N. K. (2018). ChamNet: Towards Efficient Network Design through Platform-Aware Model Adaptation // https://arxiv.org/abs/1812.08934

- ↑ Wan A., Dai X., Zhang P., He Z., Tian Y., Xie S., Wu B., Yu M., Xu T., Chen K., Vajda P., Gonzalez J. E. (2020). FBNetV2: Differentiable Neural Architecture Search for Spatial and Channel Dimensions // https://arxiv.org/abs/2004.05565

- ↑ Awad N., Mallik N., Hutter F. (2020). Differential Evolution for Neural Architecture Search // https://arxiv.org/abs/2012.06400

- ↑ Jie R., Gao J. (2021). Differentiable Neural Architecture Search with Morphism-based Transformable Backbone Architectures // https://arxiv.org/abs/2106.07211

- ↑ Tian Y., Shen L., Shen L., Su G., Li Z., Liu W. (2020). AlphaGAN: Fully Differentiable Architecture Search for Generative Adversarial Networks // https://arxiv.org/abs/2006.09134

- ↑ Ding M., Lian X., Yang L., Wang P., Jin X., Lu Z., Luo P. (2021). HR-NAS: Searching Efficient High-Resolution Neural Architectures with Lightweight Transformers // https://arxiv.org/abs/2106.06560

- ↑ Yang Y., You S., Li H., Wang F., Qian C., Lin Z. (2021). Towards Improving the Consistency, Efficiency, and Flexibility of Differentiable Neural Architecture Search // https://arxiv.org/abs/2101.11342

- ↑ Jin H., Song Q., Hu X. (2018). Auto-Keras: An Efficient Neural Architecture Search System // https://arxiv.org/abs/1806.10282

- ↑ Ying C., Klein A., Real E., Christiansen E., Murphy K., Hutter F. (2019). NAS-Bench-101: Towards Reproducible Neural Architecture Search // https://arxiv.org/abs/1902.09635

- ↑ Zela A., Siems J., Hutter F. (2020). NAS-Bench-1Shot1: Benchmarking and Dissecting One-shot Neural Architecture Search // https://arxiv.org/abs/2001.10422

- ↑ Dong X., Yang Y. (2020). NAS-Bench-201: Extending the Scope of Reproducible Neural Architecture Search // https://arxiv.org/abs/2001.00326

- ↑ Tu R., Khodak M., Roberts N., Talwalkar A. (2021). NAS-Bench-360: Benchmarking Diverse Tasks for Neural Architecture Search // https://arxiv.org/abs/2110.05668

- ↑ Yan S., White C., Savani Y., Hutter F. (2021). NAS-Bench-x11 and the Power of Learning Curves // https://arxiv.org/abs/2111.03602

- ↑ Li C., Yu Z., Fu Y., Zhang Y., Zhao Y., You H., Yu Q., Wang Y., Lin Y. (2021). HW-NAS-Bench: Hardware-Aware Neural Architecture Search Benchmark // https://arxiv.org/abs/2103.10584

- ↑ Mehrotra A., Ramos A. G. C. P., Bhattacharya S., Dudziak Ł., Vipperla R., Chau T., Abdelfattah M. S., Ishtiaq S., Lane N. D. (2020). NAS-Bench-ASR: Reproducible Neural Architecture Search for Speech Recognition // https://openreview.net/forum?id=CU0APx9LMaL

- ↑ Dong X., Liu L., Musial K., Gabrys B. (2020). NATS-Bench: Benchmarking NAS Algorithms for Architecture Topology and Size // https://arxiv.org/abs/2009.00437

- ↑ Klein A., Hutter F. (2019). Tabular Benchmarks for Joint Architecture and Hyperparameter Optimization // https://arxiv.org/abs/1905.04970

- ↑ Hirose Y., Yoshinari N., Shirakawa S. (2021). NAS-HPO-Bench-II: A Benchmark Dataset on Joint Optimization of Convolutional Neural Network Architecture and Training Hyperparameters // https://arxiv.org/abs/2110.10165

- ↑ Tan M., Le Q. V. (2019). EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks // https://arxiv.org/abs/1905.11946

- ↑ Arora A. (2020). EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks // https://amaarora.github.io/2020/08/13/efficientnet.html

- ↑ Tan M., Le Q. V. (2019). EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks // https://arxiv.org/abs/1905.11946

- ↑ Huang Y., Cheng Y., Bapna A., Firat O., Chen M. X., Chen D., Lee H. J., Ngiam J., Le Q. V., Wu Y., Chen Z. (2018). GPipe: Efficient Training of Giant Neural Networks using Pipeline Parallelism // https://arxiv.org/abs/1811.06965

- ↑ Pham H., Dai Z., Xie Q., Luong M.-T., Le Q. V. (2020). Meta Pseudo Labels // https://arxiv.org/abs/2003.10580

- ↑ Wang Z., Yang E., Shen L., Huang H. (2023). A Comprehensive Survey of Forgetting in Deep Learning Beyond Continual Learning // https://arxiv.org/abs/2307.09218

- ↑ Kirkpatrick J., Pascanu R., Rabinowitz N., Veness J., Desjardins G., Rusu A. A., Milan K., Quan J., Ramalho T., Grabska-Barwinska A., Hassabis D., Clopath C., Kumaran D., Hadsell R. (2017). Overcoming catastrophic forgetting in neural nets / Proceedings of the National Academy of Sciences of the United States of America, Vol. 114 (13), pp. 3521—3526 // https://doi.org/10.1073/pnas.1611835114

- ↑ Kutalev A., Lapina A. (2021). Stabilizing Elastic Weight Consolidation method in practical ML tasks and using weight importances for neural network pruning // https://arxiv.org/abs/2109.10021

- ↑ Kutalev A. (2020). Natural Way to Overcome the Catastrophic Forgetting in Neural Networks // https://arxiv.org/abs/2005.07107

- ↑ Metz L., Maheswaranathan N., Freeman C. D., Poole B., Sohl-Dickstein J. (2020). Tasks, stability, architecture, and compute: Training more effective learned optimizers, and using them to train themselves // https://arxiv.org/abs/2009.11243

- ↑ Baydin A. G., Pearlmutter B. A., Syme D., Wood F., Torr P. (2022). Gradients without Backpropagation // https://arxiv.org/abs/2202.08587

- ↑ Schlag I., Sukhbaatar S., Celikyilmaz A., Yih W.-t., Weston J., Schmidhuber J., Li X. (2023). Large Language Model Programs // https://arxiv.org/abs/2305.05364

- ↑ Sapunov G. (2023). Large Language Model Programs. A useful conceptualization for a wide set of practices for working with LLMs // https://gonzoml.substack.com/p/large-language-model-programs

- ↑ Schreiner M. (2022). Meta’s AI chief: Three major challenges of artificial intelligence / MIXED, Jan 29 2022 // https://mixed-news.com/en/metas-ai-chief-three-major-challenges-of-artificial-intelligence/

- ↑ LeCun Y. (2022). A Path Towards Autonomous Machine Intelligence // https://openreview.net/forum?id=BZ5a1r-kVsf

- ↑ Assran M., Duval Q., Misra I., Bojanowski P., Vincent P., Rabbat M., LeCun Y., Ballas N. (2023). Self-Supervised Learning from Images with a Joint-Embedding Predictive Architecture // https://arxiv.org/abs/2301.08243