8.5 Морально-этические вопросы применительно к ИИ

На свете есть мало занятий, — сказал Ме-ти, — которые бы так расшатывали мораль человека, как занятия моралью. Мне доводилось слышать: надо быть правдолюбивым, надо выполнять свои обещания, надо бороться за добро. Но деревья не говорят: надо быть зелёными, фрукты должны падать на землю вертикально вниз; надо шелестеть листвой, когда подует ветер.

Бертольд Брехт. Ме-ти. Книга перемен[1]

Развернувшаяся в последние годы гонка гигантских трансформерных архитектур — ещё один довод в пользу необходимости создания новых моделей. Исследователи в области глубокого обучения отлично это понимают, что и показывает активный поиск ими новых разновидностей разреженных трансформеров. Конечно, гонка больших моделей будет продолжена даже при появлении новых, более эффективных архитектур, но ведь возможности этих архитектур, умноженные на мощь новых аппаратных средств, сулят ещё больший прогресс в решении задач ИИ. Забавно, что революция трансформеров в NLP в некотором смысле вернула нас в эпоху мейнфреймов, только на совершенно новом технологическом уровне. Вновь для решения некоторых типовых для индустрии задач нужны машины, которые пока что слишком дороги, чтобы предоставить их в индивидуальное пользование. Рассказы родителей об их работе на компьютерах с терминальным доступом за пару лет из «преданий старины глубокой» превратились во вполне актуальный нарратив.

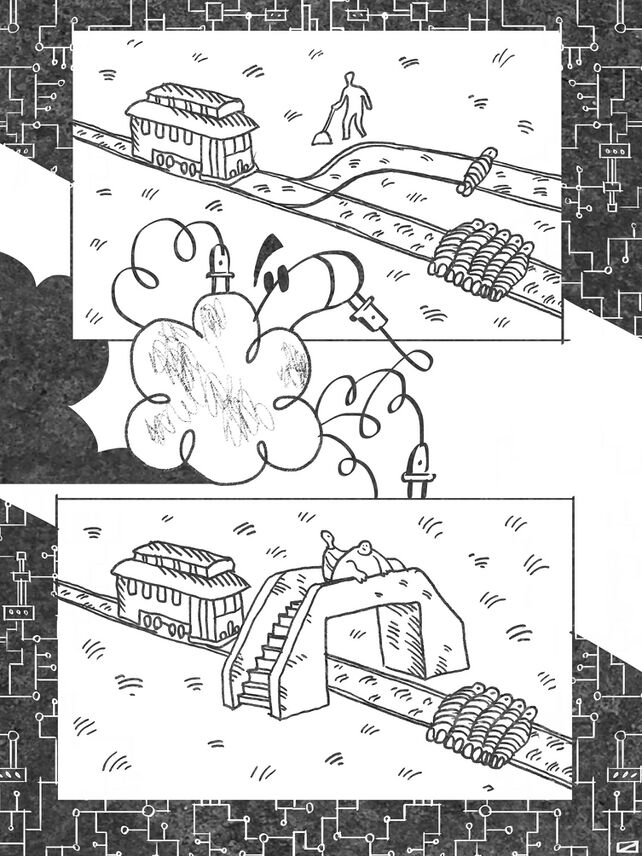

Ещё к одной интересной проблеме современного ИИ привлекли внимание общества французский исследователь Жан-Франсуа Боннфон и его коллеги. В 2016 г. Боннфон, Азим Шариф и Ияд Рахван опубликовали в журнале Science статью под названием «Социальная дилемма автономных транспортных средств» (The social dilemma of autonomous vehicles)[2]. В ней они задались вопросом о том, что, хотя массовое внедрение автономного транспорта может сократить общее количество жертв на дорогах, в определённых ситуациях автопилотам придётся совершать выбор из двух зол, который непросто сделать и человеку. Речь идёт о ситуациях, напоминающих знаменитую проблему вагонетки (Trolley problem) — мысленный эксперимент, впервые сформулированный в 1967 г. английским философом Филиппой Фут. Фут использовала несколько формулировок своего эксперимента, вот одна из его современных формулировок: «Представьте себе, что тяжёлая неуправляемая вагонетка мчится по рельсам в направлении стрелки, которую вы можете переключить. В зависимости от положения стрелки вагонетка продолжит свой путь по одному из путей. На первом из них (по нему вагонетка пойдёт, если стрелку не переключить) лежит пятеро человек, привязанных к рельсам сумасшедшим философом. На другом пути к рельсам привязан лишь один человек».

Участникам этого мысленного эксперимента предлагается сделать выбор: либо остаться безучастными, что приведёт к гибели пяти человек, либо вмешаться — в результате чего погибнет только один несчастный. Также, для исключения юридического аспекта, иногда добавляют оговорку типа: «Вас никто не видит, и никто не узнает о принятом вами решении».

Выбор в пользу вмешательства обычно ассоциируют с утилитаристской (утилитарной) этикой, то есть такой этической системой, в которой моральная ценность поступка определяется его полезностью, под которой подразумевается суммарное удовольствие или счастье, полученное всеми сторонами. Исследования показывают, что большинство людей в наши дни выбирают именно этот вариант, но есть и те, кто предпочитают путь невмешательства: в конце концов, на первом пути могут быть привязаны пять условных Гитлеров, а на втором — условный Эйнштейн. «Кто мы, чтобы не дать свершиться божественному провидению и решать, кому жить, а кому умереть?» — могут сказать приверженцы какой-нибудь человеколюбивой религии. Однако таких в нашем обществе, похоже, всё-таки меньшинство. Ситуация перестаёт быть такой однозначной, если исходный эксперимент подвергнуть небольшой модификации, как это сделала философ Джудит Томсон. В её формулировке задача становится следующей: «Как и прежде, вагонетка несётся по рельсам, к которым привязаны пять человек. Вы находитесь на мосту, который проходит над рельсами. У вас есть возможность остановить вагонетку, бросив на пути что-нибудь тяжёлое. Рядом с вами находится толстый человек, и единственная возможность остановить вагонетку — столкнуть его с моста на пути. Каковы ваши действия?»

Возможно, в силу того, что совершать насилие без посредника в виде механизма сложнее, а может быть, в силу того, что толстяк может оказать сопротивление, людям труднее совершить в такой ситуации утилитарный выбор. Будучи толстяком, в этом эксперименте я обладаю уникальной третьей возможностью — прыгнуть на рельсы самостоятельно, но по условиям эксперимента выбор следует сделать всё-таки из двух зол, а не из трёх. К настоящему времени специалисты по этике и просто шутники придумали множество собственных модификаций проблемы вагонетки. В Facebook мемам, связанным с проблемой вагонетки, посвящено целое сообщество — Trolley problem memes.

Какое всё это имеет отношение к автономному транспорту? Самое непосредственное. В случае отказа тормозов или в результате внезапно возникшей на дороге ситуации автопилот может быть поставлен перед выбором, аналогичным выбору в проблеме вагонетки. И если в ситуации выбора между, например, гибелью пяти пешеходов или одного решение более-менее очевидно, как осуществить выбор, например, между гибелью старика и гибелью ребёнка? А что, если выбор заключается в том, совершить ли наезд на пешеходов или принести в жертву пассажиров автомобиля ради спасения пешеходов (резко вывернув руль и направив транспортное средство в отбойник). Определение алгоритмов, которые помогут автономным транспортным средствам принимать такие этические решения, является сложной задачей. Авторы исследования обнаружили, что участники шести исследований на платформе Amazon Mechanical Turk в основном одобрили использование автономными транспортными средствами утилитарной этики (предполагающей принесение в жертву пассажиров транспортного средства в ситуациях, когда это позволяет спасти больше жизней), но хотели бы, чтобы такие автомобили покупали другие люди, в то время как сами предпочли бы ездить в машине, автопилот которой защищает пассажиров любой ценой. Соответственно, реализация в автопилотах утилитарных алгоритмов может привести к нежеланию людей ими пользоваться и парадоксальным образом увеличить количество жертв. В общем, простая система правил в духе азимовских «трёх законов робототехники» вряд ли поможет решить все этические проблемы, возникающие из-за использования систем ИИ. Вряд ли существует универсальный набор принципов, который устроил бы всех. Конечно, существуют правила дорожного движения, которые обязательны к соблюдению всеми его участниками, но они не регламентируют действия водителя транспортного средства во многих нештатных ситуациях, что оставляет пространство для этического выбора.

Исследование этических проблем автономных транспортных средств было позже продолжено расширенным коллективом авторов в рамках проекта Moral machine — «Моральная машина» (или «Машина морали»?)[3], [4]. Зайдя на сайт проекта, любой желающий может поучаствовать в выборе «правильных» решений автопилота в различных критических ситуациях с участием двух групп людей (или животных). Каждая из этих групп включает от одного до пяти персонажей, при этом, в зависимости от принятого решения, одна из групп обречена на смерть, а вторая будет спасена.

В каждой из дилемм у беспилотного автомобиля внезапно отказали тормоза, в то время как перед ним кто-то переходит дорогу (либо по правилам, либо нарушая их — на красный свет). В одних дилеммах выбор нужно осуществить между двумя группами пешеходов, в других — между группой пешеходов и группой пассажиров.

Участники групп различаются по возрасту (младенцы в колясках, дети, взрослые, пожилые), полу, физической форме (люди с избыточным весом, обычные люди и спортсмены), социальному статусу (бездомные, обычные люди и начальники). Кроме людей, участниками групп могут быть собаки и кошки. Система выбирает параметры дилеммы случайным образом, поэтому вероятность того, что участник исследования дважды столкнётся с одной и той же задачей, пренебрежимо мала.

Создателям проекта удалось собрать почти 40 млн решений дилемм от жителей 233 стран (при этом для 130 стран было не менее 100 респондентов). Участники исследования также заполняли анкету, в которой указывали свои возраст, пол, образование, ежегодный доход, отношение к религии и политические взгляды.

Исследователи стремились решить четыре основные задачи: 1) оценить значимость каждого из девяти факторов в среднем по всей выборке; 2) соотнести значимость факторов с индивидуальными характеристиками респондента; 3) сравнить результаты респондентов из разных стран и выделить кластеры стран со сходными моральными установками и 4) выяснить, можно ли по экономическим и/или культурным особенностям страны предсказать, как её жители предпочли бы программировать беспилотные транспортные средства.

В среднем респонденты сделали уверенный выбор в пользу спасения людей (а не животных) и больших групп (а не маленьких). Почти столь же уверенно они выступили за спасение молодых, законопослушных (переходящих дорогу на зелёный свет) и высокостатусных людей. Несколько менее значимыми, но всё же положительно влияющими на выбор признаками оказались хорошая физическая форма и женский пол. Кроме того, респонденты в среднем несколько чаще делали выбор в пользу пешеходов (а не пассажиров), а также в пользу того, чтобы транспортное средство продолжало ехать прямо, а не сворачивало на другую полосу.

Статистически значимого влияния анкетных данных респондентов на их выбор выявить не удалось, но при этом обнаружились интересные закономерности в распределении этических предпочтений по странам, которые распались на три больших кластера, условно названные исследователями «Западным», «Восточным» и «Южным». В Западный кластер попали США, Канада, а также многие европейские страны (католические, протестантские и православные). В Восточном кластере оказались сосредоточены страны с конфуцианской и мусульманской традицией. Южный кластер включает в себя две ветви, в одну из которых входят страны Латинской Америки, а во вторую — Франция и ряд стран, находившихся в прошлом под французским влиянием.

Для выделенных кластеров характерны весьма различающиеся представления о том, как должны вести себя беспилотные автомобили в критических ситуациях. Скажем, в Южном кластере люди чаще отдают предпочтение необходимости спасать прежде всего детей и женщин, в то время как респонденты из Восточного кластера в первую очередь отдают предпочтение законопослушным пешеходам и не ставят жизнь молодых намного выше жизни старших. Авторы также отметили, что в странах с высоким уровнем экономического неравенства люди чаще отдают предпочтение спасению людей, обладающих высоким социальным статусом («начальников»)[5].

Конечно, исследование обладает рядом очевидных недостатков. Под вопросом репрезентативность выборок по странам, сами дилеммы имеют довольно искусственный характер (вероятность их возникновения на дороге очень мала; кроме того, не учитывается оценка вероятности выживания людей в различных сценариях, что может явно перевесить все другие соображения) и так далее. Однако сам вопрос машинной этики, безусловно, представляет не только теоретический интерес. По мере того как системы прикладного ИИ получают всё более широкое распространение, возникает всё больше случаев, когда машины должны совершать сложный этический выбор.

Вступление в эру широкого распространения генеративных моделей[6] спровоцировало новый виток споров об этических проблемах искусственного интеллекта. Главным образом дискуссия возникла в отношении двух важных проблем. Первая — допустимость использования результатов творческой деятельности людей без их явного на то согласия. Многие художники, озабоченные возможной конкуренцией со стороны генеративных моделей, были неприятно удивлены тем фактом, что их работы (среди многих сотен миллионов других изображений, находящихся в открытом доступе) были использованы для обучения таких нейросетей, как Midjourney или Stable Diffusion. Не были в восторге и владельцы фотостоков. Сходные чувства испытали многие писатели и журналисты, понимая, что их тексты попали в обучающие выборки больших языковых моделей, которые наделали так много шума в некогда относительно спокойном мирке креативных индустрий. Результатом стало несколько судебных исков к компаниям — разработчикам генеративных инструментов[7], [8]. Основные аргументы сторон в данном случае понятны. Художники, писатели и владельцы фотостоков утверждают, что создатели генеративных моделей не имели права использовать опубликованные в интернете произведения для обучения нейросетей, поскольку не имели на то соответствующего разрешения от правообладателей. Основной контраргумент заключается в том, что размещение произведения в открытом доступе предполагает отсутствие ограничений на просмотр или прочтение — разглядывая картинку на интернет-странице или читая текст, расположенный в открытой части какого-либо сайта, вы не просите на это у автора отдельное разрешение. Мастерство тех же художников или писателей также основано на «насмотренности» или «начитанности», то есть на результатах просмотра или прочтения произведений других авторов. Художник, воспитанный на картинах Дали или Кандинского, избавлен от отчислений в пользу их наследников с продаж собственных картин. Произведения генеративных сетей не являются прямым плагиатом — в подавляющем большинстве случаев в них не содержится прямой репродукции изображений и текстов, используемых в процессе обучения (иногда такое всё же случается, например когда из обучающих выборок должным образом не удаляются многочисленные дубликаты одних и тех же произведений; впрочем, современные сервисы, основанные на генеративных моделях, обычно содержат специальные механизмы, предназначенные для недопущения «дословного» воспроизведения «учебных материалов»). Тем не менее в мире искусства нередки споры в ситуациях, когда создаются тексты или изображения, являющиеся продуктом переработки чужих прототипов. В таких случаях в ходе судебных разбирательств эксперты оценивают «глубину» переработки, объём творческого вклада каждой из сторон. В том, что генеративные сети способны создавать действительно новые тексты, изображения (и даже музыкальные произведения), несложно убедиться в эпоху поисковых систем и статистических методов анализа текстов. Ни один художник до DALL·E не рисовал иллюстрацию, на которой изображён ребёнок-дайкон в пачке, выгуливающий собаку, а произведения Нейропепперштейна не содержат сколь-нибудь длинных пересечений с текстами других авторов. Однако иногда здесь всё-таки возможен плагиат, и разработчикам генеративных моделей следует заботиться о том, чтобы таких случаев не возникало.

Ещё одно возражение противников свободного использования генеративных моделей машинного обучения заключается в том, что человек, в отличие от нейросети, физически не может в течение своей жизни ознакомиться с сотнями миллионов изображений и текстов. Следовательно, процесс обучения генеративной модели нельзя считать прямым аналогом знакомства людей с произведениями искусства. Ведь если вам разрешено ловить рыбу удочкой, это не значит, что вы можете в тех же местах использовать рыболовную сеть или динамит. Впрочем, если рыболовные сети при использовании уничтожают рыбу, то нейросети не уничтожают цифровые копии произведений искусства, на которых обучаются, поэтому в данном случае трудно усмотреть прямую аналогию.

В общем, теперь судам, как обычно, придётся разбираться в том, чья позиция в споре является более аргументированной, а обществу — в том, какой из взглядов на проблему является более этически приемлемым.

В конце октября 2023 г. суд удовлетворил ходатайство Midjourney, Stability AI и DeviantArt[9] о прекращении дела о нарушении авторских прав трёх американских художниц. Основной причиной такого решения суда стало то, что истицы не зарегистрировали авторские права на каждую из своих работ. При этом судья отметил, что если художницы ограничат свои претензии теми работами, авторские права на которые были зарегистрированы, то они могут подать повторный иск[10].

Вторая проблема, поставленная перед обществом революцией генеративных моделей, — массовое производство и распространение потенциально опасного или иного нежелательного контента. Опасная для жизни неправильная медицинская рекомендация от «галлюцинирующей» языковой модели, призыв к насилию или терроризму, повлиявший на чей-то неокрепший ум, систематическая дискриминация той или иной группы людей — это явно не те плоды генеративного ИИ, которые мы хотим с нетерпением вкусить. Именно поэтому сегодня огромные усилия исследователей направлены на то, чтобы уменьшить объёмы генерации потенциально вредного контента. Почти каждый пользователь ChatGPT или GigaChat хотя бы раз сталкивался с тем, что модель отказывается дать ответ на тот или иной вопрос или выполнить задание, ссылаясь на то, что это противоречит заложенным в неё этическим нормам и правилам. Иногда эти отказы обоснованны, а иногда — нет. Этика — сложная штука; в ней порой и людям-то за всю свою жизнь разобраться довольно непросто. Чего же ждать от экспериментальных моделей, появившихся совсем недавно? Для того чтобы сократить количество нежелательных ответов моделей, обучающие данные, собираемые в открытых источниках, подвергают фильтрации и балансировке (вспомним печальную судьбу датасета Tiny Images, описанную в разделе 6.2.1.2), в обучающие выборки добавляют наборы выверенных ответов на скользкие вопросы, генеративные сети окружают системами правил и дополнительными моделями, детектирующими ответы, которые не следует давать пользователю. Однако и эти барьеры при желании или по неосторожности можно преодолеть — мы уже обсуждали эту проблему в разделе 6.6.4, когда рассматривали возможные атаки на генеративные модели. Реалии сегодняшнего медиапространства заключаются в том, что всё, что сгенерирует выставленная на публику модель, будет всенепременно использовано против её разработчиков. Повсеместное увлечение проблемами этичности и безопасности ответов генеративных моделей приводит порой к обратному результату. Так, несколько групп разработчиков уже заявило о разработке намеренно неэтичных моделей-беспредельщиков. Например, известный в узких кругах ML-специалист и ML-видеоблогер Янник Килчер опубликовал[11] в 2022 г. модель GPT-4chan с 6 млрд параметров, обученную на постах из раздела /pol/ популярного анонимного веб-форума 4chan (соответствующий датасет получил название Raiders of the Lost Kek [Налётчики Потерянного Кека][12]). Этот раздел весьма популярен и известен своей особенной токсичностью (даже по меркам токсичного в целом 4chan). Раздел в изобилии содержит расистские, женоненавистнические и антисемитские сообщения, стилистику и идейное наполнение которых генеративный трансформер успешно научился воспроизводить. В своём видео, описывающем проект, Килчер охарактеризовал результат следующим образом: «Модель была хороша в самом ужасном смысле» [The model was good, in a terrible sense]. Публикация модели вызвала нешуточное возмущение[13] — онлайн-петиция[14] с осуждением действий Килчера собрала множество подписей (среди них, как и в случае обсуждавшихся нами ранее открытых писем, есть подпись Йошуа Бенджио).

Отдельный юмор ситуации заключается в том, что GPT-4chan заметно превосходит GPT‑3 и собственную «родительскую» GPT-J на популярном наборе тестов TruthfulQA[15], предназначенном для оценки доли правдивых ответов языковых моделей.

FraudGPT, WormGPT, DarkGPT, DarkBERT, DarkBART, EVILdolly и так далее — число «неэтичных» моделей со временем множится[16], [17], несмотря на протесты многих ML-специалистов. Открытые письма, похоже, не могут остановить развитие тёмной стороны генеративных технологий, как не смогли они остановить военные применения ИИ. Похоже, что для борьбы со злом всё-таки нужны какие-то более действенные меры. Частью этих мер, вполне вероятно, должны стать другие модели машинного обучения, способные распознавать потенциально опасный контент. А для этого они должны «ознакомиться» с примерами такого контента на этапе обучения… Ирония заключается в том, что в конечном счёте ими могут оказаться те же самые «злые» модели, подобные GPT-4chan. Здесь круг замыкается: ведь то, как именно — во зло или во благо — будет применена та или иная модель, зависит от людей, от нас с вами.

- ↑ * Пер. С. Земляного.

- ↑ Bonnefon J.-F., Shariff A., Rahwan I. (2016). The social dilemma of autonomous vehicles / Science, Vol. 352, Iss. 6293, pp. 1573—1576 // https://doi.org/10.1126/science.aaf2654

- ↑ Марков А. (2018). Моральные проблемы беспилотных автомобилей не имеют универсального решения / Элементы, 29.10.2018 // https://elementy.ru/novosti_nauki/433355/Moralnye_problemy_bespilotnykh_avtomobiley_ne_imeyut_universalnogo_resheniya

- ↑ Awad E., Dsouza S., Kim R., Schulz J., Henrich J., Shariff A., Bonnefon J.-F., Rahwan I. (2018). The Moral Machine experiment / Nature, Vol. 563, pp. 59—64 // https://doi.org/10.1038/s41586-018-0637-6

- ↑ Марков А. (2018). Моральные проблемы беспилотных автомобилей не имеют универсального решения / Элементы, 29.10.18 // https://elementy.ru/novosti_nauki/433355/Moralnye_problemy_bespilotnykh_avtomobiley_ne_imeyut_universalnogo_resheniya

- ↑ McKinsey & Company (2023). The state of AI in 2023: Generative AI’s breakout year // https://www.mckinsey.com/capabilities/quantumblack/our-insights/the-state-of-ai-in-2023-generative-ais-breakout-year#/

- ↑ Tangermann V. (2023). Artists Sue Stable Diffusion and Midjourney for Using Their Work to Train AI That Steals Their Jobs / Futurism, Jan 18, 2023 // https://futurism.com/artists-sue-stabile-diffusion-midjourney

- ↑ Lee T. B. (2023). Stable Diffusion copyright lawsuits could be a legal earthquake for AI. / Ars Technica, 4/3/2023 // https://arstechnica.com/tech-policy/2023/04/stable-diffusion-copyright-lawsuits-could-be-a-legal-earthquake-for-ai/

- ↑ * DeviantArt — популярный сервис обмена изображениями и социальная сеть; в конце 2022 г. DeviantArt выпустил собственный генератор изображений DreamUp, основанный на модели Stable Diffusion.

- ↑ Franzen K. (2023). Midjourney, Stability AI and DeviantArt win a victory in copyright case by artists — but the fight continues / VentureBeat, October 30, 2023. // https://venturebeat.com/ai/midjourney-stability-ai-and-deviantart-win-a-victory-in-copyright-case-by-artists-but-the-fight-continues/

- ↑ Vincent J. (2022). YouTuber trains AI bot on 4chan’s pile o’ bile with entirely predictable results / The Verge, Jun 8, 2022 // https://www.theverge.com/2022/6/8/23159465/youtuber-ai-bot-pol-gpt-4chan-yannic-kilcher-ethics

- ↑ Papasavva A., Zannettou S., De Cristofaro E., Stringhini G., Blackburn J. (2020). Raiders of the Lost Kek: 3.5 Years of Augmented 4chan Posts from the Politically Incorrect Board // https://arxiv.org/abs/2001.07487

- ↑ Kurenkov A. (2022). Lessons from the GPT-4Chan Controversy. / The Gradient, 12.JUN.2022 // https://thegradient.pub/gpt-4chan-lessons/

- ↑ Condemning the deployment of GPT-4chan (2022). // https://docs.google.com/forms/d/e/1FAIpQLSdh3Pgh0sGrYtRihBu-GPN7FSQoODBLvF7dVAFLZk2iuMgoLw/viewform?fbzx=1650213417672418119

- ↑ Lin S., Hilton J., Evans O. (2021). TruthfulQA: Measuring How Models Mimic Human Falsehoods // https://arxiv.org/abs/2109.07958

- ↑ Kelley D. (2023). AI-Based Cybercrime Tools WormGPT and FraudGPT Could Be The Tip of the Iceberg. / SlashNext, August 1, 2023 // https://slashnext.com/blog/ai-based-cybercrime-tools-wormgpt-and-fraudgpt-could-be-the-tip-of-the-iceberg/

- ↑ Николич А. (2023). EVILdolly // https://huggingface.co/AlexWortega/EVILdolly